Привет, друзья. Тут недавно в Фейсбуке возникло обсуждение на тему постраничной навигации (пагинации) с целью сформировать какую-то единую точку зрения на то, что делать с такими страницами на сайте: как правильно их оформлять, открыть их для индексации или лучше закрывать. Если открывать, то что при этом надо учесть, уникализировать заголовки или оптимизировать каждую страницу. И вообще полезно ли держать эти страницы открытыми? А если закрывать, то каким именно способом: robots.txt, meta robots, canonical...

Привет, друзья. Тут недавно в Фейсбуке возникло обсуждение на тему постраничной навигации (пагинации) с целью сформировать какую-то единую точку зрения на то, что делать с такими страницами на сайте: как правильно их оформлять, открыть их для индексации или лучше закрывать. Если открывать, то что при этом надо учесть, уникализировать заголовки или оптимизировать каждую страницу. И вообще полезно ли держать эти страницы открытыми? А если закрывать, то каким именно способом: robots.txt, meta robots, canonical...

Вопросов очень много и, к сожалению, к единому мнению мы так и не пришли. Многое зависит от конкретной ситуации, от технических возможностей и материальных вложений в доработки.

Я же хочу рассмотреть все возможные варианты, их плюсы и минусы, а также предостеречь вас от очевидных ошибок, в которых разногласий быть не может.

Итак, пагинация – это постраничная навигация на страницах каталогов или категорий (смотря о каком типе сайта речь), и возникает она в том случае, когда все товары или другие элементы не помешаются на одной странице, и чтобы посмотреть следующий список элементов, приходится переходить на вторую страницу и далее. Уверен, каждый из вас это видел: пагинация есть на страницах поисковых систем, в интернет-магазинах, досках объявлений и т. д.

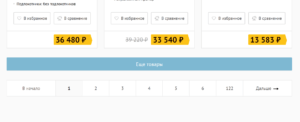

Вот пример блока со страницами навигации на моем блоге:

Пользователи к этому привыкли и не видят проблем в такой навигации, а вот для вебмастера не все так однозначно, потому что, если визуально это выглядит всегда одинаково, внутри может работать совершенно по-разному, следовательно, и поисковые роботы могут воспринимать это тоже по-разному.

Вот какие у нас есть варианты и соответствующие требования:

- Оставить страницы пагинации для индексации:

- Факты:

- Уникализировать title,

- Не дублировать seo-текст с первой страницы,

- Не дублировать главную страницу категории со страницей page/1/.

- Вопросы:

- Надо ли использовать атрибуты next/prev?

- Надо ли уникализировать h1?

- Что делать с description для пагинации?

- Факты:

- Закрыть пагинацию от поисковых систем:

- Способы:

- Закрыть в robots.txt,

- Закрыть мета-тегом robots,

- Использовать canonical.

- Вопросы:

- А может лучше использовать X-Robots Tag?

- Можно ли использовать несколько методов одновременно?

- Надо ли уникализировать закрытые от индексации страницы?

- Способы:

- Другие вопросы, связанные с пагинацией:

- На что влияет кнопка «Показать еще» и AJAX подгрузка контента?

- Важно ли наличие ЧПУ для страниц пагинации?

- Можно ли продвигать страницы пагинации?

- Сколько товаров выводить на странице?

Как видите, вариантов много, вопросов тоже достаточно. Я предлагаю все это подробно разобрать, в результате чего вы сможете выбрать подходящий для себя вариант. А если не сможете, то я обязательно поделюсь вариантом, который предпочитаю лично я.

Очень часто страницы пагинации становятся причиной появления дублей title у сайта. А это, как известно, нарушение, и не приветствуется поисковыми системами. Выявить наличие или отсутствие дублей заголовков вы можете любой программой-краулером, например, ComparseR. Хотя если страницы пагинации у вас закрыты от индексации, вы не увидите дубликатов при стандартных настройках программы, но их не увидит и робот ПС.

В последнее время проблем с дублями все меньше, потому что большинство свежих версий движков из коробки уникализируют заголовки, но, если у вас старая версия, провериться все же стоит.

Давайте разберем каждый из вариантов и ответим на вопрос: оставлять или закрывать страницы пагинации для индексации.

Оставить страницы пагинации в индексе

Лично мне нравится такой вариант больше всех, и я использую его на своих личных проектах.

И если мы решили оставить страницы пагинации, нам надо выполнить несколько важных условий:

- Надо уникализировать заголовок title у всех страниц пагинации. Первая страница, она же главная страница категории, будет иметь какой-то оптимизированный заголовок, например: «Купить холодильник в Краснодаре недорого – интернет-магазин Холодос». Тогда для всех последующих страниц, начиная со второй и далее, заголовок будет с приставкой « – страница X», вот так: «Купить холодильник в Краснодаре недорого – интернет-магазин Холодос – страница 2».

- Описанный выше вариант самый простой и распространенный. Но его можно модифицировать, чтобы стало еще лучше и красивее. Например, подставлять в title пагинаций не весь title целиком, а брать только название категории (часто это переменная, которая подставляется в H1), вот так: «Холодильники – страница 2». Я называю это деоптимизацией title. Это нужно, чтобы страницы пагинации никак не мешали первой странице категории, поэтому делаем заголовок неоптимизированным, менее релевантным.

- Если вдруг у нас есть в категории какое-то описание или seo текст, он не должен дублироваться, то есть его нельзя повторять на всех страницах, он должен оставаться только на главной странице категории.

- Нельзя допускать дублирования главной страницы категории по адресам типа

site.ru/category/holodolnikиsite.ru/category/holodolnik/page/1(илиsite.ru/category/holodolnik?page=1в зависимости от технических особенностей движка). Это решается 301 редиректом со страниц page/1 (page=1 и т.п.) на url без них.

Это действия, которые необходимо сделать если вы решили оставлять страницы пагинации в индексе.

Но есть и менее очевидные вещи, которые находятся под вопросом:

- Надо ли менять h1 на страницах пагинации? Вопрос интересный, но лично я этого не делаю, я дублирую на всех страницах навигации один и тот же заголовок (в отличие от дублирования title — это не есть нарушение). И в целом очень редко встречаю сайты, где в H1 добавляется приставка «- страница X». Это не хорошо и не плохо, можете делать так, как вам нравится.

- Надо ли использовать атрибуты <link rel="prev" href="..."/> и <link rel="next" href="..."/>? Раньше Google поддерживал эти теги и рекомендовал их использовать для страниц пагинации, но весной 2019 года внезапно сообщили, мол: «Мы упразднили атрибуты rel=prev/next, потому что исследования показали, что пользователи любят одностраничный контент».

Spring cleaning!

As we evaluated our indexing signals, we decided to retire rel=prev/next.

Studies show that users love single-page content, aim for that when possible, but multi-part is also fine for Google Search. Know and do what's best for *your* users!— Google Webmasters (@googlewmc) March 21, 2019

Это заявление не запрещает использовать данные директивы, но и поисковик их учитывать больше не будет.

Учитывая, что сама публикация, к которой оставлен данный комментарий, датирована 2015 годом и вопрос об next и prev там поднимался не раз, вряд ли что-то изменится когда-либо. Поэтому целенаправленно настраивать данные атрибуты не нужно, но и удалять, если ваш движок их выводит, нет смысла.

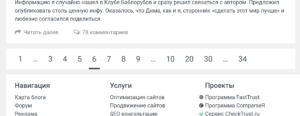

Что касается Яндекса, то он никогда и не поддерживал атрибуты next и prev, о чем свидетельствует комментарий Платона от 2018 года: - Последнее, с чем осталось разобраться, если мы решили оставить страницы пагинации открытыми для индексации – надо ли уникализировать метатег description? Лично я вообще удаляю этот метатег со страниц пагинации, чтобы его не было в коде. Как вариант – можно оставить его пустым. Еще один вариант – добавлять в него приставку «- страница X», как для title. Выбирайте то, что вам больше нравится, любой из этих вариантов приемлемый.

Теперь я объясню, почему я выбираю для себя вариант держать пагинацию открытой для поисковиков.

Чтобы не оставлять страницы товаров, которые находятся не на первой странице каталога, без ссылочных связей и не портить индексацию. Конечно, ссылки на товары могут встречаться в других категориях или фильтрах, появляться в перелинковке в блоке похожих товаров, но, как правило, это неконтролируемый процесс, поэтому какие-то товары могут остаться не у дел. Если оставить пагинацию открытой, то поисковый робот всегда сможет добраться до всех страниц и до всех товаров, которые у нас есть, так что вероятность, что товары будут выпадать из индекса из-за недостатка ссылочного веса, снижается.

Закрыть от индексации страницы пагинации

Данный вариант не плохой, сторонников его использования не меньше, чем первого (это как iOS vs. Android, Canon vs. Nikon и т. д.), поэтому и единого мнения на счет пагинации никогда не будет, в каждом методе есть свои преимущества.

И если вы решили закрыть страницы пагинации, у вас есть несколько способов:

- Закрыть индексацию страниц через robots.txt. Например, директивой

Disallow: */page/илиDisallow: /*page=(в зависимости от технической реализации в CMS). Это самый плохой способ избавиться от пагинаций, и я не рекомендую вам его использовать. Потому что тогда робот точно не будет заходить на закрытые страницы, карточки товаров в глубине каталога будут плохо индексироваться, а при всем при этом ссылки на страницы пагинации могут появляться в выдаче Google (он показывает в выдаче даже закрытые страницы, но с пометкой, что они закрыты). - Закрыть страницы при помощи <meta name="robots" content="noindex" />. Этот метод также закроет страницы от поисковиков, как и предыдущий, только Google уже не будет выводить ссылки на такие страницы, то есть все будет чисто. Но проблема с тем, что товары из глубины каталога будут страдать останется. Можно использовать сочетание директив

content="noindex,follow"при которых робот не будет добавлять страницы в индекс, но будет переходить по ссылкам, содержащимся на данных страницах, но проблему с товарами из глубины каталога это не решает. - Использовать rel="canonical" с указанием главной страницы категории для страниц пагинации. Это самый лучший вариант избавиться от пагинации в индексе. Если мы будем использовать канонический адрес, например,

<link rel="canonical" href="https://site.ru/category/holodolnik"/>на всех страницах пагинации, то поисковики будут заходить на все страницы, будут обходить ссылки на этих страницах, при этом сами страницы пагинации в индекс не попадут.

Вариант с использованием canonical является единственным приемлемым среди сторонников избавления от лишних страниц пагинации. Этим же вариантом чаще всего пользуются и ребята в нашей студии при работе с клиентскими сайтами.

У Яндекса есть публикация в блоге для вебмастеров от 29 декабря 2015 года «Несколько советов интернет-магазинам по настройкам индексирования» и в ней раздел «Что делать со страницами пагинации товаров», где рекомендуется использовать каноникал:

Если в какой-либо категории на вашем сайте находится большое количество товаров, могут появиться страницы пагинации (порядковой нумерации страниц), на которых собраны все товары данной категории. Если на такие страницы нет трафика из поисковых систем и их контент во многом идентичен, то советую настраивать атрибут rel="canonical" тега <link> на подобных страницах и делать страницы второй, третьей и дальнейшей нумерации неканоническими, а в качестве канонического (главного) адреса указывать первую страницу каталога, только она будет участвовать в результатах поиска.

Например, страница сайт.рф/ромашки/1 — каноническая, с неё начинается каталог, а страницы вида сайт.рф/ромашки/2 и сайт.рф/ромашки/3 — неканонические, в поиск их можно не включать. Это не только предотвратит возможное дублирование контента, но и позволит указать роботу, какая именно страница должна находиться в выдаче по запросам. При этом ссылки на товары, которые находятся на неканонических страницах, также будут известны индексирующему роботу.

Но не стоит забывать, что указание канонической страницы – это не строго правило, а лишь рекомендация для поискового робота. Если страницы полные дубли друг друга, то склейка неканонической страницы с канонической произойдет, а если есть различия, то поисковик сможет поступать так, как посчитает нужным, и результат будет непредсказуемым.

Так что в последнее время появляется все больше вопросов, когда неканонические страницы попадают в индекс и ранжируются. Подтверждением тому служит пост Яндекса «Неканонические страницы в Поиске»:

Часто на сайтах присутствуют страницы с разными URL, но с одинаковым или очень похожим содержанием. С помощью атрибута rel=«canonical» вебмастера могут указать, какая страница является «канонической» — предпочтительной для индексации и появления в результатах поиска. Остальные, неканонические версии как правило в поиск не попадают.

Наши исследования показывают, что страницы, размеченные как неканонические могут быть полезны, а их наличие в поиске может влиять на качество и полноту ответа на запрос пользователя.

…

В результате сайт не находится по запросу-цитате, соответствующей тексту за пределами первой странице. Поэтому теперь в поиске неканонические страницы будут появляться чаще.

Они будут показаны в том случае, если они более релевантны запросу и их контент существенно отличался от канонической версии во время сканирования роботом.

Несмотря на это, использование каноникала для страниц пагинации остается самым приемлемым вариантом для исключения их из индекса.

Есть и еще один метод закрыть страницы от индексации, который я не указал в своем списке выше – это заголовок X-Robots Tag. По результатам он полностью идентичен использованию метатега robots и имеет аналогичные директивы: noindex, nofollow, nosnippet и т. д., однако робот узнает о правилах не в момент посещения страницы и изучения ее кода, а на уровне ответа сервера, когда только идет обращение к url-адресу. Данный метод самый сложный в реализации и отслеживании, поэтому практически никто им не пользуется для решения задач, типа нашей.

Можно ли использовать несколько методов одновременно?

Нельзя! Каждый из перечисленных выше методов – robots.txt, meta robots, canonical, x-robots – исключают использование друг друга, а срабатывать будет более строгое правило.

Вот, что написано об этом в Google:

Метатеги robots и HTTP-заголовки X-Robots-Tag обнаруживаются при сканировании URL. Если сканирование страницы запрещено файлом robots.txt, то директивы, касающиеся индексирования или показа контента, будут проигнорированы. Чтобы обеспечить обязательное выполнение директив, не следует запрещать сканирование URL, для которых они заданы.

По аналогии: Если в коде одновременно будут meta robots noindex и canonical, то страница просто не будет индексироваться и дело до учета канонического адреса страницы не дойдет, так как meta robots – это правило, а canonical – всего лишь рекомендация.

Надо ли уникализировать закрытые от индексации страницы?

Не надо. В этом просто нет смысла. Если у страниц, которые вы запретили к индексации дублируются title заголовки, то нет смысла делать их уникальными, робот все равно не проиндексирует страницы, а значит не возникнет и проблем.

Если вы будете уникализировать страницы, которые хотите склеить с помощью canonical, то они станут еще более отличные друг от друга и вероятность того, что они не будут склеены, повышается. Так что не надо этого делать.

Пагинация на JS, кнопка «Показать еще» и AJAX подгрузка контента

Замена классической системы навигации с перечнем страниц 1, 2, 3 … N встречается часто, вместо нее может быть одна кнопка «Показать еще», «Еще товары», «Следующая страница» и т. д. Согласен, что это довольно удобно с точки зрения юзабилити, особенно при работе с мобильных устройств. Кроме того, скорость отдачи контента выше, ведь приходится загружать только блок с карточками товаров вместо перезагрузки все страницы, как это происходит при классической пагинации.

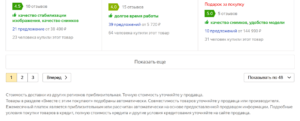

Не зря крупные сайты типа Яндекс.Маркета и других используют такую систему:

Но обратите внимание, что кроме кнопки «Еще» дублируется и классическая навигация по страницам.

Вот что сам Яндекс говорит на этот счет:

Часто вместо пагинации сайты используют динамическую прокрутку, когда для посетителя, пролиставшего каталог до определённого момента, с помощью JavaScripts загружаются другие товары в данной категории. В такой ситуации необходимо проследить, чтобы весь контент таких страниц отдавался индексирующему роботу (например, с помощью инструмента в Яндекс.Вебмастере), либо чтобы роботу становилась доступна статическая пагинация товаров.

То есть необходимо совмещать приятное (кнопка «Показать еще» для пользователя) и полезное (постраничная навигация для робота). Если же по какой-то причине классическая пагинация не вписывается в дизайн вашего сайта или есть другие причины ее не показывать, есть решение – оставить классическую пагинацию в коде страницы, а с помощью стилей “display:none” скрыть ее в дизайне. И все будут довольны :)

Важно ли наличие ЧПУ для страниц пагинации?

Нет. Не важно. На этот счет можно не заморачиваться и оставить все как есть, принципиальной разницы между:

site.ru/category/holodolnik/page/2

site.ru/category/holodolnik/?page=2

site.ru/category/holodolnik/?PAGEN_1=2 и т. д.

Нет никакой! Главное, чтобы и робот, и посетитель понимали, что это пагинация.

Можно ли продвигать страницы пагинации?

Технически можно, но вот нужно ли? В сети было несколько кейсов на этот счет, когда бралась какая-то категория магазина, кластер запросов для посадки на одну страницу был слишком большой и его разбивали на несколько кластеров и вели на страницы пагинации этой категории.

Мое мнение – это из разряда каких-то извращений или «а смотрите, как я могу!». Во-первых, технические заморочки, чтобы обеспечить на страницах навигации настройку уникальных title, h1 и seo-текста. Во-вторых, чем плохи подкатегории, тегирование и seo-фильтры? Ничем не хуже, они даже лучше, так как более предсказуемы по содержанию и лучше отвечают на запросы пользователя, который попадает на главную страницу подкатегории/фильтра, а не на энную страницу общей категории.

Сколько товаров выводить на странице?

Вопрос и относится, и не относится к теме одновременно. Главным аргументом в данном вопросе будут результаты проведения коммерческого аудита сайта и сравнение с конкурентами. Можно изучить конкурентов по своим ВЧ-запросам из топа и посмотреть, сколько товаров на странице выводят они. Чтобы сильно долго не думать, можно взять медианное значение.

Все вышесказанное относится не только к интернет-магазинам, на примере которых я вам рассказывал, но и к каталогам, доскам объявлений, агрегаторам, порталам и т. д., даже к информационным сайтам. Везде, где есть пагинация – данная информация будет применима!

На этом все, друзья. Если у вас остались какие-то вопросы, задавайте их в комментариях.

До связи!

Спасибо!

Я бы не утверждал так категорично, что атрибут canonical является лучшим вариантом. После недавнего апдейта яндекса любые страницы с канониклом могу попадать в поисковую выдачу, в зависимости от того, насколько отличается содержимое неканонической страницы от канонической, а у пагинации содержимое всегда отличается.

Я вообще за то, чтобы открыть пагинацию для индексации.

Я сказал, что он самый приемлемый, а не лучший, и порекомендовал не уникализировать страницы, если собираемся делать каноникал. Но за ситуацией, действительно, надо следить, будут ли попадать в индекс страницы пагинации. Пока что я не вижу причин, чтобы Яндекс посчитал страницы пагинации более релевантными запросу, чем главная страница категории. Яндекс же приводил в пример ветки обсуждения на форумах, где страницы обсуждений на второй и последующих страницах указывали каноникалом на главную страницу ветки, там действительно разный тестовый контент, в отличие от страниц пагинации товаров.

Всегда для страниц пагинации использую rel="canonical" на информационных сайтах. Самое оптимальное решение.

Спасибо за статью. Если следовать варианту "Оставить страницы пагинации в индексе"

1. Нужно ли на 2-3-4-5- ... указывать canonical на основную страницу категории?

2. Canonical не нужен?

3. Canonical должен вести на себя? (?page=2,?page=3,?page=4)

Если оставлять страницы в индексе, то каноникал не надо использовать вообще, либо ставить на себя.

Александр, спасибо за пост!

Полагаю, что единственный минус открытия страниц пагинации — это расход краулингового бюджета. Если важно его сохранить и потратить на другие важные страницы, то пагинацию стоит закрыть.

Я о том, что каждую ситуацию следует рассматривать индивидуально, а не штамповать одно решение на всех сайтах.

Все верно, но. Понятно, что это расход бюджета, но а как же индексация товаров на дальних страницах? Не думаю, что может быть какая-то такая структура подкатегорий или seo-фильтров, чтобы любой товар хотя бы раз попадал на первую страницу каталога.

Соглашусь, что неправильное использование пагинации ведет к возникновению ряда проблем для сайта. Неправильная настройка приведет к снижению сканирования глубины. Робот может просто не дойти до нужной позиции, потому что она находится на нижнем уровне. Или дублируемый контент. Чаще всего лучшим решением станет применение золотой середины в работе с оптимизацией пагинации, иначе ресурс рискует потерять позиции в результатах поисковиков. Для себя все же отметил пару моментов. Спасибо за статью

Не соглашусь с тем что дубль h1 никак не влияет. Заголовки должны быть уникальными, не должно быть 2 одинаковых заголовка тем более 1 уровня.

В чем заключается проблема наличия нескольких одинаковых h1 заголовков на разных страницах?

Спасибо за статью! Очень нужная и полезная инфа.

Может кто знает, как в DLE сделать требуемый canonical для страниц категорий? Погуглил и не нашел нужного технического решения(

Думаю проще всего ответить на вопрос — "Как правильно" — это зайти на auto.ru или beru.ru или market.yandex.ru и посмотреть как у них сделано.

Думаю специалисты Яндекса, свой проект оптимизируют максимально правильно с точки зрения Яндекса.

Итого:

На сайтах Яндекса закрывают нумерацию через Canonical.

На auto.ru ещё и делают уникальными, вероятно для того, чтобы при проверке ошибок не было.

Title (97): Кузовные запчасти купить, цены на кузовные запчасти, описание фото на сайте Авто.ру – страница 2.

Description (149): Кузовные запчасти продажа по низким ценам. Большой выбор в каталоге автозапчастей, описание, фотографии, гарантия и доставка на Авто.ру – страница 2.

H1: Кузовные запчасти

H3: Производители || Производители || Производители || Производители || Производители || Производители

Canonical: https://auto.ru/parts/kuzovnye-zapchasti/

Title (91): Купить Встраиваемые варочные панели по низким ценам в интернет-магазинах — маркетплейс Беру

Description (174): Встраиваемые варочные панели — купить в маркетплейсе Беру. Выбор товаров из категории Встраиваемые варочные панели по характеристикам, описанию и отзывам с удобной доставкой.

H1: Встраиваемые варочные панели

Canonical: https://beru.ru/catalog/vstraivaemye-varochnye-paneli/79912/list

>> Думаю специалисты Яндекса, свой проект оптимизируют максимально правильно с точки зрения Яндекса.

Вообще не так. Каждым проектом занимается отдельная команда, никак не связанная с Яндексом (ну, разве что только наличием в названии слова "Яндекс", и то не всегда). Не спрашивайте, откуда я это знаю. Вполне вероятно, что на проекты привлекаются сторонние подрядчики на SEO, которые и выбирают методы работы.

Безусловно, подрядчики на такие проекты выбираются из числа лучших, но их решения и методы оптимизации никак не согласованы с отделом качества поиска или что-то в этом духе.

Проекты Яндекса заморачиваются над сео? Думаете это им нужно? Просто есть стандарты, страница 2, значит страница 2. Ни гугл проекты, ни яндекса, не нуждаются в сео, сео это правило по которым эти ребята позволяют обычным обывателям войти как бы в их ряды, получив кусочек трафика. Свои же проекты они делают по схемам: быстро, удобно, понятно, никакое сео и тп им вовсе не нужно. Десять дублей, двадцать, это совсем не важно, если это будет нужно во благо удобства пользавателям, эти дубли будут. Поэтому, не стоит ровняться по их проектам, лучше ровняйтесь по топам, которые никакого отношения к их брендам, отношения не имеют. Авито в топе не потому что он супер оптимизирован и тд., а потому что это их проект, пока он актуален, он будет всегда в топе, хоть весь js код в шапку впихни, хоть миллион дублей сделай.

>> Проекты Яндекса заморачиваются над сео? Думаете это им нужно?

Я не думаю, я точно это знаю. Потому что они обращались ко мне за этой услугой.

Отличная статья, побольше бы таких, с толком и расстановкой.

Спасибо большое Вам!

Спасибо за статью. Есть на большие противоречия, но возможно вы уже не работаете с этим проектом, кейс которого вы как то описывали на vc.ru . И страницы пагинации с canonical + прописаны content="noindex,follow" , это для чего так сделано, совместное использование или вы имели ввиду совместно использовать noindex,nofollow + canonical ?

Это действительно нелогично. И я бы принял эту странность на свой счет, но всегда есть нюансы:

— клиент не всегда делает то, что просишь,

— у всех правок есть своя степень важности или приоритет,

— у каждого есть свое мнение, и коллеги не обязаны всегда и во всем следовать моим инструкциям,

Это было абстрактное объяснение, а более конкретное:

— У сайта сотни страниц пагинации после нового алгоритма обработки каноникала полезли в индекс и начали ранжироваться. Пришлось добавить noindex, follow.

Спасибо! Но как насчет страниц с комментариями. Если к посту скажем 800 комментариев, при этом есть разбивка на страницы по 60 штук. То надо закрывать пагинацию по комментариям от индексации?

Сложно сказать, я для себя до сих пор не пришел к какому-то решению. Потому вывожу все комментарии на одну страницу, у меня есть посты, где 1000+ комментариев и все равно они выводятся все вместе без пагинации. Это мой личный выбор, но рекомендовать всем делать точно так же не стану, ведь кому-то это может не понравиться.

Cпасибо за ответ! А на вашем блоге пагинация скрыта, но при этом вы пишите, что открываете для индексации на своих проектах.

После обновления All in One SEO не получается открыть, не работает. Я очень расстроен на этот счет, и пока не решил эту проблему.

Скажите пожалуйста, при использовании способа "Показать еще", индексируется ли контент, находящийся в скрытом состоянии, и имеет ли смысл об этом задумываться?

В каком скрытом состоянии? Зависит от того, как происходит подгрузка. Как правило "загрузить еще" инициирует подгрузку контента скриптом, так что для поисковика там ссылки нет, соответственно, на страницы пагинации он не переходит.

Здравствуйте Алаичъ! Подскажите, как быть по такой сортировке и пагинации.

Есть раздел с видео

Собственно сама пагинация

Сортировка типа "часто просматриваемые", "топовые" и дальнейшая пагинация в рамках этой сортировки

Для пагинации считаю самым правильным Ваш вариант: деоптимизировать title и добавлять "- страница 2" к тайтлу и дескрипшн + ссылаться как на каноническую на корневой раздел Видео.

Сортировка "часто просматриваемые", "топовые" тоже пожалуй не имеет смысл оптимизировать. С тайтлом понятно: будет деоптимизированным типа просто "Топовые видео". А с дескрипшеном в этой ситуации как лучше поступить, так как если просто подставлять "- страница 2" — будет дублирование аналогичного дескрипшен при стандартной пагинации? Да и для первой страницы тоже нужно что-то с дескрипшен сделать чтобы не было дублирования с корневой без сортировки.

Привет. У тебя верный план, только вот каноникал я бы не проставлял на главную страницу категории, либо ставил сам на себя. Таким образом топовые (не знаю, в чем отличие от часто просматриваемых) видео будут на наименьшем расстоянии от главной (по количеству кликов или переходов, если так понятнее).

Деоптимизируй title для страниц пагинации, а description для них можешь вообще не заполнять, если возникли проблемы, либо добавить туда номер страницы.

Спасибо за ответ!

1. Топовые отличаются от часто просматриваемых тем, что их по максимуму лайкали пользователи, т.е. это все-таки разные видео. Так как часто просматриваемыми могут быть и случайно если их гугл "полюбил".

2. "только вот каноникал я бы не проставлял на главную страницу категории, либо ставил сам на себя"

— Вы имеете ввиду вообще нигде не ставить, в том числе на стр. пагинации для дефолтной .com/videos/? Или только для корневых ".com/videos/" + "часто просматриваемые" (.com/videos/most-viewed) — "топовые" (.com/videos/top-rated) не ставить, а на остальных начинаю со второй страницы ставить на корневую своей сортировки?

3. Как все-таки лучше поступить с корневыми страницами этих сортировок "часто просматриваемые" (.com/videos/most-viewed) — "топовые" (.com/videos/top-rated)? Деоптимизировать или есть смысл попробовать оптимизировать?

Там просто есть еще сортировка по тегам типа "смешные животные", "милые котики", по которым точно делается оптимизация, но + все та же "часто просматриваемые" — "топовые" в рамках выбранного тега, т.е. вывод по ссылке типа .com/videos/tags/sweet-cats/top-rated/. В случае с тегами делать оптимизацию на "часто просматриваемых" — "топовых" в рамках тега явно перебор, а вот для всех видео без сортировки по тегу — не знаю...

Слишком много условий, да и проекта я не видел.

Тогда попробую ответить проще. Все страницы категорий, которые ты оптимизируешь, включая подборки, оставляй для индексации, страницы пагинации тоже оставь для индексации (деоптимизируй title и НЕ ставь каноникал). Теги типа "смешные животные" и "милые котики" тоже оставь для индексации, и страницы пагинации в них тоже оставь (но страницы сортировок внутри тегов, а также подборки "часто просматриваемые" и "топовые" можешь не индексировать — например, установить каноникал на основную страницу тега).

Все это звучит сложновато даже на словах. Но, надеюсь, ты понял.

"Все это звучит сложновато даже на словах. Но, надеюсь, ты понял."

— Отлично звучит) Все понял — спасибо огромное!

Четко! Напиши потом, что и как получится сделать, мне интересно!

Был установлен canonical на главные страницы каталога. Но после внесения этих изменений — главная страница каталога пропала из поиска гугл, заместо нее стало много страниц пагинации (которые не так не ранжируются).

Что делать в таком случае?

Я бы открыл страницы пагинации для индексации, учитывая рекомендации описанные в посте.

С canonical уже не все так классно, как было во время написания поста, я бы не стал полагаться на canonical теперь, особенно для Гугла.

Google убрал основные страницы из поиска, произошла просадка по трафику. Но страницы с пагинацией присутствуют в поиске, и разумеется далеко не на тех позициях, на которых были основные страницы что были.

Возможно проблема в том что у страниц пагинации слишком уникальные мета-теги. Например: "Страница 2 >>" — добавляется в начале, а не в конце.

Или Google просто глючит. Но не верится в это.