Привет, друзья. После недавнего переезда в Краснодар я вышел на новую работу, где мне поручили большой проект – это сервис по аренде жилья. Сайт ко мне попал в плачевном состоянии: куча дублей страниц, еще больше дублей title, битые ссылки, наследство от смены структуры после старого сайта и еще много-много чего. Короче, целый вагон проблем и косяков. И поставили передо мной большую задачу – сделать так, чтобы сайт находился в топе по всем интересующим запросам и приносил как можно больше трафика.

Привет, друзья. После недавнего переезда в Краснодар я вышел на новую работу, где мне поручили большой проект – это сервис по аренде жилья. Сайт ко мне попал в плачевном состоянии: куча дублей страниц, еще больше дублей title, битые ссылки, наследство от смены структуры после старого сайта и еще много-много чего. Короче, целый вагон проблем и косяков. И поставили передо мной большую задачу – сделать так, чтобы сайт находился в топе по всем интересующим запросам и приносил как можно больше трафика.

Задача совершенно стандартная, но вот путь к ее решению всегда нетривиальный и похож на квест. Именно поэтому я был рад сменить свое старое комфортное и непыльное место работы на пусть и некомфортное, но зато новое и интересное.

В соцсетях и в комментариях к посту вы меня просили поделиться процессом совершенствования сайта и полученными результатами. Изначально я и сам планировал подробно рассказать об этом, но тем приятнее мне будет писать, зная, что вы этого ждете. Надеюсь, это будет интересно и полезно, а какие-то нестандартные решения вы даже примените на своей практике.

Описание проекта и особенности

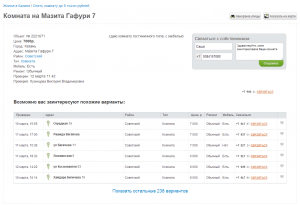

SelimS.ru – это сервис, занимающийся сдачей жилой недвижимости в аренду от собственников. На самом деле, бизнес не завязан на сайте — сайт это представительство в сети, и просто еще один источник прибыли. Основной бизнес — офлайн — это офисы в городах, куда приходят клиенты и заказывают услуги. А на сайте можно купить доступ к базе, заплатив, разумеется, меньше, но тогда и делать придется все самому – обзванивать хозяев, договариваться о встрече, ехать и смотреть квартиры, заключать договор и т.д. В то время как все это могут сделать за вас менеджеры, если обратитесь в офис. Но речь не об этом, тут не рекламная пауза, я просто хочу, чтобы вы поняли специфику самого проекта.

Другими словами, сайт — это база данных с платным доступом к ключевой информации (номер телефона собственника). Моя цель – увеличить количество продаж с помощью привлечения наибольшего количества трафика с поисковых систем. При этом под продажами подразумевается в первую очередь не доступ к базе сайта, но заказ услуг по телефону – посетитель оставляет заявку с сайта, а далее ему звонит менеджер и «обрабатывает». Хотя на моем собеседовании перед принятием на работу речь шла о том, что цели увеличения продаж нет, а есть цель просто быть в топе, чтобы примелькаться пользователям, быть всегда на виду, стать узнаваемыми и т.д.

Дальше я подробно расскажу, каким ко мне в руки попал сайт, что я делал, и какой результат получил. Не знаю, будет ли этот пост единственным о моем проекте или это лишь первая часть в длинной истории успеха – время покажет. А сейчас на календаре март, и это значит, что прошло уже около 4 месяцев с момента начала работ над сайтом.

Основная работа велась внутри сайта, сделано там было даже чуть больше чем дофига – сайт в ноябре и сайт сейчас – это почти два разных сайта. Я начну с того, что подниму кипу файлов с моими аудитами и тех. заданиями для программистов, а самые распространенные ошибки и интересные случаи рассмотрю подробно ниже.

Контент сайта, его кластеризация и индексация. Создание лэндингов

Одной из основных сложностей большого сайта является массовая генерация качественных точек входа (лендингов) и последующая их полная индексация. Это, пожалуй, ключевая задача оптимизатора.

Специфика нашего портала такова, что сайт обновляется в реальном времени – адреса страниц остаются постоянными, но контент на них меняется. Основные страницы списка объектов по городам примерно раз в 60 минут полностью меняют свой контент, пример такой страницы — http://selims.ru/arenda/Sochi/. Связано это с тем, что наиболее актуальные объекты, которые только что были проверены менеджером, поднимаются на самый верх, какие-то другие объекты помечаются как сданные, еще и параллельно в базу добавляются новые объекты.

Пока поисковик зайдет на сайт, получит свежие данные и выложит в индекс, эти данные уже устареют :( Это свойственно вообще всем листингам на сайте. Кстати, о листингах. Сайт о недвижимости это пример каталога, в котором наиболее ценны именно станицы фильтров-листингов, а не карточки объектов. Как я уже показывал выше на примере Сочи, основные точки входа – это выборка всех объектов по конкретному городу.

Статистика (точки входа, данные за период 1 февраля – 28 февраля):

Страницы главных листингов по городам суммарно привели ~45 000 человек (~28% от общего кол-ва трафика с ПС).

Пример страницы: http://selims.ru/arenda/Sochi/

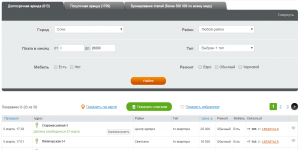

Но все остальные фильтры по типу объектов, району, цене и другим характеристикам выбираются пользователем в форме поиска и динамически меняют содержимое. Поисковые роботы не умеют пользоваться формами, а, следовательно, и индексировать результаты. Листинги по типу недвижимости – снять однокомнатную квартиру, комнату, частный дом, общежитие и т.д. – частотность таких запросов по городам относительно невелика, но в сумме получается огромный кластер! Для индексации таких выборок специально создан блок ссылок внизу «Я хочу снять»:

Эти ссылки позволили за несколько апдейтов проиндексировать выборки по типам объектов для всех городов. Может быть, эти ссылки даже окажутся полезны и реальным посетителям сайта (жалко, что мне не позволили добавить этот блок ссылок наверх, тогда ими бы точно пользовались).

Статистика (точки входа, данные за период 1 февраля – 28 февраля):

Страницы листингов по типам недвижимости суммарно привели ~30 000 посетителей (~18% от общего кол-ва трафика с ПС).

Пример страницы: http://selims.ru/arenda/Sochi/t17_komnaty

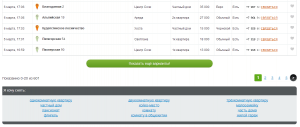

Если перейти по одной из ссылок в блоке, например, на однокомнатную квартиру, то можно найти аналогичный блок ссылок внизу, только он уже будет отвечать за еще более узкую выборку:

К дроблению по ценам в рамках определенных типов недвижимости я пришел в процессе изучения запросов пользователей. Редко, но все же люди интересуются — «снять однокомнатную квартиру 20000». Такое поведение свойственно далеко не для всех типов недвижимости, поэтому ссылки выводятся не везде, а так же для каждого типа рамки по ценам индивидуальные и задаются вручную.

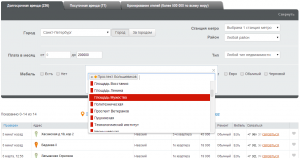

Для некоторых городов (Москва, Питер) в форме появляются дополнительные критерии поиска. Например, выбор района в городе и за городом, а так же выбор станции метро:

Помимо изучения имеющегося спроса на поиск недвижимости около определенных станций метро при помощи wordstat’а, пришлось пообщаться с питерскими друзьями и выяснить, а как же они ищут недвижимость и чем руководствуются. Выяснилось, что сначала определяется желаемый район проживания, а потом уже идет ориентир на станцию метро. Отлично – ценная информация.

Поэтому, когда мы вбираем какой-то район в городе с метро, внизу появляется блок ссылок, где отображаются станции метро, территориально расположенные в выбранном районе.

Полезно и для индексации дополнительных страниц и для пользователей. Этих страниц раньше не было, и мы их сделали.

Статистика (точки входа, данные за период 1 февраля – 28 февраля):

Страницы листингов по метро для Санкт-Петербурга привели ~300 человек (~0,2% от общего кол-ва трафика с ПС).

Пример страницы: http://selims.ru/arenda/Peterburg/m245

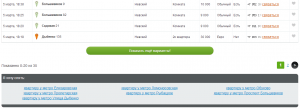

Метро есть далеко не во всех городах, зато везде есть территориальное дробление по районам – думаю, многие люди ищут жилье с привязкой к району. В случае с районами, было решено не использовать аналогичные блоки ссылок под списком объектов. Да и районов в городах обычно очень много, тогда и блок ссылок с ними больше выглядел бы как спам. Как мы реализовали индексацию страниц по районам, я расскажу чуть ниже, а пока просто сводная статистика.

Статистика (точки входа, данные за период 1 февраля – 28 февраля):

Страницы листингов по районам во всех городах привлекли ~2 000 посетителей (~1% от общего кол-ва трафика с ПС).

Пример страницы: http://selims.ru/arenda/Krasnodar/d202

Неизменными на сайте остаются только страницы самих объектов (я их называю карточки объектов). Однако они имеют статус сдано/не сдано, и тут был сделан интересный и очень важный ход. Раньше, когда объект переходил в статус «сдан», все описание со страницы удалялось и заменялось надписью «извините, объект сдан». Объектов в базе (для каждого есть свой уникальный url) более 360 000 – и, представьте себе, по статистике всегда более 97% всех объектов сданы. Сотни тысяч полупустых страниц дублей – это не очень круто! Когда я впервые проанализировал сайт, в индексе Google было около 10к страниц, в Яндексе столько же, большую часть из которых составлял как раз дубли.

Первое, что было сделано в этом направлении – мы перестали убирать контент со страницы, когда объект получал статус «сдан». Стали накладывать на описание эффект размытия (blur, но почему-то работает только в Хроме), а надпись «Извините, объект сдан» стали выводить «по-хитрому» – картинкой – чтобы не создавать лишнего дублирующего контента.

Некоторые описания объектов не очень многословны, например, «сдам комнату без мебели» и адрес в заголовке. И все. В первую очередь для удобства пользователей, но, не забывая и про поисковики, мы добавили блок с самыми важными характеристиками объекта.

И пользователю удобно сразу видеть структурированную информацию, и поисковик получит немного контента. А помните, я говорил про районы выше, что нет отдельных блоков, где выводятся ссылки на листинги по районам? Так вот ссылки на районы выводятся в карточках объектов, благодаря чему они тоже неплохо индексируются.

Важной частью каждой карточки объекта является блок ссылок внизу. Изначально я хотел реализовать там кольцевую перелинковку, чтобы по цепочке поисковик смог быстро проиндексировать все объекты на сайте. Но с точки зрения полезности блока и этой информации для пользователя получался полный бред, поэтому было решено выводить список похожих объектов по определенному алгоритму.

Давайте обратимся, наконец, к статистике по карточкам объектов.

Статистика (точки входа, данные за период 1 февраля – 28 февраля):

Страницы карточек объектов суммарно привлекли ~14 000 посетителей (~8,5% от общего кол-ва трафика с ПС).

При этом: точек входа ~9400, уникальных ключевых запросов ~13000.

Совсем неплохой трафик. Количество точек входа и запросов я упомянул здесь не просто так! Можно сказать, что на карточки объектов переходят по уникальным запросам, которые нельзя заранее предсказать и узнать, эти запросы вряд ли когда-нибудь кто-нибудь еще раз введет. Не надо быть крутым аналитиком, чтобы заметить зависимость количества переходов от количества страниц объектов в индексе.

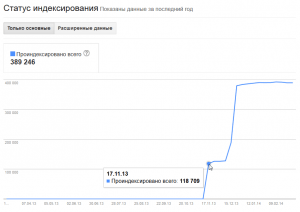

Итак, напомню, что когда я пришел в SelimS, в индексе было менее 3% от всех страниц, и были это в основном страницы листингов по городам, их дубли и их страницы пагинации, а карточек объектов практически не было. Для индексации листингов создавались специальные блоки ссылок. А вот карточки объектов после добавления контента надо было еще заставить проиндексировать. Для этого была создана xml-карта сайта, и не одна, а сразу несколько десятков, чтобы указать там все три с половиной сотни тысяч адресов.

Все карты сайта сразу же были отправлены в панели вебмастера – на следующий же день Google проиндексировал пачку из 118 000 страниц, а через месяц проиндексировал вторым подходом еще пачку, итого в сумме теперь почти 400 тысяч страниц в индексе.

С Яндексом все сложнее и медленнее – в панели вебмастера написано, что загружено 304к страниц, проиндексировано 25к страниц, хотя запрос host:selims.ru дает ответ, что в индексе 56 тысячи страниц. И это прошло уже 4 месяца! Но тут нечему удивляться, Яндекс очень слаб на быструю индексацию, потому и я чудес не жду.

А еще совсем недавно мы создали html-карту сайта — http://selims.ru/map-objects/ — где все объекты из базы выводятся в виде дерева. Я делал это в надежде повлиять на более быструю индексацию сайта Яндексом, вот и посмотрим, что это даст.

Внутренняя оптимизация сайта, технические моменты

Описанная выше работа является самой важной непосредственной задачей seo-специалиста, но давайте уже поговорим про техническую сторону дела, так же относящуюся к компетенциям сеошника.

Очень распространенная проблема среди больших каталогов и интернет магазинов – категории и/или конечные страницы доступны по адресам со слешем на конце и без него. Так сложилось, что у нас на сайте url’ы страниц не имеют окончаний. Например, в меню сверху выбор города вел на url без слеша, а на главной странице и в форме поиска формировался url со слешем. И в итоге возникало у нас по две одинаковые страницы.

Было решено бороться с дублями не с помощью 301 редиректа, как я всегда раньше делал, а используя метатег rel=canonical. Рискованный шаг, учитывая, что полной уверенности в успехе у меня не было, но был ряд причин пойти этим путем. О том, что это за мета-тег такой, как его использовать, как он работает и работает ли, я уже писал в посте — rel=“canonical” как эффективный способ борьбы с дублями. Ранее метод был экспериментально проверен, но ничто не заменит реальный опыт в боевых условиях. И вот теперь я с уверенностью могу сказать – да, действительно, rel=canonical работает и прекрасно справляется с дублями. Конечно, все внутренние ссылки на неканонические страницы поправили, чтобы вели на правильные адреса.

Не отходя далеко от проблемы дублирования контента страниц, стоит сказать про различные параметры – это классика жанра. Когда параметры динамически формируются, то их последовательность в url может меняться, если параметров более одного, следовательно, одна и та же страница будет доступна по всем вариациям подстановок параметров в url. Вот и у нас было на сайте каждой страницы листинга по 2—3 дубля стабильно. Проблему решали так же с помощью rel=canonical.

У меня часто спрашивают, а что делать со страницами пагинации (постраничная навигация по спискам и каталогам) – оставить в покое или закрыть от индексации? Универсального решения для всех сайтов нет и быть не может. Но на рассматриваемом сайте мы поставили на всех страницах тег rel=canonical с указанием на первую страницу. А чтобы поисковики не шастали по неканоническим страницам, ссылки на сами страницы сделали через AJAX, т.е. как таковых ссылок на странице теперь нет, а переключение происходит с помощью JavaScript. Сделано это потому, что страницы навигации одновременно разные и одновременно одинаковые (я уже говорил, что контент на них меняется примерно раз в час), так что достаточно и одной.

Я вообще настоял на том, чтобы все ссылки на ненужные для поисковиков страницы скрыть от роботов, например, это ссылки сортировки результатов в таблице поиска. Робот будет ходить только по нужным страницам, а значит и индексировать сайт быстрее. Я уже однажды рассказывал вам про 5 способов скрыть любую ссылку от индексации, методы до сих пор работают, можете пользоваться.

URL карточек объектов в системе формируются динамически, берутся первые XX символов описания объекта, переводятся в транслит, а в конце просто подставляется ID. Так вот когда описание объекта менялось, например, менеджером, то возникал новый url для прежнего объекта. Таким образом, дублей теоретически может быть любое количество. Это было предотвращено путем отслеживания ID и 301 редиректа на правильный url в случае несоответствия запрашиваемого адреса.

Помимо дублей самих карточек объектов, было много дублей title, что тоже не есть хорошо. Хоть и разные объекты, но они бывают расположены по одному адресу, в результате чего случался дубль. Я применил совершенно стандартное, как мне кажется, решение – добавлять в конец title номер (ID) объекта. Это решение я часто рекомендую клиентам с большими каталогами и интернет магазинами.

Отдельная история была с мобильной версией, расположенной на поддомене m.selims.ru. На мобильной версии тоже был каталог объектов и дублировался с основным сайтом. Так как мобильную версию нельзя удалить или редиректить, я решил не изобретать велосипед и поставить везде rel=”canonical” на соответствующие страницы основного сайта. Но я совсем забыл о том, что кроссдоменно (т.е. с одного домена на другой) каноникал не работает и не склеит страницы. Вспомнил я об этом, когда мобильная версия даже после переиндексации продолжала находиться в индексе. Пришлось закрыть весь поддомен от индексации мета тегом robots.

На блоге я уже писал о том, почему стоит использовать именно мета тег, а не robots.txt.

Вообще на сайте было проделано невероятно много технической работы, исправлено несчетное количество ошибок и багов. Так же не забываем, что это совершенно нормальная ситуация, когда программист, исправляя одно, попутно ломает другое :)

Обо всех ошибках я рассказать просто не смогу, да и вам это не надо. Главное знать, где эти самые ошибки искать! При работе с любым сайтом обязательно пользуйтесь панелями вебмастера Яндекса и Google, всю самую важную информацию и критические ошибки можно узнать оттуда. Очень рекомендую просматривать вручную индекс сайта в поисковиках, банально вводите запрос site:http://site.ru и просматриваете пару десятков страниц, и если не найдете никаких ошибок, то точно придумаете как можно улучшить сниппет! Сканируйте хотя бы раз в месяц сайт такими программами, как Page Weight, Xenu's Link Sleuth, Screaming Frog SEO Spider и др.

Аналитика и SEO <–> SEO и аналитика

Когда я пришел в проект, никаких данных по сайту у меня не было. Банально не было даже Яндекс Метрики и Google Analytics, был только LiveInternet, но его аналитические способности, можно сказать, нулевые. Счетчики я, конечно, установил сразу же, но чтобы что-то анализировать, надо иметь хоть какие-то данные, а их не было.

Когда я занимался созданием лендингов, оптимизацией контента и составлением заголовков, мне приходилось опираться на данные wordstat’а и смотреть конкурентов по выдаче.

Максимум внимания было нацелено на заголовки Title, как на самый «сильный» элемент каждой страницы. В первый раз все строилось на уровне гипотез. Спустя полмесяца я изучил данные статистики и поменял заголовки, появились какие-то новые запросы, я узнал, какие запросы работают лучше или хуже.

Спустя еще месяц я повторил разбор статистики и снова все поменял, дополнив и улучшив. И так за эти 4 месяца случилось раз пять. С каждой итерацией я постепенно улучшал характеристики целевых страниц на сайте: менял title и заголовки H1, работал с внутренними ссылками и т.д. В результате таких изменений позиции сайта в поисковых системах улучшались, и рос трафик. Наглядно я это покажу в разделе результатов чуть ниже.

Очень важно и нужно пользоваться системами аналитики. Я люблю Google Analytics благодаря его практически безграничным возможностям, правда и разобраться в нем новичку так же безгранично сложно :) Более подробно о том, как я работаю с аналитикой, я писал в посте про трафиковое продвижение сайта при помощи Google Analytics. Правда чтобы анализировать не штучные страницы, а целые массивы, придется подружиться с регулярными выражениями. Об этом я тоже когда-нибудь напишу пост.

Вместе с ростом позиций и появлением сайта в результатах органической выдачи появилась потребность сделать сниппет более привлекательным для людей. В первую очередь на ум приходит мысль о description – так и есть. Зная наиболее популярные запросы, по которым целевые страницы находят пользователи, я органично вписал эти запросы в одно предложение и даже сделал его немного рекламным. Вот так, например, https://yandex.ru/yandsearch?...

Теперь по самым популярным запросам пользователи увидят нужный мне сниппет, и не только в Google (где, как известно, вероятность появления в сниппете текста из description достаточно велика), но и в Яндексе. При составлении я руководствовался тем, что важно не разбивать пассажи и желательно использовать возможные вариации ключевых запросов в одном предложении. Из знаков препинания я использовал только запятую, она не разбивает пассажи.

В довесок, чтобы «добить», сделали микроразметку хлебных крошек под Гугл. Дополнительный привлекающий внимание элемент в выдаче еще никому не помешал! Вот так, например, https://www.google.ru/search?...

Для Яндекса такая схема не работает, но после переработки и улучшения структуры, а так же внутренних ссылок удалось добиться того, что и в Яндексе появились хлебные крошки на выдаче.

Да, и возвращаясь к Яндексу и метатегу description хотелось бы вспомнить, что пришлось закрыть все неосновные блоки сайта в тег <noindex>, уж очень Яндексу нравилось в сниппет тянуть всякие списки и элементы навигации, особенно названия городов. Так что, каким бы неоднозначным данный тег не был, иногда он бывает полезным! После noindex’а вероятность появления в качестве сниппета именно текста из description выросла существенно.

Можно также вспомнить и заголовки H1, но работа над ними еще пока идет, я аккумулирую данные по пулу низкочастотных запросов, чтобы проработать некоторые листинги на сайте. Знаю, что многих интересует вопрос, а хорошо это или плохо, когда title и h1 дублируются или совпадают? Однозначного ответа нет, но у меня они разные по той причине, что самые ценные запросы я использую в title, а чуть менее значимые стараюсь упомянуть в h1, но это чтобы захватить все нужные мне запросы. А на данном блоге, например, title и h1 дублируются – и ничего страшного!

Отдельной истории заслуживает принцип генерации хлебных крошек, там заложены определенные алгоритмы, и в зависимости от характеристик просматриваемой карточки объекта формируется ссылка на листинг, которая, во-первых, информативна и полезна для пользователя, если он решит искать похожие объекты, а во-вторых, полезна для индексации определенных листингов и передачи на них статического веса. Так же и title для карточек объектов формируется с динамическими приставками перед и после названия самого объекта. Принципы основаны на популярности определенных ключевых слов и запросов.

И, конечно, моя работа заключает в том, чтобы вовремя отслеживать все появившиеся баги и устранить их :)

Результаты работы и графики

Вы молодцы, если прочитали все, что я написал выше. А теперь настало время для самого главного – ответа на вопрос «и чё?». А вот чё!

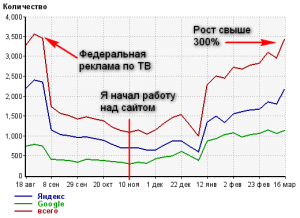

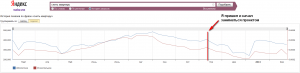

Статистика переходов с поисковых систем по данным Яндекс Метрики:

К сожалению, счетчик был установлен только с момента моего прихода в компанию, поэтому данные собираются только с 14 ноября, а на графике отчет с 15.11.2013. Но наблюдать прогресс это нисколько не помешает.

А вот счетчик LiveInternet на сайте стоял и до меня, так что часть интересной статистики получить удалось. Статистика переходов с поисковых систем (Яндекс, Google и суммарная), среднесуточный трафик в срезе по неделям:

На графике я постарался указать основные моменты. Пик в самом начале обусловлен проведением федеральной рекламной кампании по телевидению, в результате чего был шквал брендовых запросов и переходов по ним на сайт. Но видно, что после завершения рекламы трафик моментально упал. И я пришел как раз в тот момент, когда спад после рекламы плавно перетек в сезонный спад по тематике в целом.

Меня уже кто-то успел упрекнуть в том, что мои результаты связаны с сезонностью, а рост обусловлен банально повышением спроса. Но я подготовился и покажу, что это не так. Смотрите историю показов в Яндексе https://wordstat.yandex.ru/#!/history?.., а так же скриншот:

Как видите, не было не только роста, но был серьезный спад. В начале и середине декабря спад в полтора раза от ноябрьских значений, а резкий рост в январе в пике даже немного не достиг значений ноября, когда я начал заниматься сайтом. Сейчас в феврале-марте спад продолжается, а в мае будет самый минимум. Так что с сезонностью вы теперь ознакомлены, для примера я взял самый частотный общий запрос моей тематики – «снять квартиру».

Так что если бы мне сопутствовала еще и сезонность, то графики были бы значительно круче :)

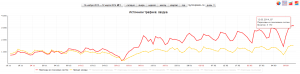

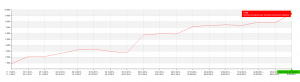

Больше всего мне нравится график не посещаемости, а отчет по количеству разных ключевых запросов по которым люди находили и переходили на сайт из поисковых систем.

Этот прекрасный график показывает суммарное количество уникальных запросов за неделю. Я бы назвал это видимостью сайта в выдаче. Это в первую очередь отражает качество внутренней оптимизации сайта. Можно наблюдать практически пятикратный рост переходов по уникальным фразам на сайт.

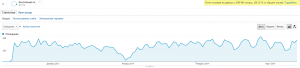

Ну вот, вроде основными данными похвастался наконец. Выше в разделе оптимизации я вам рассказывал про разные группы листингов на сайте: выборки по городам, типам недвижимости, районам, метро и т.д. Хочу показать графики роста по этим самым выборкам.

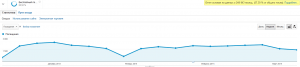

График переходов с поиска на главную страницу, над которой я пока не работаю:

Как видим, вообще без изменений. На эту страницу кроме брендовых запросов других переходов из поиска нет.

Кстати, о брендовых запросах. Вот график переходов по брендовым запросам на любую страницу сайта в срезе суммарно по неделям:

А вот наоборот переходы из поиска по не брендовым запросам в срезе по неделям:

Более чем четырехкратный рост количества переходов на сайт по целевым запросам!

Отдельно график роста по главным страницам городов:

График переходов с поиска по кластеру типов недвижимости:

Переходы на конечные страницы карточек объектов:

Состояние страниц кластера по районам всех городов:

Выборка точек входа по метро:

Ну вот, наконец-то я поделился с вами всеми графиками. Для меня самого это своего рода фиксация результатов и публичное обещание добиться еще более выдающихся результатов к следующему отчету.

Предвижу чей-нибудь вопрос о внешнем продвижении, то тут особо не о чем говорить. Моя стандартная схема – отбираем качественные ссылки с помощью FastTrust или, если программы нет, то с помощью сервиса CheckTrust.ru. Я сейчас пользуюсь именно вторым вариантом, ибо очень удобно: закинул все ссылки из GGL в проект, раз в 2 недели обновил данные, собрал белый список и закупился. За все 4 месяца работы я купил около 200 трастовых ссылок. Большая часть из этих ссылок ведет на страницы городов, а 30% всех ссылок безанкорные. Очень просто :)

Немного скомкано получилось. Все, что хотел рассказать, просто не вошло бы в один пост, но в целом я рассказал, что и планировал! Надеюсь, что для вас этот пост был полезным, вы почерпнули для себя новые интересные идеи для своих проектов.

Я думаю, что вы все равно будете хоть минимально, но изучать мой проект, потому хочу вас попросить поделиться со мной всеми найденными косяками на сайте, любыми моментами, которые вас смущают. Пускай получится обоюдный обмен опытом – я вам рассказал, что я сделал, а вы мне расскажете, что еще можно сделать с вашей точки зрения. Мне важно знать взгляд со стороны, не замыленный, так сказать!

Ну все, спасибо за внимание! До связи, друзья.

Полезно и интересно. Спасибо. На больших сайтах всегда есть, чем заняться и всегда есть множество задач и проблем, для многих из которых не подходят стандартные решения.

Привет, Саша (из Екатеринбурга). Классный пост, хорошо, что поделился опытом. Интересно следующее. С seo все понятно, ты нехило разложил по полочкам. Вопрос о том, что вы делаете с полученным трафиком? Работаете ли над его конвертацией на лэндингах? Может быть есть (в планах?) интеграция данных о трафике и конечных продажах и соответственно оптимизация этого процесса? Я о самой сути всей этой деятельности, ROI. :)

Привет землякам! Сегодня ночью как раз лечу на родную землю в ЕКБ по делам :)

Что-то где-то как-то считается в CRM-системе, это все, что мне известно по этому поводу. Что бы пользователь не делал на сайте, он все равно выйдет на связь с менеджером, исключение это онлайн-оплата на сайте. Третьего не дано.

Кстати, да. А вопрос-то отличный, я про конверсию и забыл рассказать в посте. А целевые действия у меня отслеживаются на сайте по событиям (event) в Google Analytics. Но это чисто для меня.

Видишь ли, продажи то в подавляющем большинстве идут через офисы. Я могу заявки с сайта считать, а вот что было дальше — ХЗ.

Короче говоря, все сложно, это не в моей компетенции.

Такая же история и у меня с конверсией.Мне даже не говорят:больше ли стало продаваться и насколько и какие товары именно,а ведь это помогло бы сайту вообще,еслиб я знал где подкорректировать и усилить.

Понравилась такая строка : — "Вообще на сайте было проделано невероятно много технической работы, исправлено несчетное количество ошибок и багов. Так же не забываем, что это совершенно нормальная ситуация, когда программист, исправляя одно, попутно ломает другое :)" — не успеваю догонять ))

И ещё мне бы лично не помешал график по трафику с учетом таргетинга.Понятно,что сайт идёт "по России", какой трафик возрос: Сочи,Краснодар,всё по Югу или подломилось по-больше конкурентов? ))

Вот это работа! Вот это результаты!

Сань, низкий поклон тебе!

Статьи хватило на целую дорогу в метро:)

Приеду домой, еще раз перечитаю!

Очень круто! Молодец!

Отличная статья! Просмотрел сайта предсталенный в кейсе, есть несколько вопросов:

— Тексты я так понял на сайт не писали, даже в основные категории. Для таких сайтов наверное нет смысла?

— В тайтлах также не заметил упоминания бренда, говорят полезно использовать для "уникализации" тайла во всем инете?

На rel=canonical по другому посмотрел, действительно хорошо убирает друбли, как я понял, потому что 301 не всегда уместен)

Совершенно верно, никакие тексты на сайт не писались. Разве что в сомнительный раздел аренды отелей, который просто сливает трафик на букинг, но этот раздел мне не нравится, я его не продвигаю. Думаю, что на основных страницах и так достаточно контента (описания с карточек объектов выводятся и на страницах листингов).

Что касается бренда в title, я не стал заморачиваться. У меня на половине проектов бренд присутствует в заголовке, на половине — нет. Взаимосвязи с успешностью продвижения не заметил :)

Да я и сам иначе взглянул на rel=canonical в свете полученного опыта. Действительно, 301-редирект не всегда уместен, хотя и он активно используется на сайте.

Понял, и вот еще хотел спросить про "интересный ход" с карточками товаров. Раньше, если объект сдан, то появлялась надпись, что "извините, объект сдан". Я так понимаю, что решели не отдавать 404, чтобы ловить весь целевой низкочастотный трафик и чтобы карта сайта была более-менее "статическая"? :))

Нет, в том-то и дело, что такие страницы не отдавали 404 ошибку, они все были доступны и отвечали 200 OK. Триста с лишним тысяч таких страниц одинаковых болталось на сайте :)

Конечно, надо собирать весь возможный трафик, исходя из моей статистики, это очень даже эффективно!

Спасибо, добротный кейс вышел у тебя, а главное — как раз актуальный для меня)

Актуальный, говоришь! Конкурент что ли? :)

Нет :) тематика другая, тоже объявления только о продаже спецтехники и тд)

После исправления всех ошибок возникнет ситуация, когда и сделать нечего, и рост замедлился. Вот тут и начнется настоящая работа. :) А так — классический кейс на тему, что будет с трастовым сайтом, если на нем исправить ошибки.

Чистая правда, когда все идеально сделано и глобальные изменения уже не могут быть, тогда начинается баттхёрт. Однажды и с этим проектом мне придется это пережить :) Благо, что сейчас там много нового появляется и я даже не успеваю. Вот, например, посуточная аренда появилась совсем недавно, и про нее в посте я даже не упомянул ни разу.

PS Дим, данный сайт не есть "трастовый", он вообще был в депрессии до моего прихода. Трастовым его делать приходится мне :)

Т.е. имитация бурной деятельности для получения денег за ничего не делание? )

"ничего не делание", кажется, подразумевает и отсутствие результата, а это прямой путь к увольнению, например.

Главное — результат. А вот что ты делаешь для его достижения, это дело второе, можно на голове стоять, можно сплясать, а можно и имитацией заниматься, какая разница, если есть результат! :)

Я имел в виду работу классического сеошника с сайтом на 50 страниц. Который за пару дней оптимизируется, на него закупаются ссылки а дальше сеошник с умным видом ходит раз в месяц за зарплатой.

Ведь, например, для сайта по уничтожению насекомых особо много направлений для развития не придумаешь. Собрал все НЧ на статьях, да ссылочками подкармливать. А клиента то терять не хочется. Я к этому. Привык наш сеошник сделать работу один раз, а деньги получать постоянно

Значит сеошник молодец, что все оптимизировал и ходит только за деньгами, и раз деньги дают, значит клиент доволен. Все правильно сделал, разве нет? Я без шуток, а вполне серьезно, между прочим.

Полностью согласен. Клиент платит не за время, сколько вы будете возиться с его сайтом, а за результат. И он будет более рад заплатить человеку который через месяц выведет сайт в топ по всем позициям и будет сидеть, задрав ноги на стол, чем человеку который будет присылать кучу отчетов о проделанных работах, написаных текстах, измененных метаданных и т.п. но сайт будет болтаться на третьей странице поиска.

Думаю справедливо-так как этоинтелектуальная часть моего вложения в сайт,которая стала приносить больше денег,тоже что я прикупил дополнительное оборудование и стрегу на нём капусту.% — заслужено.

Молодец! Отвлёк от ситуации на Украине.

Приветствую! Отличный гайд получился!

Интересует вопрос по количеству отказов на сайте. Как изменился этот параметр по сравнению с ноябрем? Проводились ли какие-то специальные работы по уменьшению данного показателя?

Спасибо.

Хороший вопрос. Показатель отказов изменился, разумеется.

Как я и говорил, раньше на сайт вообще не попадали пользователи по не брендовым запросам. Т.е. раньше были или заходы с закладок или с поиска по запросам, типа "selims", "селимс". Соответственно, это была аудитория подготовленная, это текущие клиенты, знакомые с сайтом и точно понимающие, чего они хотят получить — это лояльная аудитория. На данный момент состав трафика сильно изменился, количество посетителей не знающих о сервисе ровным счетом ничего стало преобладать. Как результат, показатель отказов увеличился, глубина просмотра на посетителя сократилась.

Поначалу руководство тоже забило тревогу, но я объяснил, что это совершенно нормально, так и должно быть.

Привет! Очень интересный материал.

Подскажи в какой системе выводил график по количеству запросов из поиска (рост по разным запросам)?

И есть ли у тебя в Google.Analytics какие-то шаблонные отчеты? Может поделишься паком?))

Еще раз спасибо за статью, было очень интересно почитать.

Привет! Отличный пост!

Зеркала еще склей

и /index.php :)

Вот это прикол, блин :) Я же говорил, что одну ошибку исправляют, а две новых появляется! Зеркала, конечно же, были склеены первым делом. Программисты такие программисты...

Здравствуйте. Когда-то в молодости воровал контент с одного сайта и все ссылки в статьях ворованного сайта были прописаны через rel="canonical" сами на себя, а стили ссылок были сделаны незаметно(под текст), так статьи не индексировались и в инструментах Я.Вебмастера были указаны канонические страницы ДРУГОГО домена и не индексировались. Так что информация "rel="canonical" с домена на домен не работает" — очень спорная ;)

Когда-то в молодости это когда? :)

И я не могу понять, что значит «ссылки в статьях ворованного сайта были прописаны через rel="canonical" сами на себя» — как это? Ведь canonical это исключительно атрибут страниц, а не ссылок.

«ссылки в статьях ворованного сайта были прописаны через rel="canonical" сами на себя» — это значить, берешь любое слово в статье и делаешь его ссылкой на страницу на которой находится этаже статья(при этом маскируешь ссылку под текст), например для статьи "Кейс – Стратегия продвижения и оптимизация сайта по аренде недвижимости", которая находится по адресу "https://alaev.info/blog/post/4986", выделил любое слово в статье и прописал ссылочку <a ahref="https://alaev.info/blog/post/4986" rel="canonical">,,,,,,</a> . Воровал месяца 3 назад, правда у французов, практиковался в переводе)))

Дак ведь, как сказал уже Саша, атрибут исключительно страничный. Зачем его в ссылке прописывать?

Кстати, Гугол поддерживает кроссдоменную канонизацию, если один из доменов — как минимум поддомен второго. В случае, если оба домена второго уровня — не поддерживает.

Вот и я о том же. Но Иван упорно пытается какую-то фигню писать. Повторить-то не сложно, просто прочитайте официальную справку по данному параметру и как надо его использовать. Canonical — это атрибут страницы и только так. Кстати, canonical можно еще и как http header заголовок передавать, но я пока не видел, чтобы это кто-то использовал.

Надеяться на кроссдоменную работу тега я бы не стал, потому что это по словам самих поисковиков не более чем рекомендация, а не строгое указание, и оно спокойно может быть проигнорировано даже внутри одного сайта, не говоря о разных доменах или поддоменах.

Я понимаю, что вы гуру оптимизации. Я тебе упорно говорю, что каконически можно передавать по атрибуту ссылки и Яндекс с Гуглом это хавают. А не только атрибут страницы. Факт!

Ну окей, где-то есть документальное тому подтверждение?

Мне вот интересно, если не секрет, сколько по стоимость обошлись такие доработки программной части?

Понятия не имею, у нас целый штат программистов. Считать затраченные часы на их работу — не моя задача.

Ну, ничего нового не открыли =)

Спасибо за то, что написали упорядоченно и доступно. Благодарю за возможность ознакомиться с опытом работы другого сеошника.

привет. как именно делали хлебные крошки? html5 или rdf?

А посмотреть исходный код как же?

PS Подсказка — ниже Иван тот же вопрос задавал и ответил сам же на него.

Затупил) задал вопрос, потом понял, что могу посмотреть в коде. Собственно, как я понял ты использовал RDF. Можешь как-то прокомментировать. Почему rdf, а не микроданные? Я проводил небольшой эксперимент, так вот по-моему мнению Google лучше понимает RDF, и в SERP подставляет в ссылки заголовки из хлебных крошек. Яндексу все равно, он ничего не понимает. И Яндексу на самом деле лучше, чтобы была простейшая html конструкция типа <div class="breadcrumbs"><a href=""></a></div> Можешь поделиться своими наблюдениями в этом вопросе?

Не вижу никакой принципиальной разницы между разметкой с помощью микроданных или RDFa. Наблюдения показывают тоже самое. Если бы эти варианты были неравнозначны, то об этом было бы упомянуто. Но раз уж на то пошло, то Google сейчас двигается в сторону schema.org и когда-нибудь в будущем планирует отказываться от всех иных разметок. А я размечаю так, как привык, когда что-то изменится, тогда и я изменю свой подход.

а ты не путаешь понятия словаря и синтаксиса? schema.org это словарь, а rdf и микроданные это синтаксис. в своем руководстве google https://support.google.com/webmasters/answer/185417?hl=ru приводит примеры с использованием словаря data-vocabulary.org, что в прочем не удивительно. так как именно google разработали этот словарь, а теперь он стал частью schema.org

на мой взгляд в перспективе лучше использовать словарь schema.org и синтаксис микроданных. но пока, google все же лучше понимает data-vocabulary.org и rdf

p.s. хорошая статья от яндекса http://habrahabr.ru/company/yandex/blog/211638/

Может и путаю :) Я сильно подробно не вдавался в спецификации микроразметки. Главное, что оно работает так, как мне надо, остальное не важно.

За ссылку спасибо, качественная публикация!

Что посоветуешь сделать информационному сайту по бизнес тематике. Статьи пишут 5 новых в месяц по 1000 симв, когда у конкурентов по 5-7к статьи, перелинковку и теги не сделали.

Сделал только техническую оптимизацию, что не дало нормального увеличения трафика, а клиент ждет... Если покупать ссылки, то где лучше, прокатит ли сапа или лучше делать обзоры статей?

Как минимум надо писать как у конкурентов, раз они в топе, да и вообще 1000 знаков это мизер.

Ссылки можно покупать в GGL, я там закупаюсь. Но можно с умом и в sape.

Приветствую!

Отличная статья, спасибо большое, много полезного будет для новичка(для меня).

Я посмотрел на исходный код и заметил:

1. На многих страница нету мета тегов

a. meta description

b. meta keywords

C чем это связанно? Вы над этим еще работаете? Или

Но ведь это начало я бы сказал АЗЫ (возможно мнение любителя). Или лучше не иметь описания и ключиков чем дубли?

2. В последнее время часто пользуюсь wordstat я так понял это статистика от яндекса. Есть ли такая статистика по гуглу?

3. Вы правильно говорите про просмотр проиндексированных страниц, я часто там нахожу всякие не понятные пути. И например описание для страницы берется c "шапки" сайта, у меня там находятся ссылки на регистрацию и вход, их можно убрать от индекса как это сделали Вы? Для поисковика это не будет значит что часть сайта "унылая какаха" если мы их прячем?

3. Очень понравилось решение с ссылками фильтрации, сейчас что то подобное хотим реализовать у себя на сайте, но пока, что встали на моменте длинного пути, я так понял вы сделали их коротким с помощью ".htaccess" ???

1. Вы ошибаетесь, на многих страницах заполнен description и он уникальный. Есть несколько страниц, где метатег не заполнен, но эти страницы не продвигаются и поэтому они не в приоритете пока, реки не дошли.

keywords не имеет никакой силы, следовательно и тратить время на него нет смысла, его можно игнорировать или удалить вообще.

2. Есть такой, я о нем даже писал — https://alaev.info/blog/post/4545

3. Как я и писал, закрыть ненужный контент можно при помощи <noindex>, ничего страшного не случится.

4. Я не понимаю, о чем вы говорите. Лично я ничего с url'ами не делал, и мы их не меняли.

Подскажите по этому пункту "В довесок, чтобы «добить», сделали микроразметку хлебных крошек под Гугл. " какую разметку использовали? Спасибо.

Сам спросил, сам отвечаю. Наверно это — https://support.google.com/webmasters/answer/185417?hl=ru

Саша, крутой кейс. Спасибо, за подробности. Подскажи, интересует такой вопрос: Есть листинг например на котором продаются молотки, а в него идут как в твоей примере ссылки на другие листинги с более детализированной инфой, например "твердые молотки", "мягкие молотки", "зеленые молотки", "розовые молотки", "деревянные молотки" и таких еще например 70 ссылок. Теперь сам вопрос: как к такому отнесутся пс, ведь много ссылок на одной странице, в каждой ссылке повторяется одно и то же слово "молотки", да и ссылки не в тексте расположены, к примеру и текста на странице вообще нет, кроме товаров и заголовков h? Переспам получается или я ошибаюсь? Если я прав, то может в noindex этот блок ссылок и (или) сами ссылки в ajax?

Зачем тебе эти ссылки? Если это навигация для пользователя, то в этих 70 ссылках не надо повторять каждый раз слово "молотки", просто используй там понятные обозначения: "мягкие", "зеленые" и т.д.

Если для поисковиков, то зачем скрывать тогда от индексации? :) Даже если ссылки и для поисковиков, то описанный выше вариант будет самым лучшим.

Очень приятно читать было.

Скажите, будете ли как-то улучшать положение по геозависимым запросам? Как?

В Гугле то вас опережают в основном только страницы VK))) а вот с Яндексом как быть?

Например по запросу "снять квартиру без посредников" в Омске первые 7 мест занимают региональные поддомены, вы на 9. А в Новосибирске по тому же запросу нашел вас только на 66 месте, причем в выдаче стоит страница Новороссийска, а не Новосибирска.

Планируется присвоить сайту основные стратегически важные регионы, чтобы постараться в них конкурировать наравне с региональными площадками, а с остальными видно будет.

Будет интересно посмотреть на результат после присвоения регионов.

Кстати, не могу не рассказать об одном забавном совпадении.

Я на ваш блог попал совсем недавно, когда искал примеры резюме для SEO-специалистов. Ознакомился с вашим примером, составил свое, отправил работодателю, прошел собеседование, завтра выхожу на работу.

А напротив нашего офиса знаете чей офис находится? Да, именно SelimS.ru)))

Вот такое совпадение, буду обязательно следить за вашим блогом и за вашим проектом.

А сколько и на какую сумму примерно берете ссылок?

Я же написал, что куплено около 200 ссылок. По деньгам это чуть более 50к рублей.

Портал не маленький. Просто устранить все «стандартные» косяки не так-то и просто.

Да и продвижению, недвижка – всегда была одной из самых сложных и конкурентоспособных сфер для оптимизаторов.

Хай. Отличный кейс. Тоже работаю с недвижкой. Что думаешь по поводу использования seo-текста на лендингах? Лично я использую.

Ничего не думаю пока, мне контента из текстов объявлений хватает на любых лендингах. И что-то мне подсказывает, что вложенные средства в дополнительные тексты не оправдаются в моем случае.

В вашем примере ошибка в описании "Квартира в хорошем состряние". Мелочь но всё же :)

http://yandex.ru/yandsearch?text=%D1%81%D0%BD%D1%8F%D1%82%D1%8C%20%D0%BA%D0%B2%D0%B0%D1%80%D1%82%D0%B8%D1%80%D1%83%20%D0%B2%20%D1%81%D0%BE%D1%87%D0%B8%20%D0%B1%D0%B5%D0%B7%20%D0%BF%D0%BE%D1%81%D1%80%D0%B5%D0%B4%D0%BD%D0%B8%D0%BA%D0%BE%D0%B2&lr=35

В базе сотни тысяч объявлений, описания к которым пишут люди, мы не можем их проверить все. А то, о чем вы говорите, это в сниппет попал кусок объявления как раз.

Привет, замечательная статья, спасибо большое, подскажи пожалуйста, если не секрет каким софтом ты строишь график цитата "суммарного количества уникальных запросов за неделю". Спасибо

Так это... Google Analytics :)

На сайте увидел банер на этот проект — http://xn--90abhqa5abbcteia7p.xn--p1ai/ и перехотелось вообще заходить на этот проект. Зачем такой бред рекламировать у себя?

Я отвечаю только за продвижение, остальное мне не подвластно. Как начальство захочет, так и будет...

Счетчики Google, LiveInternet не обрамлены в теги <!--noindex--> ошибка? или есть доля истины?

Никакой ошибки. Закрывать счетчики — чушь!

Вы пишите "А чтобы поисковики не шастали по неканоническим страницам, ссылки на сами страницы сделали через AJAX"

почему бы не воспользоваться теми же рекомендациями Яндекса и использовать предназначеный для этого тег rel="nofollow" ?

И что? Эта рекомендация роботам не ходить по ссылкам. Во-первых, это рекомендация, а не строгое правило, во-вторых, не факт, что роботы не ходят, а я уверен — они все равно ходят. А когда ссылок нет — мне спокойнее, гадать не надо, что там думает робот...

А покупаете ссылки в GGL только с тематических сайтов? в каком % соотношении?

Нет, тематику не учитываю, в этом нет никакого смысла, покупаю ссылки со всех сайтов, которые прошли отбор в программе FastTrust по фильтру ТРАСТ>40, СПАМ<7.

В каком % соотношении что? Процент безанкорных ссылок? 30% — об этом написано в одном из последних абзацев поста.

На текущий момент траст selims.ru паршивенький = 25. Что так? ... Бэки с траст доноров туго подтягивают траст?

Я не понимаю, откуда у вас в базе сотни тысяч объявлений, если зайдя на сайт я вижу:

Москва 240 штук

Краснодар 900

Новосибирск 193

и т.д. Где все объявления? Или их не видно зашедшему пользователю? Тогда как их должен увидеть робот?

P.S. И зачем у вас сделано так что при просмотре объявления на котором уже сданный объект http://selims.ru/arenda/Novosibirsk/t1_1-kom-kvartira/zorge-_31 пропадает описание квартиры? Ведь контента становится меньше?! Яндексу меньше нравится такая страница.

И кстати, как вы решили проблему того, что Яндекс кушает много страниц (десятки или стони тысяч), а в индекс попадает мало (тысячи)?

Читать надо внимательнее, я же писал "по статистике всегда более 97% всех объектов сданы", соответственно, они не показываются пользователям, а показываются только актуальные не сданные.

Короче, судя по вопросам, вы вообще не читали мой пост. Так что даже отвечать не буду...

Да, виноват, перечитал второй раз и нашел ответ на свои вопросы. Просто при первом просмотре обнаружил кучу страниц только с хра-ками объекта, но без описания и все они были сданы, вот и сделал ошибочный вывод. А что по поводу последнего вопроса? На него ответа не нашел.

Как вы решили проблему того, что Яндекс кушает много страниц (десятки или стони тысяч), а в индекс попадает мало (тысячи)? Помогла ли html-карта?

Пока не могу судить, помогла ли карта объектов. Как было в индексе около 10% всех страниц (около 35-40к) так и висит, не хочет дальше в индекс идти. В чем причина, не известно. Могу предположить, что дело в том, что у большинства страниц слишком низкий PR, и просто ссылки из html-карты сайта недостаточно, чтобы сделать страницы важной настолько, чтобы она попала в индекс. Наверное, это самая логичная версия.

Если бы сделали кольцевую перелинковку внутри сайта по всем объектам, то, скорее всего, они бы все в индекс зашли со временем, но это не вариант, потому что для пользователей это неуместно.

На самом деле с таким явлением я столкнулся 2012 году. Распарсил базу zip-кодов на два сайта. Один описывает Ганновер, другой Франкфур на Майне. Один попадает в индекс полностью, другой только процентов на 10. АГСа на нем нет. Я перепробовал все. Менял тайтлы, добавлял блок с контентом "А знаете ли вы что...", чтобы текста на странице было побольше, тоже не помогало. Не знаю, что делать, но не думаю, что дело в ссылочной массе на конкретную страницу, потому что структура сайта была такова Главная — Страницы со списком зип-кодов — Страница с описание зип-кода. Т.е. конечные страницы все были 3-его УВ. На каждую вела ссылка с вышестоящей. Перелинковок не было. Но один сайт попадает в индекс, другой нет. И таких сайтов у меня тонны. По смыслу страницы схожи со страницами объявлений. Ведь если отбросить описание квартиры все остальное только изменение параметров (района, телефона, площади комнаты и т.д.). Я лично думаю, что дело именно в контенте страницы. Т.е. Яндекс отбрасывает навигацию, отбрасывает скрипты, смотрит на голый контент и если он сильно дублируется с остальными страницами, то их не берет в индекс. И еще в пользу моей версии. Делаю обычный контентный сайт про газобетонные блоки, выкладываю статьи по 2к знаков, написанные копирайтерами. Все попадает в индекс и сидит там крепко. И опять же. Вы пишите про то, что надо было сделать кольцевую перелинковку. Но в индекс прекрасно заходят статьи (на контентных сайтах) и без перелинковки и без PR. Что тут делать, не понятно. Если надо могу сбросить примеры или показать все подробней.

Ради интереса можно задать такой вопрос в службу поддержки Яндекса.

Про статьи это понятно, они из без ссылочного допинга могут попадать в индекс и держаться там. Но, например, как же быть с сайтами обоев для рабочего стала или прочих картинок? Ведь там нет контента кроме заголовка и списка тегов, являющегося и то ссылками. Думаю, что даже без всякого эксперимента допустимо, что загнать страницу в индекс можно несколькими ссылками (внешними, с социалок, внутренней ссылкой с главной страницы). Так что я не знаю, отчего такое поведение по отношению к одним сайтам и другое отношение к таким же сайтам. Яндекс — загадка :)

Я с вами полностью согласен. От себя хочу только добавить.

1...Ответ будет стандартным: «Не все страницы сайта, известные поиску Яндекса, включены в индекс и ранжируются высоко. Их включение и позиция зависят от качества сайта и его контента с точки зрения пользователей, и многих других факторов.Следуйте нашим рекомендациям, развивайте Ваш сайт для пользователей и наполняйте его полезным, уникальным контентом, со временем страницы будут появляться в поиске.»

2...Сайты картинок отличаются от текстовых именно так как вы описали: большая картинка, тайтл, возможно заголовок. И Яндекс это видит и относит их к картиночным сайтам. Просто если бы он умел так же хорошо работать с картинками, как и с текстом и это было бы для него так же важно, то он точно так же бы жёстко относился бы к таким сайтам.

3...Конечно страницу можно загнать в индекс ссылками, а уж из социалок типа твиттера и прочее это "святое дело". Другой вопрос сколько продержится такая страница в индексе? Бывает, что искусственно загнанная страница частенько выпадает. Опять же, как мне кажется, качество страницы определяется не только контентом, но и ссылочной массой. По этому такой способ очевиден, другое дело, что для крупных сайтов, как selims он не приемлем, ибо держать покупной (а естественную ссылочную массу такого объема трудно нарастить) объем из нескольких сот тысяч ссылок просто экономически не выгодно. С другой стороны это показывает, что это не сгенеренный ГС, а реальный сайт в который вкладывают деньги.

4...Вот мне и кажется, что такое поведение и обусловлено тем, что Яндекс пытается фильтровать сайты по их полезности, они не зря именно это подчеркивают. Ведь по сути сайт с объявлениями о продаже недвижимости можно сгенерировать самому. Объявления, как я выше писал, отличаются только адресом, телефоном, площадью, количеством комнат. И таких объявлений можно нагенерировать миллионы. А Яндекс не хочет потакать дорвеестроителям, сателлитчикам и прочим, кто грешит такими сайтами.

Резюмируя свою мысль, хочу сказать, что нужен способ показать Яндексу, что это действительно качественный ресурс, каждая страница которого должна быть в индексе. Как это сделать — не знаю. Знал бы, давно бы жил на Багамах :)

Единственное, что приходит в голову в вашем случае, это добавить сайт в Яндекс недвижимость. Там ручная модерация, которая явно прибавит трастовость сайту. По аналогии с Яндекс Новостями. Мои сайты в Яндекс Новостях чувствуют себя более уверенно, чем те, кто не в них. Второй способ показать Яндексу качество и полезность сайта это подключить комментарии к каждой странице, тогда со временем он увидит, что сайт действительно нужен и интересен людям и улучшит его индексацию. Другого ничего в голову не приходит. Рад буду выслушать вашу точку зрения.

Александр! Как продвигается сайт? Много страниц удалось в индекс загнать за последние 2 месяца и что для этого было сделано?

Я тут вот, что посмотрел. У Яндекса есть хороший инструмент как проверка URLа:

http://webmaster.yandex.ru/site/check_url.xml Через него можно загнать в индекс (быстророботу) страницу, о которой Яндекс еще не знает. А на те страницы, что он исключил из индекса можно купить ссылок, чтобы увеличить их важность для поисковика. Только не знаю как это массово делать :( , а по одной штуке это нереально.

Ничего, нормально продвигается. Конечно, не такими классными темпами, как раньше, но это и понятно, чем дальше (точнее чем ближе к ТОП-1) тем дело идет все медленнее. Но видимость в поиске растет каждый день и продолжает расти, через месяц-полтора там и сезон начнется, будет рост :)

В один прекрасный день влетело целая куча страниц в индекс и стало их там 176 тысяч, там и держалось, но пару недель назад снизилось до 117 тысяч. В любом случае, это лучше, чем когда-либо.

Для этого делалось ровным счетом ничего нового, кроме описанного в посте. Просто до Яндекса только сейчас дошло :) Но я не заметил никакого выигрыша в трафике после увеличения индекса, но я и подробно срезы не смотрел, а глобально никаких перемен.

А взлет в индекс случайно не в районе 20 мая был? Просто у меня с одним сайтом такая же петрушка, один-в-один. И так же пару недель назад выпало, правда, не так радикально как у вас, в процентном соотношении значительно меньше, но тенденция похожая. А вчера опять вошло в индекс с плюсом. Даже не знаю, ЧТО предпринять, чтобы улучшить тенденцию, и быстрее и проще в индекс загонять... Я вот все пытаюсь вычленить адреса страниц, которые неизвестны Яндексу (именно неизвестны, а не непроиндексированы) и скормить их быстроботу. А еще хочу вычленить адреса страниц, которые известны Яндексу, но отсутствуют в индексе. На них хочу ссылочек подкупить, дабы повысить значимость страницы.

Может быть и 20 мая, я не знаю точно, в панели вебмастера почему-то инфа только за июнь отображается.

Считаю, что бесполезная идея что-то вычислять и вычленять. Главное, чтобы нужные страницы были в индексе, а они будут, если на них есть уникальный контент и до них можно добраться по ссылкам внутри сайта (пусть даже и за много кликов).

Согласен, что этот путь более правильны. Но как сделать чтобы на страницах был уникальный контент??? Вы буквально комментарием ниже написали: "Объявления по сути своей и так не уникальные, человек подает объяву сразу на несколько сайтов, а то и на десяток.".

Единственный способ, который я знаю, спарсить из соц. сетей комментарии и выложить их к объявлениям, это хоть как-то разбавить их неуникальность. Но это не ice.

Зависит от сайта. Да, если брать в пример сайт типа Selims, то уникального контента там добиться сложно. Оно и не надо, это же не инфо портал.

Я окончательно запутался. С одной стороны вы говорите, что страницы будут в индексе: "если на них есть уникальный контент и до них можно добраться". А с другой стороны, что: "уникального контента там добиться сложно". Так что тогда делать, в случаях сайтов с объявлениями?

Опять же, лично я, связываю влёт двух абсолютно разных сайтов в индекс Яндекса около 20-ого мая не с тем, что на обоих сайтах проводились правильные работы, а с тем, что в этот ап Яндекс сделал послабление и выложил в индекс кучу страниц, которые раньше не хотел выкладывать в индекс.

Для разных типов сайтов разные условия. Для инфосайта уникальность очень важна, для сайтов объявлений уже не критично. Так же как и для интернет магазинов, ведь характеристики товара не могут быть изменены.

Что было в Яндексе 20 мая, судить не берусь, возможно, это был просто большой текстовый апдейт и все.

Как вы боритесь с воровством контента или это не актуально для объявлений?

Никак не боремся. Объявления по сути своей и так не уникальные, человек подает объяву сразу на несколько сайтов, а то и на десяток. Просто стараемся разнообразить страницы с не уникальным контентом какими-нибудь фишками.

Привет! Отличный пост, довольно подробно!

Как сформировали этот отчет https://alaev.info/wp-content/uploads/2014/03/result-setraffic-words-week.png ?

Я так понимаю это Метрика->Конструктор отчетов, не?

Да, все верно, отчет из конструктора отчетов в Метрике.

Еще вопрос, вот ты отсеивал брендовые запросы от небрендовых в аналитиксе, нормальная часть запросов закрыта в not provided и not set, что ты с этим делал?

Отсеивал брендовые, в фильтре их исключал. А вообще обычно брендовые запросы на главную идут, очень редко, когда на другие страницы.

С not provided и not set ничего не делал, а что с ними сделаешь? Я просто анализировал доступные данные.

Сейчас, когда Яндекс еще закрыл свои запросы, совсем печально становится, останется по крупицам собирать данные. Или пользоваться Метрикой.

Привет! Спасибо за пост, очень интересный материал, хороший подход.

В качестве корретировки: при редиректе с www сохранять текущий URL, а не переадресовывать на главную.

Интересует, где и в каком виде хранишь структуру сайта и все шаблоны заголовков и мета данных?

Проект большой, где-то это ведь должно быть зафиксировано...

Там есть какая-то проблема с поддоменами (еще до меня что-то там натворили) и потому со всех поддоменов, включая www редиректит на главную.

Структура и т.д. хранится в БД, а где же ей еще храниться?!

Не, я не про техническую точку зрения.

Может какие-нибудь интеллект-карты используешь, где у каждого листинга фиксируешь их заголовки и мета данные или еще какие-нибудь делаешь заметки?

Я только сеошу данный проект.

В разработке участия принимаю минимально, только относительно тех вещей, которые мне для seo нужны и все.

Саша, здорово, спасибо за подробный кейс. Можешь ответить на волнующие вопросы:

1. Подскажи пожалуйста те 70% анкорных ссылок — брал только прямое вхождение анкоров или добирал разбавкой, переколдовками, забором длинных фраз из текста?

2. Как ты относишься к донорам из sape если отбирать через FastTrust, там как по мне одни спамные? На твой взгляд имеет смысл работать сейчас с sape отбирая доноров через FastTrust?

3. По твоему мнению чем FastTrust лучше Xtool?

4. Саш, был ли опыт работы с SEOHAMMER ,сам агрегаторы терпеть не могу, считаю это ламерским злом, но про этот слышал что алгоритм Burunduk разрабатывал отсева гс. Твое мнение стоит, есть опыт твой или знакомы, как он в деле?

1. Нет, не только прямое вхождение. Точнее сказать, у меня даже анкоры то ни разу не повторялись при покупке ссылок. Так что разбавка, переколдовка, длинные фразы.

2. Если проверить всю базу sape (а я ее проверял и не раз), то могу сказать, там более или менее приемлемых доноров менее 5%. Так что это очень трудоемкий процесс отбора доноров в сапе.

3. Да всем лучше, xtool дерьма кусок.

4. Не продвигал в сеохаммере ничего, да и не планирую уж точно. Но это всяко лучше, чем автомат в сапе. Больше ничего сказать не могу.

Извиняюсь может не по теме но не подскажете где можно взять подобный скрипт сайта, желательно бесплатно? Заранее спасибо!

Нигде, скорее всего.

Сотни человекочасов труда программистов, проектировщиков, аналитиков. Десятки ошибок в выборе направления развития, которые пришлось откатывать и начинать заново. Тонны приложенного таланта, неисчислимое количество неочевидных ноу-хау, добытых неведомыми путями. Допилы под сео, под конверсию, под потребности и доверие пользователя, под скорострельность сайта.

И где ж взять такой скрипт... готовый... забесплатно?! Да накто такое не отдаст. Если и будут продавать то как бизнес: с командой, инфраструктурой, трафиком, базой пользователей и выручкой.

По сути вопроса: ситебилл чтоли попробуй. Как, я думаю, ты успел для себя открыть, остальные движки в основном под сайт агентства заточены. А на этом есть сайты сервисного направления, которые трафик монетизируют иными способами. Но и то, бюджет у тебя по модулям + допилы (а они обязательно понадобятся — к бабке не ходи) выскочит солидный. Равно как и время на воплощение. Т.е. дешево и быстро (это следующая ступень после сразу и бесплатно) всё равно не будет.

А вообще, выбор конкретного движка — дело второе. Если не десятое. Но это уже другая история.

Добрый день! А где именно Вы получили отчет по количеству разных ключевых запросов, по которым люди находили и переходили на сайт из поисковых систем? :) Интересует тот вид, который представлен на графике.

В ЯндексМетрике старой, конструктор отчетов:

Построить отчёт по: неделе визита

Посчитать: поисковый запрос / количество различных

При условиях: ничего не выбирать

Показать диаграмму: линии

И все :)

Спасибо!

А в новой метрике такой отчет сделать можно?)

Нет :(

А какой регион был присвоен в вебмастере яндекса или были назначены 7 регионов через яндекс.каталог?

Через ЯК присвоены несколько регионов. Сейчас у меня доступа к сайту нет, сказать точно не могу. Но мы присваивали регионы, я точно помню, штук 5.

Александр, спасибо за реально полезный для меня кейс!

У меня вопрос: нужно ли страницы html-карты сайта делать индексируемыми или лучше noindex, follow? Ведь они не имеют по сути контента кроме ссылок, да и ценности для пользователя в таком виде не несут. И еще: достаточно ли на карту ссылки только с главной или со всех страниц на нее в футере сослаться?

Думаю, лучше сделать индексируемыми для верности. Достаточно сослаться с главной, хотя на первых порах можно со всех страниц сослаться, чтобы заставить быстрее работать, а потом, через 1-2 месяца убрать ссылки и оставить только с главной.

Спасибо за пост. Вопрос: а зачем было закрывать от индексации мобильную версию? Я так понимаю, что на тот момент не было отдельного мобильного индекса?

Для избежания дублирования, разве не очевидно?

Очень понравилась статья, спасибо! Хоть и старая, но все еще полезная и актуальная.

Один вопрос: проект все еще на Вашем обслуживании или уже умирает? Пока читал статью заметил некоторые крупные изменения в контенте, да и в позициях.

Он уже давно никак со мной не связан, я покунил проект в 2014 году, с тех пор там многое изменилось, к сожалению, в худшую сторону, многое из того, что описано выше, потеряно.

Эхх, какие же все кейсы очевидные. Исправил явные косяки и всё поперло. Хоть бы кто нибудь написал про сайт, где изначально уже все вылизано, а позиций все равно нет.

Кстати, вылез баг у вас на блоге. Отметил чекбокс подписаться, пришел емейл со ссылкой на подтверждение подписки, а по ссылке — 404.

У меня не 404, а просто бесконечный редирект. Раскурить, в чем же там дело и что за баг, не удалось. Но при этом подписка осуществляется, что радует!

День добрый, очень понравилась идея с noindex, чтоб сниппет подрегулировать. А то у меня на странице уникальный текст для категории товаров интернет-магазина, и постоянно оттуда берется какой нибудь огрызок. Так вот если я его заключу в этот тег, не сыграет он в минус на позиции запросов?

Предсказать нельзя, но рекомендую попробовать и проверить на небольшой выборке страниц, если ничего не изменится, можно будет масштабировать на все остальные.

Добрый день.

Сайт уже не доступен к сожалению нет возможности посмотреть, поэтому вопрос.

Карточки товаров или объектов имели в урл признак региональности ?

или такой признак был сделан только для категорий и фильтров?

пример 2000 товаров, умножаем на 30 городов, получается мы гуглу одномоментный подкидываем 60000 новых страниц. как он на это отреагирует ?

спасибо за ответ.

Зачем умножать что-то на количество городов, если объявление об аренде квартиры может быть только в одном городе?

Но это относительно конкретно данного сайта (пусть и бывшего и ныне несуществующего), а если речь про типичный интернет-магазин, то обычно региональность решается созданием поддоменов, а там, на поддоменах, товары дублируются, конечно.

В нашем случае решили сделать региональность в папках.

Для ИМ это плохая идея, для сайта, где в разных городах разный ассортимент — это ок.

В общем, я тут об этом писал подробно — https://alaev.info/blog/post/7054