Привет, друзья! Сегодня совсем необычный пост для меня, во-первых, сегодня выходной день, а я никогда не пишу по выходным, но сегодня особенный случай, а, во-вторых, сегодня нетипичный пост – разгон о некомпетентности или просто безалаберности «типа экспертов» в области SEO.

Привет, друзья! Сегодня совсем необычный пост для меня, во-первых, сегодня выходной день, а я никогда не пишу по выходным, но сегодня особенный случай, а, во-вторых, сегодня нетипичный пост – разгон о некомпетентности или просто безалаберности «типа экспертов» в области SEO.

Да-да, если вы подписаны на меня в twitter, то знаете, что я говорю сейчас про энциклопедию поискового продвижения от Ingate – сайт www.sembook.ru. Читая утром Твиттер, я наткнулся на анонс новой главы этой самой энциклопедии на сайте seonews.ru, так как про энциклопедию я раньше не слышал, то меня она несколько заинтересовала.

Перешел я на сайт, потыкался, посмотрел, и совершенно случайно заметил, что у всех страниц заголовок title одинаковый. Мне стало просто интересно, как же так вышло, что ребята с громким именем (Ingate, Rookee и еще чего-то они, наверняка, создали, я не в курсе) так облажались. Решил посмотреть исходный код… И понеслась поехала веселуха!

Я проанализировал сайт, его код и другие важные моменты и сделал некоторые выводы, с которыми и хочу вас познакомить.

Буду излагать в виде тезисов, это будет перечисление найденных грубых ошибок. Итак:

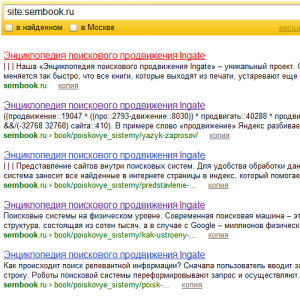

- Сайт доступен по адресам sembook.ru и www.sembook.ru

В индексе Яндекса может и нормально все, но в Google встречаются полные дубли страниц как с www так и без него.

Пока смотрел страницы в индексе, наткнулся на мини-книгу Вадима Миклухи про 10 грехов seo-оптимизатора. Я ее просмотрел, и там как раз нашел про 301-редирект с www на без www (или наоборот). Ах, сами и нагрешили =) - Так же я бы добавил для всех страниц метатег rel="canonical", дабы избегать дублей страниц (я знаю, что Disallow: /*?, но все же), связанным как с упомянутым выше www, так и с разными метками ?utm_source= и т.д, которыми ребята активно пользуются, ставя внешние и внутренние ссылки.

- Да, что касается robots.txt:Host: www.sembook.ru — благодаря этой директиве Яндекс как раз и не показывает в выдаче дубли, связанные с www, но это не работает для Google. Кстати, в Google основную массу проиндексированных страниц составляют url вида sembook.ru, а не www.sembook.ru как это задумывалось изначально.

User-Agent: * Disallow: /bitrix/ Disallow: /*? Host: www.sembook.ru Sitemap: http://www.sembook.ru/sitemap.xml

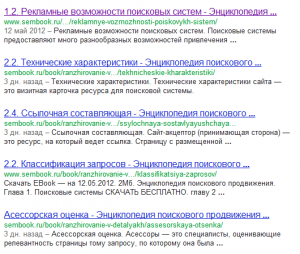

- На всех страницах одинаковый title — site:sembook.ru

<title>Энциклопедия поискового продвижения Ingate</title>

Выдержка из книги Миклухи: «Мета-теги являются одними из самых важных и значимых тегов для поисковой системы. Они являются визитной карточкой страницы. Поэтому важно, чтобы они были заполнены правильно и содержали краткое описание имеющегося на странице текста.»

Да ладно-ладно (пишу это для самых глазастых), не на всех страницах title одинаковый, на страницах о компании, о авторах и о условиях использования заголовок уникальный =) - На всех страницах одинаковый keywords:Без комментариев. В подобных случаях лучше оставлять метатег пустым, чем дублировать его везде.

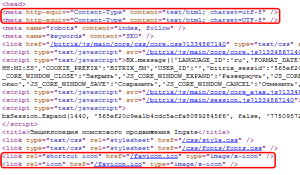

<meta name="keywords" content="SEO" /> - Бесполезный тег robots:В данном случае этот тег бесполезен, не несет ни пользы, ни вреда — просто он не нужен. Я придираюсь...

<meta name="robots" content="index, follow" /> - Еще пара ошибок верстки:

Для чего-то указана кодировка 2 раза:

<meta http-equiv="Content-Type" content="text/html; charset=utf-8" /> <meta http-equiv="Content-Type" content="text/html; charset=UTF-8" />

Два раза указан favicon:

Как бы там ни было, не стоит так делать.<link rel="shortcut icon" href="/favicon.ico" type="image/x-icon" /> <link rel="icon" href="/favicon.ico" type="image/x-icon" />

- Скрытый блок навигации в шапке:Может я не знаю всех подробностей происхождения этого кода, но я точно знаю — так делать не стоит!

<div class="menu"> <ul> <li><a href="http://www.rookee.ru/blog.aspx"> <span> БЛОГ</span></a></li> <li><a href="http://www.rookee.ru/start.aspx"><span> КАК НАЧАТЬ ?</span></a></li> <li><a href="http://www.rookee.ru/"><span> ЧТО ЭТО ?</span></a></li> <li><a href="http://www.rookee.ru/"><span> ГЛАВНАЯ</span></a></li> </ul> </div>

- Множественное использование тега H1 (если быть точнее, то на всех страницах три раза встречается тег H1).

Грубая ошибка. Чтобы ее решить надо отпинать верстальщика (возможно по лицу), чтобы раз и навсегда запомнил, что использовать теги заголовков при верстке сквозных элементов и неосновных частей оформления нельзя! Заголовки предназначены для целевых страниц и разметки их основного содержимого.

Говоря о реальных примерах, совсем не разумно выделять в заголовок<h1>Сервис автоматического продвижения сайта ROOKEE</h1>и<h1 class="font">Оглавление</h1>на каждой странице сайта. - Такие ошибочки, тоже порой веселят:

<h3><br /></h3> <h3><strong>Трафиковое продвижение</strong></h3>

Не супер критично, но хорошего в этом точно ничего нет.

Вообще я бы могу много где придраться к верстке. Может быть, сам сайт и макет далек от релиза, может быть верстальщик лопух, может еще что, но до идеала очень далеко! - Использование следующей структуры в текстах публикаций для меня загадка:

<noindex><a href="http://site.ru/page/" rel="nofollow">тут анкор</a></noindex>

Притом что так оформлены ссылки и на свои сайты и на сторонние.

Хотя на некоторых страницах ссылки на свои сайты так не закрыты. - Незаполненные alt и title у картинок – ну, это так, фигня, просто придираюсь.

Судя по просмотренным страницам и разным ошибкам на них, сайт наполняют разные люди, кто-то из них с визуальным редактором справляется лучше, кто-то хуже. И никто из них не использует html-редактор, так как разметка текстов не идеальна.

Дальше мне надоело уже, и я прекратил издеваться над сайтом, да и этого уже более чем достаточно. Как видите, степень тяжести ошибок разная, от критических и почти смертельных, до почти безобидных, но коробящих глаз.

Вообще зачем все это я затеял? Какова моя цель? Хотел ли я нагадить кому-то и посмеяться?

Нет, нет и нет! Я ни в коем случае не хотел умалять достоинств конторы Ingate — они молодцы, они делают хорошие инструменты (те же rookee и rooletka). Я с ними общаюсь – Аня Фомина, привет тебе от меня и всех читателей моего блога! Они профессионалы своего дела, я не сомневаюсь, но у всех бывают ошибки, порой очень грубые и недопустимые.

Цель данного поста – обратить внимание на базовые вещи, так сказать, прописные истины. Друзья, ну не лезьте вы вперед батьки! Не надо искать идеальную формулу плотности ключевых слов на странице (ее не существует), не надо спрашивать у меня в каких пропорциях и какие ссылки покупать. Я вам в первую очередь говорю, и сейчас повторяю – занимайтесь сайтом, там столько потенциала и возможностей, что вы даже себе не представляете, насколько сильно можно сэкономить на продвижении всего лишь однажды грамотно оптимизировав сайт!

Просмотрите свои сайты, я знаю, там куча подобных ошибок, работайте над ними и исправляйте – вы будете удивлены результатами!

И читайте поменьше «умных» seo блогов, большинство их авторов совершенно некомпетентны, и если проверить их блоги так, как я проверил сайт sembook.ru, то можно найти кучу подобных ошибок. Зато авторы пишут «умные» статьи о том, как круто покупать ссылки, представляются экспертами и все такое. Выбирайте по-настоящему умные (вот тут уже без кавычек) блоги.

Вроде все сказал, что хотел…

Ну что, будем ждать официального ответа от Ingate и редакторов sembook.ru? Если вы с кем то из них знакомы, передайте им ссылки на данный пост, пожалуйста.

А кому интересно, можете поискать на сайте энциклопедии еще ошибки и делиться находками в комментариях!

Готовы выслушать ваши мнения в комментариях или Твиттере. Так же я готов выслушать критику в мой адрес, если вам есть, что «предъявить».

В общем всё, о чём ты написал: типичные ошибки битрикса + бездумное создание шаблона и распихивание контента.

Т.е. контент-менеджерам (если они были в компании, у которой заказывали сайт) просто надо вырвать руки ))

На самом же деле в настройках сайта задаются определённые метатеги и они автоматически подставляются на все, вновь создаваемые страницы.

<noindex> — это вообще стандартная конструкция в шаблонах битрикса, почему не убрали — не ясно.

А всё, что после 9 пункта — целиком и полностью заслуга говённого (это саое мягкое слово) визуального редактора битрикса. Люди просто пишут заголовок, выделают текст и из выпадающего списка выбирают его оформление, чтоб смотрелось как надо, а потом просто жмут enter и html-тег, в который завёрнут был предыдущий текст тупо дублируется с BR внутри )))

В общем редактор битрикса — это вообще отдельная тема.

Визуальный редактор — зло =)

За что я люблю DLE )

Работал с разными CMS и ни разу мне не попался визуальный редактор, с которым хотелось бы работать. Поэтому я его просто отключаю и делаю всё руками. :)

Да, немалую роль тут сыграло и использование Битрикса, который добавил своих "прелестей" как в верстку, так и во все остальное. Но ведь все можно (и даже нужно) допилить, как я это делаю с DLE вот уже который год.

Визуальный редактор — это, действительно, зло. Для себя я давно решил, что лучший визуальный редактор это обычный блокнот, где все внутренности как на ладони!

Просто для людей не столь посвященных (я говорю про контент-менеджеров) увидеть html-код, это так же как мне сейчас дать китайскую грамоту. Всегда за что-то приходится платить, или скорость и простота, или качество и надежность.

Так объясните пожалуйста, что неправильного в использовании конструкции <noindex>/nofoollow>, у меня часто бывают повторяющие фрагменты на страницах, которые необходимы для читателя, но абсолютно не нужно показывать поисковикам. Какой выход? Жду от вас правильной подсказки. Заранее благодарен!

Да технически тут все правильно. Но есть тонкости, во-первых, noindex не понимает ни один поисковик кроме Яндекса (потому правильно говорить не поисковики, а Яндекс), во-вторых, тот же Яндекс совершенно неоднозначно поступает с этим тегом. Так что, чтобы не было неожиданностей лучше данный тег не использовать.

Что касается rel="nofollow" то его смысл практически пропал, после того, как вес по таким "типа закрытым" ссылкам стал все равно утекать. То есть закрыл ты ссылку — вес потерялся, не закрыл — абсолютно тоже самое — вес потерялся. Тогда блиц-вопрос — зачем закрывать, если разницы нет?!

Очень интересный вопрос — вес таки утекает по ссылкам ил всё таки вариант с сообщающимися сосудами ближе к истине? А rel="nofollow" ничего не потерял, он изначально сделан для того чтобы не следовать по ссылкам и не более имхо.

Может робот и не переходит по ссылкам с атрибутом rel="nofollow", но вес по этим ссылкам утекает точно так же, как если бы этого атрибута не было.

Т.е. если у меня блог с тИЦ 0 и PageRank 0, я поставил ссылку на тот же Яндекс, то теперь вес с него утекает к поисковому гиганту? Т.е. ссылки даже на авторитетные ресурсы ставить не стоит?

Стоит. Блог Деваки меньше всего пострадал от Пингвина и пошёл в плюс, хотя dofollow.

2NMitra: вот и я о том же. Хороший пример к слову. Лично я склоняюсь к версии сообщающихся сосудов. Если поставить ссылку с малоавторитетного на авторитетный сайт, выиграет малоавторитетный и наоборот. При этом никто ничего не теряет, здесь как-бы всё идёт в рост. По крайней мере если ссылки естественные, это сейчас один из ключевых факторов.

Nofollow действительно закрывает ссылку для следования по ней бота. Вес распределяется по ВСЕМ ссылкам, но передается только по тем, которые не закрыты, в этом собственно и фишка. Сделано это для того, чтобы не разводили линкопомойки имхо. Другими словами, если например на сайте 4ри ссылки, 2е закрыты nofollow, то остальные 2е получат ¼ веса со страницы донора. Конечно, это всё только имхо, но видится более реальным.

Константин: Да, вес утечет Яндексу.

Ставить или не ставить, это совершенно другой вопрос. Я объясняю механику работы, а не говорю о том как делать стоит, а как не стоит.

Вес идет абсолютно по всем ссылкам, не важно закрыты они или нет. Только по незакрытым ссылкам донор получит вес, а по закрытым донор не получит ничего.

Мужики, вы что-то тут веса какие-то переливаете, вы о чём вообще? Какие там у вас утечки?

Вы что считаете, что вы поставили со своей статьи ссылки и у вас вес куда-то утёк? По-моему это миф, который уже забыть давно пора.

Судя из этой логики очень плохо ссылаться на другие сайты? Вам не кажется это абсурдом?

По-моему, если я в статье хоть 50 ссылок размещу, которые будут нужны пользователю для более глубокого изучение темы вопроса, то это будет только в плюс моей статье. Забудьте вы уже про все эти веса, ключевики и т.д. это уже давно позадиии. Займитесь для начала тем, о чём собственно этот пост!

Алаичъ, жди письмецо с СБ компании :)

Я бы сказал у многих руки не доходят, что бы сделать валидный сайт. Кому то это пофигу. В моем маленьком городке, где я живу, есть всего одна фирма по созданию сайтов. Не раз я их носом тыкал на ошибки, а им до лампочки. Главное втюхивать созданные ими сайты на джумле и бесплатными шаблонами людям, которые вообще ничего не понимают в верстке, дизайне и т.п. вещах... иногда бесит, за что люди деньги отдают!

А с другой строны. Я вот работаю верстальщиком и мне вообще не упёрлись эти метатеги, мне главное правильная, по возможности неубиваемая кривыми руками пользователей, вёрстка и возможность лёгкого дальнейшего масштабирования проекта.

Всю эту короткую неделю я занимался именно созданием структуры сайта (крупной компании) и наполнением тестовым контентом (для визуалього представления что как будет). Естественно не о каких метатегах я не заботился, т.к. во-первых я уже сказал выше, а во-вторых время, время, время... которого мало, потому что заказчик полгода компосировал мозг, а потом (наверное проверка приезжает "сверху") ему вдруг резко стало "нада".

И я более чем уверен, если я (или менеджер) не удалю демо-контент, он так и останется висеть на сайте, до тех пор, пока о нём не сообщат администрации сайта добропордочные граждане. Потому что крупной компании как правило похрен на сайт, им главное "закрыть вопрос" перед вышестоящим начальством.

Мелкая же компания просто не будет делать сайт на битриксе — дорого и долго.

Дизайнеру не уперся верстальщик, программистам не уперся сеошник, админам вообще ничего никуда не уперлось. И что из этого выйдет? Дерьма кусок из этого выйдет, где каждый расхлебывает за другого. Это неправильная политика в корне.

Хотя, разные обстоятельства, разные случаи, я все понимаю. Но если такая ситуация складывается в компании с группой людей, работающих вместе, то это все, пипец...

Наверное я не совсем правильно выразился. Мне на сдаваемый контент побарабану, а не на людей. Контент всегда можно поправить, даже более того, его НУЖНО править. И что бы тот же сеошник мог спокойно править этот контент, или внедрять какие то свои "штучки", нужна правильная вёрстка, сделанная по правильному макету, с предварительно проработанной логикой. И что бы всё это осуществить — мы довольно тесно работаем вместе. Скажу больше — наш дизайнер обладает навыками вёрстки, верстальщик навыками php, програмисту есть что иногда подсказать дизайнеру... Отсюда и слаженность в работе.

Ну и омрачает всю эту идиллию лишь два слова — желание заказчика (думаю объяснять не нужно, какие типы порой попадаются)

Ну, что тут говорить, как и везде работа делается не за идею, а за зарплату! Стукнуло время и бегом домой, так что я не удивлён нисколько.

По поводу того, что я заглядывал уже к SEO блоггерам и увидел очень много ужасны ошибок http://wlad2.ru/analysis-top-google-seo-blog/, но это было давненько 28.09.2011.

Есть вылизанные блоги. Например, мой, хотя я его не причисляю к SEO. Интересно, что-нибудь найдёшь?) Я уж не знаю как над ним поиздеваться: например, микроразметка http://www.google.com/webmasters/tools/richsnippets?url=http%3A%2F%2Fshpargalkablog.ru%2F2011%2F06%2Fwarning-missing-required-hcard-author.html&view=

seom.info ещё нравится.

Задротствуешь как и я, стало быть =)

Искать сегодня уже ничего не буду, устал я. А вообще бегло глянув html-код случайно страницы мне не понравилась верстка, слишком там много всего лишнего, js-скриптов в коде, а не в отдельном файле, css-стили в коде страницы, а не в отельном файле — это вообще беда. Может быть, это какие-то ограничения платформы blogger, я не в курсе...

Да, с этим уж ничего не поделаешь. ( Выносить в отдельный файл можно, но только внешний, а это ещё хуже. Тем более, я сразу в статью коды примеров добавляю, а не в шаблон иначе потом он разрастётся до невиданных размеров.

Отзывы скриптом рисуются? Давно стоит?

Это не задротство, это твой личный сайт и ты знаешь, что это нужно сделать, не за деньги дяди Стёпы, не за приказ насяльника, поэтому берёшь и делаешь!

На мой взгляд не всё так трагично. Одинаковые title не хорошо, но зато точно вылезут в топ по данному запросу, наверное хотят захватить выдачу :) В метатеге keywords вообще смысла не вижу. Дубли метатегов кодировки и иконки не проблема, главное чтоб было валидно. Много заголовков — плохо, но если это для структурирования контента то наверное можно, взять тот же PR-CY (не дураки верстали). Конструкция noindex/nofollow не страшна, просто мания преследования, бывает :) А может какой-то хитрый ход. С атрибутами alt и title картинок тоже проблемы не вижу, поисковик возьмёт окружающий текст и т.д. Единственная проблема это конечно дубли страниц из-за www, тут да, остальное имхо не фатально. Как-то так.

Смысл поста, думаю, в том, чтобы показать косяки, о недопущении которых говорят авторы сайта. Т.е. "сапожник без сапог".

Да я в принципе понял идею, но просто хотел отметить, что ошибки то не самые критичные. Александр даже ради них пост внепланово опубликовал, а тут ещё не всё так страшно. Бывают имхо более жуткие ситуации :-)

Константин, с таким отношением, как "это фигня, да то фигня", я вас уверяю, вы никогда не будете не то чтобы в ТОПе, но даже рядом. Страшнее чем дублирование title это только полные дубли страниц. Таким образом, на рассматриваемом проекты допущены два самых страшных греха — дубли страниц и дубли title. Так же я считаю страшным нарушением множественное использование H1: нет h1 — плохо, несколько h1 — плохо, есть h1 и он один — хорошо, и другого не дано!

Так что тут сапожник не только без сапог, но вообще без ног =)

PS Чуть не забыл спросить — а что тогда для вас «более жуткие ситуации»?

Александр, я не говорил что всё фигня. Я просто прошёлся по тому списку, что вы изложили. Сам сайт не изучал. Согласен со всеми перечисленными замечаниями. Лично я полностью придерживаюсь указанных нюансов, но чего только не бывает. Я люблю замечать всякое на разных сайтах. Пробую, экспериментирую и должен отметить, что многие кажущиеся неправильным вещи дают интересный результат. В тоже время, возможно, что у указанного сайта именно проблемы, просто некоторые из них мне видятся не столь фатальными. Ещё раз говорю, упомянутый сайт я не изучал.

В принципе, когда они в "10 грехах" назвали важный файл ROBOT.TXT, то я понял, что ребята явно несеръезно подходят к делу...

А что, разве отсутствие на сайте файла robots.txt уже не считается грехом? =)

ROBOT.TXT прописан без буквы "s" в конце, поэтому его не существует :)

Что ж там за криворуки сидят, если такой элементарной ошибки не замечают?!

Константин — тролль, который имеет отношение к сайту 100%, потому, что до этого поста он не оставил на блоге ни одного камента =)

Палево...и IP паходу будет палевным =)

А-ха-ха. wlad2 я действительно не знал до сего дня об этом блоге. Потому, конечно, могу не вписаться в аудиторию имеющуюся у столь популярного блога. Но Александр может подтвердить, что пересеклись мы с ним на блоге ADNE.info, а мой IP статичный, провайдер Volia :) Жаль, здесь нет ссылок на блоги, было бы интересно узнать о местной аудитории побольше.

P.S. В комментарии указал URL своего блога. Так что если что Александр может произвести полноценное расследование :)

Так случилось, что Константин, действительно, до этого не оставлял ни одного коммента, так как впервые узнал про мой блог вчера на adne. Так что все ок, проблем нет :)

И, кстати, мне пообещали, что официальный комментарий от Ingate будет в понедельник. Я очень этого жду, интересно, что ребята скажут...

Найдут виновного, больше они ничего сказать не смогут =)

Здравствуйте, меня интересует замечание: <noinde> rel="nofollow </noindex> — подскажите, а как нужно правильно делать данную конструкцию? Пожалуйста!

Как я понимаю, для запрета ссылки достаточно только rel="nofollow", т.к. Яндекс его уже давно понимает. В тоже время, тег noindex (для валидности лучше использовать его в виде html-комментария) позволяет исключить из, скажем так, учёта поисковиком фрагмент страницы. Так что да, в какой то степени такое решение имеет смысл. Вроде так. Удачи!

Спасибо, Константин. Но не могли бы конкретнее подсказать, как на странице скрыть от поисковиков фрагменты текста. Я до сих пор использовал <noindex>текст который не нужно показывать поисковикам, но важен для посетителей</noindex> . Почему он не правильный? Или есть другой более лучший вариант? Спасибо.

Как я понимаю, скрыть текст невозможно. Даже noindex всё же попадает в базу Яндекса, просто не учитывается им при поиске. Но можно воспользоваться подгрузкой текста через тот же Ajax. Правда тут тоже нюанс, источник подгрузки должен быть запрещён к индексации в том же robots.txt.

Дабы не быть головсловным, в рамках вопроса альтернативы noindex, пример подгрузки содержания страницы ajax.html на странице index.html в DIV с атрибутом id="ajax" средствами JavaScript, в частности библиотеки jQuery:

$.get ('ajax.html', function (data){ $('#ajax').html (data) });

Понятно, что ajax.html надо запретить в том же robots.txt, например:

Disallow: /ajax.html

Такой вариант работает для всех (большинства?) поисковиков, но при отключённом JavaScript информацию пользователь не получит. Впрочем, последнее встречается редко. Например блоги на Blogger.com с динамическим шаблоном и блоги на Я.ру всё это почти сплошной AJAX, которые с трудом, но индексируют только эти гиганты и иже кто понимает AJAX обработку. В общем, идею вы надеюсь поняли.

Да, Константин верно подметил, что реально работающих вариантов скрытия контента (это не только текст, но может быть любой кусок html кода) нет, кроме варианта с AJAX. И да, должны быть четко соблюдены условия — закрыть подгружаемую страницу через robots.txt и, что так же немаловажно, js-код надо вынести в отдельный файл и так же закрыть в robots.txt (о чем, как раз, Константин и не сказал).

А что даст закрытие JavaScript, если закрыт фрагмент от индексации?

Константин, АлаичЪ — спасибо вам за подробное разъяснение! Очень благодарен.

Закрытие js файла даст дополнительную безопасность для защиты от гуглобота, а он, как известно, спокойно читает скрипты и умеет их разбирать, так что ему не составит труда проанализировать скрипт и понять, что он делает. Лучше перебздеть, чем недобздеть...

У меня часто страницы из robots.txt попадают в поиск Гугл, этот файл по словам Google носит лишь рекомендательный характер.

Например, страничка https://alaev.info/wp-includes/js/swfobject.js?ver=2.1 благополучно проиндексирована. Достаточно одной текстовой ссылки, чтобы попасть в индекс.

Я писал про это, думаю, ты читала — https://alaev.info/blog/post/3013

А в данном случае, даже без ссылки это проиндексируется, достаточно чтобы в исходном коде была ссылка, иными словами, все подключаемые файлы стилей и js-скрипты будут проиндексированы в любом случае.

А вообще мы сейчас про другое говорим...

Просто хотела также согласиться с Константином, что выносить скрипт в отдельный файл и закрывать в robots.txt не всегда необходимо.

Кстати, по моим наблюдением любой простейший скрипт пароля на страницу не даёт ей проиндексироваться в Гугл, например, такой http://shpargalkablog.ru/2012/04/script-parolya-na-stranitsy.html . Скорее всего это связано с многочисленными исками в суд. Яндекс благополучно съел эту страницу, а Гугл ни нагой. Так не лучше ли на страничку, информацию которой прячем запечатать ещё и небольшим паролем? Сразу скажу данное направлении не изучала, это лишь предположения.

Ну, разберёт гуглобот, да собственно и бот яндекса может, тот javascript, а дальше? Источник подгрузки закрыт от индексации. Смысл закрывать JavaScript?

А можно ссылочку на кэш этого файлика в Google? Пробовал оператор cache выдало 404.

NMitra, закрывать страницу паролем — полный бред. Лично я при виде такого сразу закрываю вкладку, без вариантов.

Константин, я не на пустом месте это утверждаю, что необходимо закрывать js в robots.txt. Google хоть и проиндексирует ссылку на страницу, но содержимое ее не прочитает при запрете в robots.txt, это важно понимать!

Александр, приведите живой пример. Указанный NMitra JavaScript в индексе Google я не нашел. Robots.txt это не просто рекомендация поисковикам. Иначе у них были бы о-о-о-очень крупные юридические проблемы. Наглядный пример — Яндекс.Метрика зафиксировала страницы с персональными данными, не закрытые robots.txt; поисковик их слизал — начался крупный скандал попавший и в СМИ. Только то, что они не были закрыты robots.txt позволило Яндексу избежать крупных компенсаций. На мой взгляд, если robots.txt это только рекомендация, то поисковики завалят судебными исками. Как вы видите я тоже не занимаюсь словоблудием ;)

Константин, прочитай мой пост по ссылке, которую я указывал в комментарии выше, все поймешь о чем я говорю!

Не путать грешное с праведным! Если страница попала в индекс поисковой системы до того как была запрещена к индексации, даже соответствующая директива в файле robots.txt может ещё длительное время присутствовать в базе данных, но обновляться такая страница не будет.

Я говорю о том, что ссылка на запрещенную страницу в любом случае может быть проиндексирована, и будет отображаться в дополнительной выдаче. И не важно, была она раньше проиндексирована или еще нет. Об этом четко написано в мануале Гугла.

Да уж, как обычно сапожники без сапог)

Спасибо! Получился весьма показательный "разбор полётов". Учиться на чужих ошибках — одно удовольствие :)

Александр, здравствуйте!

Спасибо за пристальное внимание к одному из наших сайтов, особенно в выходной день )

По существу — мы не планировали и не планируем заниматься продвижением этого проекта. Для нас главное, чтобы в самой энциклопедии не было ошибок. Создать полезный обучающий контент для сео-новичков — такая цель стояла изначально, и надеемся, у нас получилось ее достичь.

Если есть желание обсудить содержание энциклопедии — с удовольствием поучаствуем в дискуссии. )

Ой, что-то верстка разъехалась в предыдущем комментарии... (

Да, разъехалась немного, слишком длинное имя. Я подправил, сократил имя, надеюсь, вы не против.

По существу — я понимаю, что нет такой цели, привести оптимизацию на сайте в порядок. Но, как я говорил выше, немного странно, учить новичков основам правильного seo, при этом самим эти базовые правила нарушать, именно это меня удивляет.

Ну, в общем-то, я даже не знаю, что еще сказать. Наверное, было бы неплохо, если бы вы исправили указанные ошибки. Я был бы доволен, что помог — провел тщательный технический аудит проекта, нашел множество ошибок. Как-то так...

Александр, вы действительно проделали существенную работу по аудиту сайта, спасибо. Думаю, наши специалисты с интересом прочитают ваш пост. Мы продолжаем трудиться над этим проектом, но как я уже сказала — основные силы и львиная доля внимания приходятся на контент. Ingate занимается выпуском сразу нескольких информационных продуктов — и не только по теме сео, но и по теме smm, например. Ресурсы распределяем в соответствии с приоритетностью задач и зачастую выпустить интересный и полезный инфопродукт оказывается важнее, чем вылизать технические недочеты на сайте.

Большинство читателей с нами согласно и просят не затягивать с новыми главами )

Косяков действительно много. Но если копаться, то можно практически на любом сайте найти недочеты.

Например, использование div-ов в head'е в вашем блоге. Почему не вынесены счетчики и сторонние скрипты в js-файл? Не наезд, просто ради примера.

Надо было перед "наездом" изучить подробнее вопрос. div'ы в head'е у меня только в исходном коде выглядят так, а вообще-то это контейнеры, в которые загружается яваскрипт. Могли бы посмотреть загруженную и отработанную браузером страницу и увидеть, что вы ошибаетесь.

Хотел только спросить — можно и стоит ли коды всех счетчкиков, метрики яндекса и аналитики засунуть в один js файл и потом подключать?

Это можно делать и имеет ли смысл в плане SEO?

Не вижу в этом смысла, тем более для SEO. Это ерунда все :)

Правильно, мочи их!

Так часто бывает, якобы "гуру" учат народ уму и разуму, а сами это не делают :)

FullBlooded, коды счетчиков, отвечающие за их непосредственную работу, не желательно помещать в отдельные файлы — читайте рекомендации сервисов статистики. Однако, это не касается тех частей кодов счетчиков, которые отвечают за визуальную часть — вывод изображения с количеством просмотров и т.п. Эти вещи выносить в отдельные файлы как раз можно. Даже нужно.

Александр, вы правы насчет divов в head. Это, действительно, ошибка. Браузер, встретив подобный тег в секции head, автоматически закрывает head и открывает body. Аналогично ведут себя и роботы w3c. В результате, в исходном коде страницы в браузере, появляется заново открытый body и повторно закрытый head (хотя в на самом деле в коде он один, тем не менее это вызывает ошибку).

АлаичЪ, помимо замечания выше. Вы указываете label for="..." в коде комментария, при этом name для input указан другой (текст написан справа налево). В результате, браузер также не находит для какого поля сделан label. Снова ошибка. Если совсем придираться, то зачем использовать бесполезный label?

Кроме того, в вашем же блоге куча артефактов от визивиг-редактора (берем вот эту самую страницу). Что-то не видно следования вашему же высказыванию о роли обычного блокнота при написании текстов.

Идем дальше. "Да, разъехалась немного, слишком длинное имя. Я подправил, сократил имя, ..." — хороший ответ, не правда ли? И после такого еще и критикуем другие сайты в плане верстки? А то что своя, собственная, не адекватно реагирует на чуть нестандартное написание имени комментатора — это, конечно же, айс.

Итог к вышесказанному: АлаичЪ, занимайтесь лучше СЕО, пишите полезные статьи и т.п. и т.д. Но не делайте разбор верстки чужих проектов с видом профессионала — не к лицу вам. Ибо сами далеко много чего не знаете + сами же допускаете подмеченные вами же ошибки. Вообщем, намек думаю, поняли.

Надеюсь, критику воспринимать умеете.

По поводу favicon — насколько я осведомлён, разные варианты его указания существуют для разных браузеров.

Тоже разобрал сайт спецов по продвижению http://seodacha.ru/blog/vot-kakie-sayty-u-vedushchih-seo-kontor

Грамотный разбор полетов, а то я уж думал только у меня клиенты с такими сайтами. А тут и спецы с такими же. Скоро не только сами оптимизаторы будут понимать, но и клиенты, что только покупка ссылок ссылок не эффективна.

Жмякнул ф12 Заглянул в код... первое что заметил

<a href="https://alaev.info/blog" target>Блог</a>

зачем вообще таргет если его нет? Почему нет title?

мелочь но думаю что хтмл не валидный по простецкой причине дайка гляну через валидатор...

а там: "Sorry! This document cannot be checked."...

Других критиковать легко :)

Всем кому интересно прочекать ошибки ходить на http://validator.w3.org/

Во-первых, title на текстовых ссылках ставят только конченые на СЕО "специалисты". А вот их отсутствие на графических ссылках — уже серьезный косяк юзабилити.

Во-вторых, рекомендую посмотреть других сеошников. Вы будете неприятно удивлены, но 90% из них — сапожники без сапогов. Да, это печальная реальность.

Научись исходный код смотреть сперва :) Исходный код это Ctrl+U, а не инспектор, в котором отрабатываются скрипты и добавляются атрибуты и стили самим браузером!

PS Расскажите-ка всем, кому интересно, зачем вы смотрите html валидатор и что вам это дает?

Воу-воу, как грубо.

В инспекторе ничего не отрабатывается. Там показывается текущее состояние DOM-дерева.

Ну, а насчет валидатора, позволю себе ответить на данный вопрос:

в рекомендациях Googl'a и Яндекса уже давно присутствует запись вида "Создавайте корректный и эффективный код HTML".

Повлияет ли это существенно на позиции сайта? Нет. Но может иметь неприятные последствия, в том числе и на отображение страниц в браузере пользователя, что также может резко снизить поведенческие факторы и люто увеличить количество отказов на странице. А там наказание не заставит себя долго ждать.

К чему здесь валидатор? А к тому, что это первое и пожалуй самое эффективное средство проверить качество разметки. А исправлять ли те или иные ошибки — уже на усмотрение разработчика. Иногда они оправданы, но чаще — кривожопость последних.

Я серьезно, посмотри исходный код и увидишь, что нет там лишних атрибутов.

У меня нет серьезных проблем по валидатору, это я знаю. Яндекс не валиден, Google не валиден — и что теперь? 99.99% сайтов не проходят проверку. Корректный и эффективный код HTML не эквивалент валидного HTML кода.

Согласен, что косячный html код надо править, но речь идет именно о косяках, когда, например, div не закрыт или что-то подобное (кстати, это валидатор как раз и не покажет — так стоит ли им вообще пользоваться?).

Я практически все маркетинговые и сеошные книжки покупаю по мере их выхода, а читаю по возможности. Приобретая эту, изначально знал, что буду ловить лулзы, 20+ летний опыт позволяет. Но сейчас я хочу поделиться с вами лучшим применением, которое я для неё нашел. Используйте эту книгу чтобы корректировать осанку! Она достаточно большая и тяжелая чтобы её было удобно удерживать на голове. Поверьте, красивая осанка поможет вам больше общедоступных знаний из очередной сео-статьи. Начните с 5 минут балансирования на месте перед зеркалом, а потом старайтесь ходить на как можно большие расстояния без фейлов, и сила пребудет с вами.

Пожалуй, самое оригинальное применение seo-литературы, про которое я слышал :)