Привет, друзья. Наконец-то я добрался до написания этого поста. В материале про покупку ссылок в Сапе я рассказывал про правильную настройку автофильтров и проектов, благодаря которой множество мусора, унылых ГС просто не будет покупаться. Но, даже не смотря на это, шлака настолько много, что покупать площадки без детального отбора – страшный грех. И сегодня мы займемся рассмотрением методов этого отбора. В этой публикации я расскажу о самом простом, быстром и, что самое главное, бесплатном способе.

Привет, друзья. Наконец-то я добрался до написания этого поста. В материале про покупку ссылок в Сапе я рассказывал про правильную настройку автофильтров и проектов, благодаря которой множество мусора, унылых ГС просто не будет покупаться. Но, даже не смотря на это, шлака настолько много, что покупать площадки без детального отбора – страшный грех. И сегодня мы займемся рассмотрением методов этого отбора. В этой публикации я расскажу о самом простом, быстром и, что самое главное, бесплатном способе.

Эта статья будет полезна особенно тем, кто:

- Постоянно использует браузер Mozilla FireFox

- Ведет множество проектов, покупая ежедневно тысячи ссылок

- Не имеет желания/времени на ручную модерацию площадок

- Хочет получить хороший результат очень быстро и эффективно

Оглавление:

- Обзор основного инструмента

- Настройка плагина

- Фишки, тонкости и секреты работы с плагином и Sape

- Заключение и Продолжение

Обзор плагина

Приступим мы к работе с обзора инструмента, при помощи которого будут производиться основные действия. Речь идет о плагине для FF — Вебмастер Sape. Скачать свежую версию плагина можно на официальном сайте. Если у вас до сих пор нет этого плагина, то самое время его установить. На данный момент актуальной является версия 1.32 от 6 Декабря 2009. Совместима с Firefox 2.0 – 3.6.*.

Вот что пишет об основных особенностях сам автор:

Панель инструментов содержит набор функций, расширяющих возможности вебмастеров и оптимизаторов при работе в интерфейсе биржи SAPE.

Интерфейс оптимизатора

— Проверка YAP, YAL, GC непосредственно в интерфейсе биржи

— Проверка второго уровня вложенности страниц-доноров

— Проверка наличия страниц в кэше Yandex

— Возможность отображения актуального PageRank купленных страниц и ТИЦ сайтов не дожидаясь пересчета

— Проверка на склейку ТИЦ и PageRank страниц с размещенными ссылками.

— Выборочный экспорт размещенных ссылок в текстовый файл (экспортируются помеченные галочками ссылки)

— Контроль URL купленных страниц и новых заявок

— Экспорт локальных и глобальных черных списков

— Экспорт извещений в текстовый файл

— Проверка реального количества внешних ссылок на страницах-донорах с учетом тегов noindex

— Проверка наличия размещенной ссылки на купленных страницах. Возможно использование User-Agent Яндекса или Google (анти-клоакинг)

— Показ тематики и региона, присвоенных Яндексом площадке (если эти данные отдаются тулбару Яндекса)

— Анализ поискового трафика Google по данным сервиса SEMRush

Функции доступные для интерфейса вебмастера я рассматривать не стал, для нас в данный момент это не интересно и не нужно, ведь мы будем покупать, а не продавать ссылки.

Настройка плагина

Вот мы скачали и установили плагин. Вот так рабочая область плагина выглядит у меня. Все необходимое под рукой. При желании панель можно сворачивать, если она мешает вам, для этого нажимаем на синюю иконочку в правом нижнем углу браузера.

Давайте перейдем к его настройке. Нажимаем на иконку с изображением молотка в тулбаре.

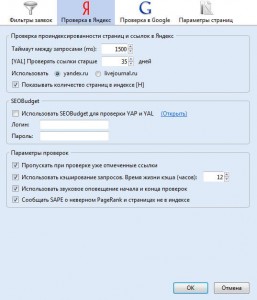

Первую вкладку «Фильтры заявок» пропускаем, она только для вебмастеров. Сразу переходим к вкладке «Проверка в Яндекс»:

Таймаут между запросами. Самое оптимальное значение, которое я для себя нашел это 1500ms. Можете оставить по умолчанию 2000ms, но соответственно и скорость проверки снизится на 25%. При большом количестве заявок это становится критично. Если же поставить 1000ms и ниже, то вам просто Яндекс заблокирует запросы и покажет «Я робот». К тому же в многопоточном режиме вы тоже не сможете работать (про моногопоточный режим читайте ниже). Так же в разговоре с автором плагина было выяснено, что при маленьком таймауте плагин может давать сбои, потому что не будет успевать обработать запросы (тут еще зависит и от мощности вашего компьютера).

[YAL] Проверять ссылки старше. Оптимальное значение 35 дней. За 35 дней робот успеет обойти сайт величиной даже больше 500000 страниц в индексе, если конечно с навигацией там все в порядке, а нормальный сайт обязан иметь хорошую навигацию. Значение выяснено опытным путем и подтверждено сервисами, вычисляющими примерную скорость обхода всех страниц заданного сайта. К тому же в Sape принимаются только страницы с уровнем вложенности до 3. Так что 35 дней – это 100% подходящее значение.

Так же есть возможность использовать API сайта SeoBudget для проверки индексации страниц и ссылок, но проверка платная и при массовых проверках встанет в копеечку.

Параметры ссылок. Тут можно везде поставить галочки. Кеширование запросов очень полезная вещь, и если при проверке на индексацию произошел сбой в работе, вам не придется заново проверять площадки, плагин просто начнет проверку с момента, где он остановился. Оптимальное значение – 12 часов.

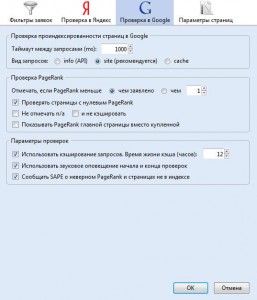

Переходим к вкладке «Проверка в Google»

Можете поставить значения как у меня. Я особо не пользуюсь проверкой в Гугле, так как все сайты продвигаются в первую очередь в Яндексе. Если же вы продвигаете какие-то проекты под Гугл, можете настроить по своим наблюдениям, или отпишите в комментариях, что к этой вкладке нужен подробный обзор, и я дополню, а пока мы не будем заострять внимание на этом.

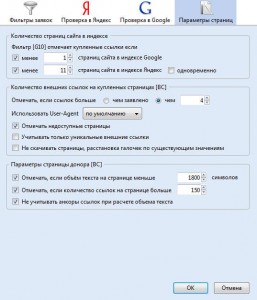

Вкладка «Параметры страниц» самая важная вкладка, которая требует тщательного обзора и настройки для правильного отбора площадок перед покупкой.

Количество страниц сайта в индексе. Я ставлю для Гугла 1, для Яндекса 11. Поясню почему. Если сайт под фильтром в Google то у него обычно выпадают из индекса страницы, потому сразу стоит убирать площадки неиндексируемые в этом поисковике. Для Яндекса 11 потому что…всем нам известны АГС-17 и АГС-30, ярким признаком которых является выкидывание из поискового индекса страниц подозрительных сайтов, обычно у таких сайтов в индексе до 10 страниц. Нам не нужны подозрительные сайты – им место в ГБЛ (глобальный черный список).

Количество внешних ссылок на купленных страницах [ВС]. Всем нам известно, что чем больше на странице исходящих, тем меньший вес передает каждая ссылка. Конечно, хорошо бы, если это количество было не больше 2, а в идеале 1, но в нынешних условиях это сложно. Во-первых, таких площадок гораздо меньше, во-вторых, это влечет за собой серьезное увеличение бюджета. Вполне оптимально ставить значение 4. Много, но в режиме экономии самое то. Так же я ставлю галочку напротив пункта «отмечать недоступные страницы». Это то же самое, что покупать кота в мешке. Лучше отменить покупку, глядишь, потом будет доступно и посмотрим что внутри.

Параметры страниц донора. Пожалуй, самый спорный пункт настройки, у каждого оптимизатора свой взгляд на вещи, свой критерий качества площадки, я тоже настраивал по своему опыту и наблюдениям.

Ставим галочку напротив пункта с объемом текста, а в поле пишем 1800 символов. Почему нужна эта галочка и почему такое значение? Нам не нужны площадки на которых мало текста, к таким могут относиться страницы контактов, страницы профилей пользователей, страницы галерей (сами знаете как Яндекс к ним относится) и прочие служебные и ненужные страницы. Нам нужны страницы с контентом, и не огрызком каким-нибудь, а более или менее нормальным текстом, для того и ставим 1800 символов (не забываем галочку напротив пункта, не учитывать анкоры ссылок), это позволит отбирать страницы с чистым текстом необходимого размера.

Я не люблю страницы, на которых много внутренних ссылок, такие страницы – признак сателлита, главной целью которого набрать максимум страниц 2 и 3 уровней и соответственно продать их, наплевав на качество. Это хоть как то убережет нас от покупки «дырявых страниц». Ну и в дополнение ко всему – чем больше ссылок на странице, тем меньше ее вес, даже если ссылки внутренние.

Еще раз о пункте «Не учитывать анкоры ссылок при расчете объема текста». Это небольшая подстраховка от покупки страниц, которые являются картой сайта и не содержат ничего кроме ссылок.

Ну вот, готово, настройку мы закончили. Пора переходить к полевым испытаниям.

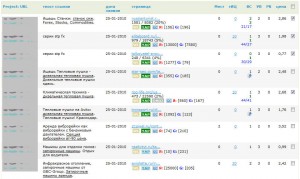

Заходим в свой аккаунт в Sape. Видим, что автофильтр купил нам ссылки, нажимаем на просмотр заявок. КСТАТИ. Когда выставляем автофильтр на покупку, необходимо включать полуавтоматический режим, чтобы одобрять или не одобрять площадки самим. Нажимаем на «новые заявки» и видим перед собой список площадок. Не буду лить лишнюю воду – просто нажимаем на две кнопки, YP и ВС. Видим извещение в правом углу, что проверка начата.

Можете следить за процессом, а можете идти делать свои дела – плагин сделает все за нас!

Когда закончится проверка, прокручиваем страницу в самый низ, в выпадающем списке выбираем «Отменить размещение» и кликаем ОК. Весь мусор отвалился, остались только площадки, которые удовлетворяют нашим критериям. Кликаем на чекбокс около «выделить все / инвертировать» в выпадающем списке выбираем «Подтвердить размещение» и жмем ОК. Хорошие площадки куплены. Ждем следующего обхода роботом Сапы вашего аккаунта и закупки следующей партии.

Основная часть повествования о выборе и покупке качественных доноров закончена. Но это, конечно, еще не все.

Фишки, тонкости и секреты работы с плагином и Sape от АлаичЪ’а

- После проверки площадок на предмет качества остается слишком мало хороших. По наблюдениям – это 5-10%, иногда меньше. Потому на это в первую очередь стоит обратить внимание, просто ставим по фильтрам покупку по формуле N*7, где N – число ссылок, которое необходимо купить. Но знайте меру ;)

- Sape покупает ссылки по автофильтру несколько раз в день, железно покупает утром и вечером. Иногда может и 4-5 раза в день купить. С оглядкой на это в предыдущем пункте умножаем на 7, а не на 10 или 15. Принцип прост: сапа купила утром 1000 ссылок, из них выкинули 930, оставили и купили только 70. Значит второй раз в день сапа купит 930 ссылок, из них выкинули 880, а 50 купили… Принцип, думаю, понятен.

- Проверка площадок плагином может идти в многопоточном режиме. То есть, открываем в разных окнах (не вкладках) браузера площадки к проверке и запускаем проверку в каждом окне, в итоге скорость возрастает в n раз ;) Главное не перестарайтесь, найдите для себя оптимальный вариант, в зависимости от ширины канала и производительности компьютера.

- Проверка фильтром ВС жрет очень много мощности. В итоге при проверке у вас будет тормозить браузер порядком даже на мощной системе. Например, на моем Acer Aspire 5920G с Core2Duo T7500, 4gb RAM тормозит. Склонен думать, что зависит в меньшей степени от компа, а в большей от оптимизации распределения ресурсов самим браузером. Если смотреть нагрузку на процессор при проверке, то видно, что первое ядро процессора загружено на 100%, а второе отдыхает, загрузка не выше 10-15% при том, что открыто еще много других приложений. В многопоточном режиме обращайте на это внимание.

- Чем больше площадок проверяется в одном окне, тем медленнее идет проверка. Поймите правильно. Это не значит, что если проверка 10 площадок займет 10сек, а проверка 100 займет 100сек. Проверка 100 площадок может занять, например, 250сек. (Числа здесь приведены для примера, на истину не претендуют). Так что открывайте в одном окне проверки не более 500 площадок. Самая оптимальная скорость и не надо по десять раз окна заново открывать.

Вот и все на сегодня, очень надеюсь, что не утомил вас свои рассказом. Планировал в эту статью еще добавить описание о том, как следить за ссылками после покупки, но это видимо будет в следующей статье цикла о работе с биржой Sape.

Жду ваших комментариев и отзывов.

Крайне полезные публикации о Sape:

14 января 2010. Покупка ссылок в Sape. Или как это делаю я

25 января 2010. Как отбирать только качественные площадки в Sape

30 января 2010. Что делать с уже купленными ссылками в Sape. Окончательная проверка на прочность

10 февраля 2010. Sape – акцент на новые возможности автофильтров

5 марта 2010. Sape – о регионах в цифрах

13 мая 2010. Палю свой black list для Sape

19 мая 2010. Как надо продавать ссылки в Sape. Взгляд оптимизатора

22 сентября 2010. Антикапча – sape-оптимизаторам на заметку

10 ноября 2010. Продвинутый отбор доноров в Sape. Плагин Вебмастер Sape и LF фильтр

Есть вопросы:

1. Что думаешь насчет «фильтра контента»? На мой взгляд, с его помощью можно отсеивать площадки, которые не обязательно содержат адалт- или фарма-контент, но и те, которые продают ссылки с адалт-анкорами, а следовательно, могут быть пессимизированы.

2. Используешь ли «фильтр урлов»? В принципе он отсеивает доли процента, но я стараюсь прогнать заявки и через него.

Текст полезный. Удивился, как это я не подумал насчет количества страниц под АГС — ставил в настройках по 5 страниц для яндекса и гугла.

Кул, по пунктам:

1. Да в общем то бесплезная вещь этот «фильтр контента». В предыдущей статье про настройку автофильтров мы выбирали все тематики площадок, кроме адалт и english сайтов. Я думаю это на 99% исключает появление таких «ненужных» площадок как адалт. На счет фармы ничего не скажу. Я думаю сайты, которые занимаются фармой редко используют Sape для заработка, на фарме зарабатывается в разы больше, и пессимизация от поисковиков для них страшнее, чем радость от «копеечки» с сапы. Ну и потом этот фильтр на отсекает площадки, которые, как ты выразился «продают ссылки с адалт-анкорами». Фильтр то анализирует страницу, а не донора в целом. А шанс попадания ненужного анкора на страницу, на которой мы хотим разместиться исключен в 99.99% случаев. Думаю споров тут не может и быть.

2. На счет фильтра урлов [LF], вещь кстати неплохая, я его как то выпустил из вида. Но он, действительно, после всех отборов, проделанных по моему алгоритму практически ничего не исключает. В итоге — право на жизнь имеет, но не более того.

на самом деле есть пара простых истин при покупкуе ссылок, а остальное лирика.

Страница должна быть проиндексирована, пузомерки повыше, общее количество страниц сайта поменьше(вероятность скорой индексации нашей ссылки на сайте с меньшим количеством страниц выше чем сайтов с огромным количеством станиц в индексе), ну и возраст и тематика рулят)

Если ваши простые истины это пузомерки и количество страниц и тематика, то далеко вы не уедете. Ну или как минимум ваши затраты будут намного выше чем мои при достижении одинаковых результатов.

А вы не задумывались над тем, что чем меньше страниц у сайта, тем выше его заспамленность (отношение количества продажных ссылок к количеству страниц). Этот фактор никак не может положительно влиять. Еще обычно вебмастера из-за нехватки страниц начинают продавать больше ссылок с одной страницы, разве не замечали такую тенденцию?

Высокие пузомерки стоят дороже. Ну это логично, впрочем. А вот как по вашему, что лучше 30 ссылок со страниц с низкими(или даже нулевыми) показателями или одна но с сайта с тиц 2000? Вообще-то тиц никак не влияет на передаваемый вес.

Про возраст я в самой публикации писал, повторяться не буду.

А про тематику скажу, что она не влияет (ну или, возможно, очень незначительно влияет) на ссылочное. На тиц может влиять положительно, но ведь мы не наращиванием тица занимаемся.

Надеюсь я в чем-то вас убедил.

Мои выводы основаны не на пустом месте, а подтверждены экспериментами, и сайты моих клиентов до сих пор прочно в топе по очень конкурентным тематикам, и все за счет огромной массы дешевых ссылок.

Я, новичок и поэтому хотелось бы подробнее услышать о вкладке «Проверка в Google», тем более, что mail.ru переходит на google движок.

Интересная статья, спасибо.

Ну на счет перехода mail.ru на поиск от google это вы ошиблись. Точнее эта информация не актуальна, сделка не состоялась. Руководство mail.ru приняли решение использовать свой собственный алгоритм, т.е. gogo.ru. Можете сравнить выдачу, чтобы удостовериться.

На счет проверки под google. Это актуально только в случае продвижения в первую очередь под Гугл. Для этого используем кнопочку GC — проверка наличия страницы донора в кеше гугла, аналог YP для Яндекса. Настройки же как у меня на скриншоте подойдут.

Меня всегда терзают смутные сомнения :) когда я заполняю 3 поля в сапе «Количество / Общая сумма (руб. в месяц) / Дневная квота» у фильтра в авторежиме. Что это конкретно за поля, сможете прояснить? И почему сапа, когда куплено по автофильтру, подсвечивает ниже только две цифры.

Для себя я заполняю эти поля как:

1) «Количество» — это общее кол-во ссылок, которое мне нужно на данный url

2) «Общая сумма (руб. в месяц)» — деньги, которые я планирую тратить на ссылки по этому url'у в месяц

3) «Дневная квота» — тут не понятно, либо это дневная квота в ссылках(сколько закупать в день), либо это дневная квота в рублях(сколько тратить в день).

Всё так?

Ну вот смотрите, объясню все подробно.

Количество — это сколько всего планируете купить ссылок на данный url. То есть это верхняя граница, выше которой Сапа никогда не купит. Специально для того, если у вас 100 текстов заготовлено, выставляем тут 100 и получится что Сапа купит вам на каждый текст по одной ссылке.

Общая сумма — это сколько всего планируете потратить в текущий месяц. Это для того если у вас на каждый продвигаемый url рассчитан точный бюджет. Просто выставляем тут верхнюю планку и Сапа никогда не потратит больше чем указано в этом поле.

Между прочим, очень полезно будет знать, что оба поля можно заполнять , а можно заполнить только одно из них. То есть ограничить можно по количеству ссылок, при этом бюджет будет тратиться согласно фильтрам, но без ограничений. Или можем указать только максимальный бюджет, при этом будет куплено максимально ссылок в рамках указанного бюджета.

Дневная квота — это значение означает сколько ссылок в текущий день должна купить система. Больше чем указано система в текущий день не купит.

Красные же значения, указываемые системой под этими полями означают следующее: сколько куплено ссылок всего на url / сколько не эти ссылки будет потрачено в месяц.

Все просто. Если остались еще вопросы — задавайте.

Большое спасбо за статью. Скачал и установил плагин для FF — Вебмастер Sape.

Страницу с этим постом добавил в закладки.

Большое спасибо за обе статьи — эту и про покупку ссылок в sape. Сохранила себе для личного пользования. Читать одно удовольствие.

Приятно встретить оптимизатора, который понимает что делает.

Хорошая статья!

Ответьте на такой вопрос, а то нигде не могу найти:

Сколько нужно ссылок закупать, чтобы выйти в топ по запросу?

Например запрос: позитив — 14417 показов

Я так сходу вам не смогу сказать сколько это будет стоить. Но вот могу сказать точно одно, запрос — пустышка. Вы сами бы стали в поисковике что то искать по этому запросу? Я — нет.

Количество показов тут ни о чем не говорит. Я не думаю, что имеет какой то смысл по нему продвигаться. Но если все же решите, то это не будет стоить дорого. Правильный тайтл, несколько упоминаний в тексте + пара десятков ссылок сверху и вы в топе.

А какие выскочастотные запросы вы посоветуете тогда для позитивной тематики?

Я не знаю. "Позитивная тематика" слишком размытое понятие. К тому же для такой тематики я бы посоветовал не искать ВЧ запросы, а собирать трафик по большому количеству НЧ, это будет гораздо дешевле, эффективнее и проще.

Советую попробовать программу TrafficWeb если сайт имеет хоть какую то посещаемость с поисковиков — тут описано как надо работать с программой.

Согласен с АлаичЪ'ем, что слишком размытый вопрос, и, соответственно, и количество запросов для определения их как ВЧ для разных тематик разные.

И тоже могу вам посоветовать продвигаться по СЧ и НЧ. Хотя сам себя долго продвигал по ВЧ с 120 тыс. запросами в месяц, так как трафик шел.

Спасибо за статью — всё чётко и по делу. Сам как-то не догадывался в плагине включить ограничитель по количеству контента на странице.

Здравствуй! Спасибо большое за статьи о Сапе, прочитал все 3.

Вот вопрос, я только начинаю, на твой взгляд имеет ли смысл продавать ссылки в Сапе на сайте с тематикой мультфильмы?

И еще вопрос, при покупке МНОЮ ссылок на Сапе, покупать лучше с тематикой сходной с моей? То есть фильмы\мультфильмы, да?

Заранее спасибо.

Продавать ссылки или нет, это ваше лично дело. Вы и сами должны знать, что это не очень хорошо сказывается на сайте в целом.

А на счет покупки, сначала покупайте тематические если есть, а потом уже все остальные.

Спасибо за ответ!

Настроила как у вас, но все показывает красным. Как думаете, в чем дело?

Я не думаю, я знаю ;) Обновите версию плагина. Такое периодически случается. Вот буквально от вчерашнего дня новая версия 2.6 вышла, проблема с "покраснением" решена.

Спасибо за совет. Все получилось. Но вот еще проблема уже третий день ничего не могут проверить — все тайм-аут. Скажите, отчего это зависит?

Что за таймаут? В смысле, выдает сообщение "Я робот"? Да, есть такая проблема. Поставьте задержку для проверки для Яндекса 3000 мс. Долго конечно, я понимаю, но других вариантов, увы, нет :(

А какой приблизительный процент отсева ссылок при приминении твоего фильтра и таких настроек плагина? У меня он какой-то подозрительно большой... Допустим сегодня автофильтр нашёл 61 заявку, а плагин исключил 57 — это нормально?

Да, это нормально. Процент отсева очень большой. Ведь нам нужны самые качественные площадки.

Процент отсева можно уменьшить (не на много) если более грамотно настроить автофильтры. Увы, экспериментировать с этим придется вам самим, я и так в своих публикациях спалил много информации.

Понял, спасибо

Помогите с такой проблемой:

Когда запускаю проверку ссылок через [CG], то начало выдавать «ВЫ РОБОТ», уже выставлял таймаут от 33 до 999 секунд — не помогает, при каждом новом запуске, я узнаю, что я робот — не знаю что и делать!

Когда такая ситуация была с [YP], то просто нажимал на YAP к самой ссылке и вручную вводил пароль на странице яндекса, которая имела вид: http://captcha.yandex.ru/?retpath=... и так далее, — проверка восстанавливалась даже без ожидания таймаута.

НО ВОТ КАК БЫТЬ С [CG]? Есть ли аналогичная страница капчи, где ее можно ввести вручную?

Помогите.

Для начала, нет [CG], есть [GC] от слова Google Cache.

А то, что он вам выдает робота, так скорее всего надо обновиться до актуальной версии плагина. Не забывайте, что Firefox далеко не всегда выдает сообщение о выходе новой версии. Да и Wink не часто новые версии выкладывает на страницу плагина на addons.mozilla.org

Так что советую чаще проверять: Правая кнопка на пустом месте любой страницы — Вебмастер SAPE — Поддержка...

Откроется тема форума, где всегда все актуальные новости.

Когда я нажимаю GC в панеле, то GC на странице сапы меняется на GI. Подскажите — что это такое?

Google Cache -> Google Index. Что вас смущает?

Не работает именно проверка Google Cache. Вручную нажимаю — работает, а на автомате — нет.

Уже и версию 2.7 пробовал — все равно...

ДОКОПАЛСЯ:

Приносим свои извинения...

... но ваш запрос похож на запросы, автоматически рассылаемые компьютерным вирусом или вредоносным программным обеспечением. В целях защиты наших пользователей мы не можем обработать ваш запрос немедленно.

Дополнительную информацию можно найти в Справке Google.

Ну в таком случае надо подождать некоторое время (минут 30). Или это прямо сразу после нажатия кнопки GC вылетает, даже если до этого никаких запросов к Google не было?

Возможно кто-то из вашей рабочей сети мучает Гугл чем-то?

PS Попробуйте скачать приложение toonel.jar. Офф.Сайт toonel.net. Настройте браузер на работу через прокси и попробуйте снова начать проверку. Возможно поможет.

В том-то и дело, что как только установил плагин — сутки работал полностью — мне понравилось!

Но спустя сутки работы — вот уже трое суток — НУЛЬ! Даже при условии, что несколько часов не пользовался...

Чудеса прям. Так замучили Гугл, что он вас на долго заблокировал =) Попробуйте как я и писал выше, через прокси toonel поработать. Если не поможет, то скоро я напишу пост про использование антикапчи.

Этот же плагин не актуален для Украины?

*проверка идет по yandex.ru & google.ru*

Заранее спасибо за ответ.

Все актуально. Поисковая база общая, насколько мне известно.

А какие настройки TF?

И второй вопрос.

Сейчас, походу, проблемы с Яндексом. Какие стоит использовать таймауты капчи и запросов в YAL и YAP?

Заранее спасибо.

Прочитайте этот пост — https://alaev.info/blog/post/1486.

Спасибо. Про antigate знал, но, а что со списком TF? =)

Ну, это как минимум тема отдельного поста, а вообще что вы хотите от меня услышать? Хотите чтобы я скопировал строчку стоп слов из плагина? А вообще последнее время я вручную проверяю покупаемые странички, так что TF пользоваться перестал.

А вообще алгоритм проверки прост: Cn -> ВС -> YP -> LF -> TF.

Да, если можно, хотелось бы список TF и LF.

Я проверяю Cn --> BC --> H --> LF --> TF (Не работает, выделяет все ссылки, поэтому и спрашиваю, может у меня синтаксис неправильный?) --> УВ

Список не дам, пока не дам. У меня в планах написание поста о LF фильтре, там будет список. У TF и LF синтаксис идентичный, слова разделяются знаком "|". Наберитесь немного терпения и проверяйте обновления блога ;)

Спасибо. Буду ждать.

Прочитал несколько статей в Вашем блоге. Статьи понравились, даже очень, доступней и понятней по-моему написать не возможно, к тому же я новичок и поэтому нахожу в блоге много нового для себя. Ваш блог запал мне глубоко в избранное :)

Раньше закупал ссылки вручную, а мысль о полуавтомате меня жутко пугала из-за очень низкого качества предоставляемых площадок. Но в последнее время я перестал справляться с покупкой ссылок в ручном режиме. И все это время я даже не представлял о существовании плагина для Sape.

После данной статьи быстро разобрался с плагином и уже активно им пользуюсь. Правда возникли некоторые вопросы:

1. Не кажется ли Вам слишком мягким условие количества ссылок на странице не более 150. Ведь вес страницы делится на все ссылки и при большом их количестве размещение на такой странице малоэффективно. Конечно, каждый решает сам как ему настраивать плагин, Вы только даете советы согласно своему опыту, но уж очень бы хотелось услышать Ваше мнение.

2. В статье ничего не сказано про разницу проиндексированных страниц в Яндексе и Гугле. Но ведь если одним поисковиком проиндексировано большое количество страниц, а другим мало — это повод задуматься о качестве площадки. Я, закупая ссылки вручную, отправлял в блэклист сайты, если разница проиндексированных страниц в Яше и гугле была больше, чем в 2 раза.

3. Просматриваете ли Вы сайты, которые прошли все фильтры перед размещением на них ссылок? Ведь с большим объемом закупаемых ссылок это слишком трудоемко.

1. Нет, не кажется, хотя для каждого сайта свой критерий, а 150 можно назвать чем-то универсальным между "нормально" и "плохо". И потом, не путайте внешние и внутренние ссылки.

2. Количество страниц может быть поводом для беспокойства, но уж точно не повод для GBL. Причин по которым разница может быть большой масса. Как Яндекс, так и Гугл периодически сильно колбасит. Советую взять штук 50 хороших сайтов, ну, по которым видно, что сайты для людей, имеют хорошую посещаемость и т.д. Потом список url'ов проверить на количество страниц в индексе и сделать соответствующие выводы.

3. Да, последнее время стал просматривать, процент прохождения ручной проверки около 5%. То есть, пример, было 500 заявок, после проверки плагином осталось 50, после ручной проверки остается всего 5. Жесть, да?

Спасибо за ответ, как всегда все очень понятно и доступно.

Точно жесть, если из 500 ссылок Вы покупаете только 5, то я честно говоря поражен, как Вы справляетесь с такими объемами:

Кстати, если от 50 ссылок остается 5, то это 10% :) Ну это так, к слову!

> Как Вы справляетесь с такими объемами?

Это еще фигня, ссылок на самом деле намного больше =)

> Кстати, если от 50 ссылок остается 5 то это 10%

Все верно. Просто я подумал об одном, посчитал второе, а написал третье, и плюс к тому допустил ошибку =)

Но смысл один: 500 заявок, а проходит проверку только 5! О как!

Откройте вкладку «Фильтры заявок».

Там есть строка «Отмечать страницы URL, содержащие следующие слова». В ней по умолчанию стоит:

=[0-9a-f]{32}|viewtopic|showtopic|showthread|profile|showuser|search

Вот вместо этого поставьте код:

=[0-9af]{32}|viewtopic|showtopic|showthread|profile|showuser|ucoz\.ru| search|kino|porno|film|poker|spice|sex|game|love|jimm|icq|pagenum|diplom| showcat|casino|Fishka|girl|boy|test|melody|sound|concert|picture|koncert| bilet|goroskop|play|soft|viagra|mp3|muzik|walls|/prog|drugs|/tag|/tags|/category| /kontakty|user|warez|board|/contact|contacts|item.php|items.php|categoryid|/products|

Он такой же, но дополненный.

Так же можно дополнить следующую за первой строкой строку словами, которые Вы не хотите видеть на странице (например, знакомства|дипломы|(можете вставить матерные слова) и т.д.)

Кстати, а у Вас всегда капча выдает задачу на сложение «3+4» — по крайней мере я ее при чтении комментариев видел уже 3 раза.

Скоро напишу пост про LF фильтр. Пополнишь свой фильтр необходимыми исключениями ;)

День добрый, конечно же чувствуется рука мастера, спасибо за статью. Но остался маленький вопрос. Используете ли вы "Н" т.е. проверка наличия сайта в индексе Яндекс. Прочитав ваш пост о регионах в цифрах понял, что покупка ссылок с площадок региона, где зарегистрирован сайт приносит максимальный эффект но только в поисковой выдаче того же региона, а как быть если нужно продвинуть сайт по СЧ, но геозависимым запросам например в "Москва и область" (код если не ошибаюсь 213). Использовать "Н"? Или подобрать геонезависимые запросы? Или для начала закупать площадки по России (225)? Если не затруднит — проясните...

День добрый и вам, Юрий. Перед проверкой фильтром Cn можно прогонять фильтр H. Но лично я этого не делаю, у меня с самой Sape фильтры не допускают появления сайтов с маленьким количеством страниц в индексе.

Про региональность доноров можете забыть, это миф, не на 100%, конечно, но близко к тому. Результат не оправдывает возложенных надежд и трудов.

Другие критерии отбора гораздо более важны в покупке, нежели региональность. Кажется, ваш вопрос касался только региональности?

Т.е. ссылка с площадки во Владивостоке равнозначна ссылке с сайта Москвы или Украины?

Считайте, что это так ;)

И еще маленький вопросик. Отслеживаете ли вы цену на предлагаемую площадку?

Зачастую цены на аналогичных ресурсах отличаются в разы...

Нет, не отслеживаю цену в момент покупки, у меня в фильтрах ограничения довольно строгие, так что в этом нет необходимости. Обращаю внимание на цену только когда она изменяется, там уже можно оценить ее адекватность.

И уж чтоб совсем прояснить ситуацию — как относитесь к ссылкам в футере? Заранее СПАСИБО!

Тут гораздо важнее в каком именно месте в html-коде страницы расположена ссылка, а не визуальное ее представление на странице.

А вообще пусть себе живут если страница хорошая. На такие ссылки обращаю внимание только когда надо сократить бюджет, то врубаю супер-строгие правила и уже купленные ссылки фильтрую, критерий нахождения ссылки в футере так же присутствует в этом фильтре.

И если ссылка стоит в HTML коде в конце страницы — её удаляем. Это так?

Как я уже говорил выше, расположение при покупке я не рассматриваю, тем более, что это и невозможно. Пока не купишь не узнаешь!

А если при проверке плагином Винка показывается, что ссылка в футере — удаляем?

АлаичЪ, доброго времени суток! Подскажите, пожалуйста в чем может быть проблема? Захожу в проект, хочу проверить плагином наличие ссылок в индексе (YL), нажимаю на кнопку, а он проверяет только последние 10 ссылок (давно купленные внизу списка). Всего ссылок 50, т.е. остальные 40 не проверяет. Пробовал переустанавливать плагин, не помогало, переустановил фаерфокс, полностью, почистил все ключи, удалил папки скрытые. Установил заново фаер и плагин, проверил все работает. Сегодня хотел опять проверить, та же фигня... У Вас такого не случалось что может быть причиной?

В браузере установлены плагины: Вебмастер SAPE, RDS bar, WEB developer, Download statusbar.

И вам доброго вечера. А как на счет настройки: "Проверка в Яндекс" -> "[YAL] Проверять ссылки старше ... дней"? Там какое значение стоит и удовлетворяет ли оно проверяемым ссылкам?

Ааа, понял, сам же в настройках указал, что проверять ссылки старше 35 дней ;) Вот он и проверяет.

Можно еще такой вопрос: наличие иконок социальных сетей Вконтакте, твиттер, лайвжоурнал и т.п. — это же тоже внешние ссылки, и когда они от индексации не закрыты, то лучше не размещаться на такой площадке? Бывает просто по 6-7 иконок этих сетей. Заранее спасибо.

Ну как вам сказать. Эти ссылки естественные, страшного в них ничего нет, но вес все же утекает, хоть и не большой. Выбор за вами, но если по прочим параметрам страница вас удовлетворяет я бы ее оставил, не смотря на ссылки социалок.

Доброго времени суток!

Полезная статейка. Спасибо.

Хотел уточнить некоторые моменты — по Гуглу. Если продвижение идет по Гуглу — то надо так понимать, нас интересует проиндексированность ссылки Гуглом после покупки. Проверяется это кнопкой (GL) данного плагина. Если скажем через месяц после закупки — ссылка Гуглом не проиндексировалась (горит красным) — то она не будет положительно влиять на раскрутку и ее можно выкидывать. Или это можно проверить раньше или позже ? Какие для Гугла оптимальные сроки ? Или все-таки будет положительно влиять на раскрутку — даже если (GL) — горит красным ?

В этом плане Гугл от Яндекса не отличается. Если ссылка не в индексе, то ее как будто и не существует. Так что можете определить для себя оптимальный срок (наверное, 30 дней), и после проверки на GL отменять все красные.

Доброго времени суток!

Подскажите пожалуйста — вот уже несколько дней не могу запустить проверку страниц в Гугл-кеше. Выдает — Я робот. Таймаут — 900 секунд. Ранее работало нормально. Можно как-нибудь это подправить ?

Ну как же, это не проблема вовсе, а ваше невнимательность. Я ведь уже говорил, что браузер не всегда видит новую версию, по причине того, что на офф. сайте она еще не прошла модерацию.

На будущее, алгоритм действий такой: Клик правой кнопкой мыши на пустом пространстве -> Вебмастер Sape -> Найти последнюю версию. Там всегда актуальная версия плагина лежит с исправленными багами.

Вопрос снимается — на последней версии плагина 2.7.10 — все работает — можете удалить эти 2 последних поста... Моя невнимательность — вы правы. Спасибо.

Уважаемый автор! Позвольте поинтересоваться, а не будет ли рациональным начинать проверку ссылок с фильтра LF? Ведь это самый быстроработающий и самый НЕ ресурсоемкий фильтр, значит он сэкономит наше время при проверке!

Ага, вы правы только в одном, в том, что "это самый быстроработающий и самый НЕ ресурсоемкий фильтр". Я тонко на протяжении всей статьи намекал на ручную проверку ;) Если собираетесь проверять вручную — фильтр в конце, если автоматически — в начале. Вот и ответ на ваш вопрос.

Cпасибо, отправляюсь перечитывать статью.

Доброго времени суток АлаичЪ !!!

А для биржи linkfeed.ru не подскажете плагина на подобии FF — Вебмастер Sape или или какой-нить програмулины чтоб можно было потоком проверять проиндексированные страницы в Яндексе и Гугле, проиндексированные ссылки и т.п.

Плагина для других бирж я не знаю, так как ими вообще не пользуюсь. Кстати, данный плагин еще для uniplace подходит, но это вы знаете, я думаю.

Но ведь есть универсальный способ — экспорт ссылок в файл и дальнейшая их проверка через какой-нибудь сервис. Например, могу порекомендовать сервис Даниила pult.maulnet.ru для проверки ссылок. Там есть импорт из разных бирж, но если linkfeed там нет, то можно импорт из файла сделать. Сервис немного платный, именно "немного", при небольших объемах не разоритесь ;)

Добрый день. Наконец добрался до "ручной" фильтрации ссылок в Сапе, вот возник вопрос:

Выходит, что фильтр считает количество "ВС" учитывая даже рекламу "Яндекс Директа", но где-то читал, что наличие "Яндекс директа" вполне можно считать плюсом для сайта, так как там идет жесткий отбор сайтов, но по нашему-то фильтру он не проходит, что вы делаете в этом случае? Отменяете размещение?

Надеюсь понятно задал свой вопрос :)

И вам добрый день. По поводу ЯДиректа вы вероятно ошибаетесь, он не может никак считаться. Объявления подгружаются при помощи javascript и, соответственно, будут видны только людям, открывшим страницу в браузере с поддержкой яваскрипта. Иными словами, все, что появляется на странице с использованием скриптов не учитывается.

Но мысль по поводу сайтов участвующих в РСЯ правильная. Такие сайты можно считать качественными (или бывшими качественными), в 98% случаев это точно не сателлиты.

Тоже так думал, но наткнулся на один сайт, где фильтр показывает число внешних ссылок равным семи, однако на самом сайте явно видимых ссылок только 5 :) Вот я и решил, что недостающие две ссылки берутся из "Я.Директ", тем более, что их там ровно две :) Что ж, значит плохо искал. Спасибо за пояснение.

Ссылки могут быть и скрытыми. Если у вас возникают сомнения, то сначала проверяем данную страницу анализатором, а потом смотрим исходный код в поиске этих ссылок. А Яндекс Директ, как какой-то оформленный html фрагмент, в исходном коде вообще отсутствует, кстати.

Это да. Что ж, спасибо за отличную статью и скорый ответ :)

Здравствуйте! Большое спасибо за статью, читаю, пробую, получается... У Вас алгоритм проверки такой: Cn -> ВС -> YP -> LF -> TF, а я проверял: RL-YP-GC-LF. 1. Важна ли проверка на релевантность, кстати после проверки отпадают непроиндексированые страницы в Яндексе? 2. После проверки на индексацию, непроиндексированые ссылки необходимо просто отменять либо кидать в ГБЛ?

Странный алгоритм у вас. Я бы дополнил: Cn -> ВС ->RL -> YP -> GC -> LF

1. Я игнорирую проверку на релевантность. В Сапе трудно тематического донора найти, а уж релевантную страницу еще сложнее.

2. О каком моменте времени идет речь? Ссылки которые не проиндексировались в течении 40 и более дней, то донора можно и в ГБЛ добавить.

Спасибо за ответ.

1. После проверки на релевантность отсеивается от 80% до 100% площадок. Проанализировав "отсев" я пришёл к выводу, что в каждой "отсеяной" абсолютно нет ничего полезного, плюс проверка исключает непроиндексированные Яндексом площадки. После проверки релевантности YP можно не проверять — они будут зелёные. Согласен, тематического донора найти сложно, однако релевантность страницы-акцептора ссылающемуся анкору можно найти и на нетематическом сайте.

2. У меня стоит 40 дней. Такое ожидание я поставил для тематических площадок, очень хочется тематических ссылок :) Тематика у меня-недвижимость, и данных площадок по-моему меньше всего и они самые дорогие. В ГБЛ их жалко отправлять, вдруг на другой странице проиндексируются... Или ГБЛ? А ещё бывает Яндекс сразу индексирует, а Гугл нет и наоборот — ГБЛ?

1. Ну... Тут палка о двух концах, если у вас один сайт, то может и стоит повозиться, а если 50... Что тогда?

2. Поставьте 60 дней. Если уж за 60 не проиндексируется, то уже точно в ГБЛ. Я последнее время делаю именно так.

Индексацию ссылки (да и страницы тоже) я проверяю только по Яндексу, на Гугл не обращаю внимания.

Добрый день, АлаичЪ! Сегодня пришла ссылка Ваша на покупку ко мне... И прочитав перед одобрением сию статью, решил отобрать списки согласно Вашим рекомендациям! И что случилось, Ваш сайт отобразился у меня как не доброжелательный [TF]! Материал действительно познавательный — это факт! Но пишу для того, чтобы вы проверили почему ваш сайт в этом фильтре!

И вам здравствуйте, Алексей. Интересный случай, но и на него у меня есть догадка. TF — это фильтр контента, следовательно где-то на данной странице есть слово или часть слова, которые есть у вас в настройках плагина. Если бы вы предоставили свой список исключений, я бы точно смог сказать почему моя страница отфильтровалась.

PS То, что произошло в очередной раз доказывает то, что полной автоматизации не бывает, обязательно что-то да пострадает — или скорость, или качество.

Мой список довольно примитивный и даже не смотря на популяризацию этого слова (значения) на сегодняшний день, его не оказалось у меня в списке с тем падежом с которым было написано! Естественно речь идет о том о чем вы наверняка уже догадались, с тем, что направлено основную борьбу в Интернет! Но все же, если вам в поможет это могу отправить вам по обратной связи список!?! Желаю вам удачи!

Плагин учитывает даже часть слова, поэтому я в настройках указываю первую часть без окончания, и тогда как бы неделанное слово не было изменено оно все равно "поймается", наверное у вас такой же случай.

Да, список можно отправить через форму слева — "Feedback".

Отправил Вам список...

Зря не описали вкладку плагина для вебмастера — а ведь он позволяет отсеивать повторяющиеся слова в заявках... Честно — читая статью не ожидал увидеть столь детские анкоры на скриншотах.

Ни один вменяемый вебмастер не станет уродовать свою площадку ссылками вроде "ищешь тепловые пушки — дизельная тепловая пушки — дизельные тепловые пушки здесь", подобное сразу идет в ГБЛ.

Вообще странное желание — размещать ссылки на СДЛ но при этом лениться составить АДЛ (анкоры для людей).

ХЗ, конечно, пропустите ли вы критику в комменте...

Да тут надо полностью материал обновить, уже больше года прошло с момента его публикации.

А анкоры не я составлял и тем более не вручную ;) Когда у тебя 50 проектов, в каждом по 20 запросов, да еще и текучка некоторая есть (кто-то уходит, кто-то приходит) не удается везде человеческий подход осуществлять. Не смотря на это, все позиции успешно выведены в топ!

Классный блог, доступное изложение материала. Думаю многие ждут продолжения, например, в виде статей — "Оценка и отбор доноров в GGL" :)

Ну GGL я не люблю, так что про него писать не хочется, а вот про Ротапост, думаю, стоит написать!

Автор, ты же мне сам советовал GGL и Ротапост, а теперь, оказывается "не люблю". Это любовь прошла... или её и не было? :)

Ты сейчас пользуешься GGLом? На твой взгляд, он помогает в продвижении?

Советовал. Но люблю я Ротапост, а ГГЛ не люблю, из-за интерфейса как минимум. Любви у нас и не было, но это не означает, что ГГЛ не работает, все работает.

ГГЛ я пользуюсь когда интересные площадки в Ротапосте кончаются. Как-то так...

Спасибо за разъяснение! Теперь я спокоен.

Чет у меня с этим плагином непонятка одна. Насколько я понял, интерфейс разделен на две части — синяя это для веб-мастера и зеленая для оптимизатора. Самая первая кнопка для веб-мастера это Fn (фильтр пользователя), но она при проверке купленных ссылок у меня не работает. А вот при проверке ссылок как оптимизатор она работает. Странно как-то...

Тут много чего может быть, сказать сходу я не могу. Но я скоро буду обновлять данный материал, потому прошу немного подождать обновления, там много чего нового появилось со времен данного обзора.

Здравствуйте.

Можете подсказать, более подробно объяснить, почему не рекомендуется покупать ссылки в подвале? А то все это не рекомендуют, а почему — не объясняют.

Доброго дня. А я никогда не говорил, что в подвале не стоит покупать ссылки. Что в подвале, что не в подвале сапа-ссылка одинаково плохая, так что вообще не вижу смысла запариться на этом.

Так что просто забудьте об этом ;)

Почему «сапа-ссылка одинаково плохая»...?! Можно плиз, подробнее?!

Потому что это так. Как аксиома!

Поисковики просто вычисляют все продажные ссылки, в частности сапо-ссылки они вычисляют все до одной. Но это не значит, что они не работают. Иными словами, от положения такой ссылки на странице, ее качество не улучшится и не ухудшится, потому что и так понятно что она продажная, а потому не важно, где она расположена.

Если можно, пара вопросов по Сапе.

1) Есть страница (назовём ее id4), которая по мнению Яши релевантна сразу двум продвигаемым запросам. Запросы абсолютно разные, но по смыслу весьма близки (типа "розовые слоны" и "гламурные мамонты"). Эта страница id4 — страница из каталога магазина. На сайте есть несколько специальных статей и про розовых слонов, и про гламурных мамонтов, и про их классификацию... но Яша их далеко отодвигает по релевантности. Есть ли для оптимизатора в этом проблема? Можно ли в Сапе смело закупать ссылки по двум разным ключевым словам (про разбавку не забываем, конечно) на одну страницу?

2) Если проекту в Сапе несколько месяцев и в нем накопилось несколько URLов по одинаковым ключевым словам, то стоит ли (и когда?) удалять старые ссылки? Например, в древности для ключевиков "розовые слоны" закупались ссылки на морду, потом для этих же розовых слонов — на обзорную статью, а сейчас закупаются на специализированную статью. Естественно, сейчас на морду ведут только очень старые высококачественные ссылки, выдержавшие и YL, и проверку временем. Но приносят ли они пользу или только съедают бюджет?

Заранее благодарю за ответы!

1) Не понятно по какому из двух запросов вам нужно продвигать страницу id4. Если страница релевантная двум запросам и они вам удовлетворяют, то и надо оба запроса продвигать на ее. Так же сделать внутренние ссылки со статей на страницу каталога с правильными анкорами. Никакой проблемы не вижу.

2) Спорный вопрос, но можно для старых ссылок, прошедших проверку временем, заменить анкор на нужную страницу, которая продвигается сейчас. Хуже не станет.

1) Если Вы не видите проблемы — так и поступаю, буду закупать ссылки, указывающие на эту страницу. Мне так только легче.

2) Оригинальный выход из положения! Спасибо!

Пару дней назад плагин Винка перестал работать. Просто отмечает галочками все ссылки по проверкам YP, BC и YC. В чем может быть дело? Настройки были как в этой статье и все работало, может быть из-за обновления мозилки?

У меня было то же самое. Решилось закачиванием обновления (вышло только что).

Обновлением чего?

Обновлением плагина, по всей видимости ;)

Не помогло.

Ну, видимо, придется немного подождать обновлений плагина. Выходные впереди — отдохните, а там глядишь и все заработает ;)

Чувствую придется винду сносить.

Уважаемые коллеги! Безусловно надо всегда обновляться до новой (самой последней) версии плагина Wink'a. Но обращаю внимание на то, что новые версии плагина требуют свежую версию обозревателя. Поэтому, возможно, придется обновить FireFox. Сносить ОС — это слишком :)

Все обновил — и плагин, и мозилку — не работает.

Нашел в чем проблема. Оказывается мозилка почему-то обновляет плагин только до версии 2.13, а нужно обновиться до версии 2.16. Теперь проблема с сообщением "Капча 90 секунд". Можете что-нибудь посоветовать?

Если я правильно понимаю, то у вас проблема с капчей Яндекса? В этом случае надо регистрироваться на антикапче. Я про это пост писал — https://alaev.info/blog/post/1486

Не могу не спросить :), по всем фильтрам у меня остается 1-2% ссылок, из 1000 вчера купила 6!!!, при этом заметила что большинство отсеялось после применения "Т" (трафик сайта, Alexa Rank выставлено у меня 3000). Насколько важен этот фильтр? Получается что поисковики плохо относятся к ссылкам с сайтов с низким уровнем посещаемости (для меня важен Гугл)? Боюсь просто, что покупая по 5-10 ссылок в сутки буду двигаться долго и нудно)))

Да, фильтр "T" много может отсекать. Но тут надо смотреть все фильтры в совокупности, и лучше тогда трафик проверять не по Alexa Rank, а по LI с тем же порогом в 3000.

Спасибо, попробую — отпишусь. Кстати, вот мне на веблансере предлагает человек открыть "секрет" работы сапы за 100 у.е., и говорит что затраты мои составят 20 у.е. за 2 ключа (натяжные потолки, натжные потолки киев). Реально ли это? Я понимаю, что попахивает разводом чистой воды, но так хочется верить)))). Хотелось бы услышать ваше мнение по этому поводу!

Хрень полная. Не ведитесь на это!

Спасибо! Извините, что так много вопросов с моей стороны)

Отличная статья! Теперь по данному алгоритму покупаю ссылки! И, честно сказать, теперь понимаю, сколько мусора у меня было... Больше половины снял!

АлаичЪ, перечитываю ваши статьи постоянно, но не нашла нигде ответ на свой вопрос. Изначально в полуавтоматическом режиме было выставлена покупка 500 ссылок в день, но после этого поняла что отбираю из них 3-4 шт. в день максимум, выставила 1000 ссылок в день — количество их крайне упало. За день на просмотр приходит около 300-400 штук, выбрать нечего:( Это не может быть связано с таким количеством отмененных ссылок? Возможно Сапа реагирует на многочисленные отказы? Какое количество ссылок и сумму прописываете в режиме Вы?

Можно я отвечу? Спасибо. Я сталкивался с таким. По-моему, Сапе странно себя ведёт, если изменять значения в фильтрах и размер автозакупок. Поэтому, если нас что-то не устраивает, поможет гомеопатия (то есть подобное лечим подобным): меняем чуть-чуть значения в фильтрах (цену на копейку), или размер автозакупок.

Сработало! Спасибо!!!

Судя по всему, я опоздал с ответом ;) Но тем приятнее, что другие читатели отвечают на вопросы.

Евгенич, спасибо. А вам, Alisha, удачи!

Здравствуйте, купила ссылки на сайт пользуясь вашими подсказками и настройками фильтров... после апа сайт потерял 3 позиции... Все сайты просматривала в принципе, и ссылко куплено всего 30 штук... Может все уже так сильно изменилось, что теперь ссылки с сапы все во вред? Ведь яша их на раз вычисляет... Может стоит переориентироваться на контекстные ссылки? Как вычислить те ссылки что повлияли в минус?!

Добрый день. -3 позиции еще ни о чем не говорит, это стандартный шторм. Ссылки могли еще даже не проиндексироваться, вы это можете проверить фильтром YAL.

Поисковики без проблем вычисляют любые ссылки, так что тут нет разницы контекстная ссылки или нет, так же для ПС нет разницы как на странице выглядит ссылка, он этого не видит.

А у меня опять проблема с маленьким количеством закупаемых ссылок. Сапа покупает совсем мало, не думаю, что это из-за площадок. Думаю, все-таки из-за настроек...Значения меняла, сперва помогло, уже не помогает. АлаичЪ, поделитесь что у вас в режиме стоит? Например, мне надо закупить 50 ссылок в день. Значит, в значении дневная квота ставим — 50? Огрраничение бюджета не ставила (99.999), ссылок в месяц выставлено 15000. Не могу догнать, что ж не так:)

Вы писали: "Принцип прост: сапа купила утром 1000 ссылок, из них выкинули 930, оставили и купили только 70. Значит второй раз в день сапа купит 930 ссылок, из них выкинули 880, а 50 купили… Принцип, думаю, понятен."

Вот мне не понятно:) Поясните плиз, какими значениями добиться такого принципа.

Если надо купить 100 ссылок в день, с учетом того, что после проверки фильтрами отсеивается 95% ссылок, то надо ставить дневную квоту в 2000 ссылок (2000*5%=100, понятно, да?). Вот как-то так.

Так то оно так, только вот больше 255 в днвной квоте не выставляется:) Пыталась оставлять это поле пустым — тот же результат. Более того, ночью провела эксперимент — на 2 урл поставила одинаковые фильтры и одинаковые настройки режима. На один урл было закуплено сапой 2300 ссылок, на второй 37...

Ах, я и забыл про лимит в 255. Мне-то всегда этого хватало, так как у меня обычно проект состоит из десятков и сотен url'ов, и если на каждый поставить по 255, то выходит очень много ;)

А фильтры можно протестировать на ручном поиске, выбираешь составленный фильтр и делаешь по нему поиск, если площадок много, значит есть чем закупаться.

Что-то сапа халтурит в последнее время :(

Я опять к вам с вопросом. Покупая ссылки по запросу "РОЗОВЫЕ СЛОНЫ" запрос "РОЗОВЫЙ СЛОН" сам по себе "раскручивается". Просто интересно на что делать больший акцент? на раскручиваемое слово в единственном числе или множественном?

Я бы в качестве анкора использовал все словоформы, это и для разбавки хорошо и вообще.

Уникально интересная и безумно полезная статья! Вообще люблю читать Ваш блог. Получаю массу ценной инфы! Спасибо!

Имею вопрос: установил плагин для SAPE, фильтрую предложения; начинаю с релевантности (по этому фильтру идет существенный отсев), через некоторое время работы фильтра он останавливает работу и вылазит сообщение "капча". Поясните, плиз, что это и как возобновить фильтрацию?

С огромной уважухой и спасибо заранее!

А что за фильтр релевантности? о_О Я чего-то не знаю?

А про капчу я еще в 2010 писал пост о том, как пользоваться Антигейтом — Антикапча – sape-оптимизаторам на заметку

Спасибо за быстрый комментарий!

Фильтр RL — он проверяет релевантеность страницы-акцептора ссылающемуся анкору.

Может я зря им пользуюсь? Просто я считал, что если ссылка нерелевантна, то и проку от нее немного. Посему и фильтрую...

Пойду читать про антикапчу...

С уважением...

Понятно, слона то я и не заметил =) Просто в настройках плагина этот фильтр не упоминается, вот я его и не видел никогда.

А вообще фильтр этот какой-то сомнительный, я не понимаю его смысла. Он наверное для вебмастеров, а не для оптимизаторов.

Какой смысл для оптимизатора в том, чтобы проверять релевантен ли анкор (который он сам составлял) странице (которую он сам создал) я не понимаю — это абсурд.

Да, вы правы! Нелогично как-то... Хотя может быть фишка в том, что когда сильно разбавляешь ключ ( я использовал seo pult? чтобы получить массу ключевых запросов), он становится нерелевантным странице на которую он ведет (то есть на страницу раскручиваемого сайта). Это говорит только о том, что такие ссылки надо не использовать. Что думаете по этому поводу?

p.s. Кстати, об анти-капче: загрузил плагин 2.19.3, там пишут, что проблема определения капчи Яндексом доработана.

Попробовал на 1500мс — вроде ЯК не ругается... Думаю, эту инфу можно внести в Ваш пост об анти-капче...

Я до сих пор думаю, что для оптимизатора RL-фильтр — это маразм ;) Сами же себя проверяете каким-то фильтром. Сперва генерируете анкоры сеопультом, потом проверяете их фильтром, а что дальше? Осталось только чтобы текст на странице был сгенерирован роботом.

Так что вы поняли, что я думаю об этом.

По поводу антикапчи не понял, имелось ввиду, что если ставить задержку в 1500мс, то Яндекс не блокирует запросы и не выкидывает капчу? Подразумевается при этом, что антигейт не используется. Так получается?

C RL фильтром мой косяк! Я попутал! Думал, что фильтр проверяет релевантна ли эта ссылка сайту донору, а выходит, акцептору. С другой стороны не совсем понимаю, как ссылка сгенерированная Seo pultom, в которой разбавляется мой ключ, может быть нерелевантна моему же сайту?! Фильтр RL считает, что может...

Любопытно...

А вот вопрос, если мой сайт занимается продажей часов, имеет ли мне смысл закупаться ссылками с сайта, занимающегося скажем, не торговлей, а образованием или здоровьем? или они все равно не проиндексируются?

Касательно антикапчи: Я загрузил версию плагина 2.19.3. В комментариях к плагину было сказано, что решена проблема с Яндексом (как я понял именно с капчами). Ну, вот, загрузил я эту версию и преступил к полевым испытаниям. Вчера ночью все было гладко — ЯК как-будто успокоился. А вот сегодня утром все по новой... Короче, antigate рулит. Купил за бакс 1000 антикапчей и все забыл. Сегодня потратил 0,003 доллара — дешево......

Не важно, какой сайт ты продвигаешь, не важно ссылки с каких сайтов (имеется в виду тематика) ты покупаешь, эффект будет одинаковый. Все одинаково проиндексируется и одинаково будет работать.

Здравствуйте, АлаичЪ. Хорошие у Вас статьи. У меня такой вопрос возник, посоветуйте — нужно ли отправлять в BL страницы, непроиндексированные в Яше, чтобы не мешались больше, или не надо?

Нет, не надо. В BL отправляется ведь не страница, а сам сайт.

Спасибо. Но тогда такой вопрос возникает: есть ли какой-нибудь способ при поиске площадок, чтобы ссылки, которые я до этого отклонил, больше мне не попадались?

Нет, я такого способа не знаю. Или сайт или ничего — только так.

Уважаемый АлаичЪ, как Вы считаете: стоит ли покупать ссылки в старых статьях, например 2008 года?

Это не важно, работая в сапе, вы в любом случае покупаете ссылки не в новых статьях. Так что никакой разницы нет.

Скажите пожалуйста, если при проверке уже купленных ссылок показывается что ссылка установлена в подвале. что делать? снимать ее?

Нет.

Да большинство ссылок, купленных через Сапу, установлены в подвале, так что тут нечего пугаться. От того что они будут не в подвале, лучше они не станут :)

Спасибо, описано хорошо!

Но вот плагин уже сильно изменился, вот если бы ты поделился настройкой все что там сейчас есть, то это было бы конечно супер. Но всеравно спасибо огромное за такие посты, очень много черпаю для себя интересного!

Я давно не работаю с Сапой и плагином, соответственно, так что актуальной информации у меня нет :(

Вы написали что отказались от Сапы. Скажите пожалуйста, где вы теперь закупаетесь ссылками?

Закупаюсь здесь: GoGetLinks и RotaPost

Сколько по времени закупаетесь? Делали анализ сколько ссылок отвалилось через год?

Давно закупаюсь, около 2х лет. Ссылок отваливается не много. Хотя в Ротапосте отваливается приличное количество, а в GGL почти не отваливается ничего.

Вот рекомендую прочитать мои публиакции по теме:

Грамотная работа с биржей RotaPost

Эффективность продвижения постовыми в RotaPost

Здравствуйте. Скажите пожалуйста, через какое время нужно снимать проиндексированные ссылки в сапе?

А зачем снимать проиндексированные ссылки? :)

Здравствуйте! Прочитала, озадачилась. Это честно. Мне мои учителя сказали, чтобы к Sape даже не приближались. Там только деньги тратить и портить свой сайт. У вас читаю протовоположное, да еще с серьезными объяснениями.

Подписалась на комментарии, жду вашего ответа.

Что я могу сказать...Могу посоветовать обратить внимание на дату публикации данного поста. Много воды утекло с тех пор.

Я что бы вы порекомендовали начинающим? Где лучше покупать ссылки? Или Вашу полезную по этому поводу можно почитать статью (если есть, ссылку можно?)

На GoGetLinks рекомендовал бы покупать, я сам там покупаю последние несколько лет.

Пробовал, реально работает, спасибо!

Здравствуйте Алаич, скажите пожалуйста по какой причине поменялись приоритеты не в сторону сапы?? Ведь вечные ссылки полезно разбавлять арендными, так сказать для более динамичного продвижения??

Есть ли на Ваш взгляд принципиальная разница для таких целей закупки дешевых ссылок между сапой и скажем Пультом??

Все это по субъективной причине, мне кажется, что вечные ссылки лучше, чем арендные, они мне больше нравятся, больше по душе.

Разница между сапой и пультом в том, что это две разные системы, ну, если не пользоваться полным автоматом. В сапе можно выбирать и отбирать ссылки тщательно, в пульте, насколько я знаю, все несколько сложнее (или легче, это кому как). С сапой не работаю уже несколько лет, а с пультом вообще не работал, так что не знаю.

А имеет ли смысл арендные ссылки еще отбирать? Ведь если она битая или не индексируется она снимется, а в остальных случаях ей дорога прямиком в футер или еще в какое более злачное место, — ну явно не для людского глаза...( а если нет гонки за пузомерками то и вообще не важно принципиальное качество сайта главное чтобы не совсем унылое ГС).

Просто если брать интернет-магазин а не блог скажем, то роли впринципе в качестве арендных ссылок особой нет, если сайт старше 2-3 лет, как на Ваш взгляд? По сути от ссылки на которую в мес. тратишь меньше 5 рублей никаких особо положительных ПФ особо недождешься (то явно понятно что ссылка ставится для количества уже, а не качества), а если продвигаемый сайт СДЛ (в данном случае интернет-магазин) то всяко лучше приоритет жесткого отбора оставлять за вечными на что заморочки с арендными и их особым качеством уже отпадают, как Вы считаете?? То есть за сим и какие-либо приоритеты между биржами арендных ссылок тоже не играют роли, в плане это хуже, это лучше, я прав?

Вообще ничего не понял. Отбирать ссылки надо всегда, будь они временные или вечные — критерий качества еще никто не отменял! Для своего сайта лучше вечные брать, в длительной перспективе выгодно. Ну и никто не ставит никаких целей относительно купленной ссылки, чтобы она кроме веса что-то передавала, какие-то переходы или, как вы выразились, положительные ПФ. Отбирать же качественные можно по разному, в частности моим новым софтом FastTrust, ссылка на него в шапке блога.