Привет, друзья. Ну вот и пришло время для написания завершающей статьи про покупку и проверку ссылок в бирже Sape. Это третья по счету статья – первая была про правильную настройку автофильтров, вторая про отбор площадок (какие покупать, какие не покупать). Здесь пойдет речь про то, что же делать с ссылками после того как они куплены и размещены на доноре; как узнать «работает ли донор»; как узнать в индексе ли ссылка и сам донор. Обо всем этом я расскажу в этой публикации.

Привет, друзья. Ну вот и пришло время для написания завершающей статьи про покупку и проверку ссылок в бирже Sape. Это третья по счету статья – первая была про правильную настройку автофильтров, вторая про отбор площадок (какие покупать, какие не покупать). Здесь пойдет речь про то, что же делать с ссылками после того как они куплены и размещены на доноре; как узнать «работает ли донор»; как узнать в индексе ли ссылка и сам донор. Обо всем этом я расскажу в этой публикации.

Для всего того, о чем я написал пару строками выше, нам потребуется все тот же плагин, настройки его я тоже уже описывал, они подойдут для этого дела. Вы, наверное, уже обратили внимание, что плагин, действительно, вещь незаменимая в работе с Сапой.

Итак, по пунктам, что нам необходимо будет предпринимать, чтобы убирать неработающие доноры, доноры под фильтрами и доноры, выпавшие из индекса:

- Убираем доноры под фильтром АГС,

- Убираем ссылки со страниц доноров выпавших из индекса,

- Убираем ссылки с доноров, ссылка на которых не индексируется,

- Изменились цены на ссылки. Что делать?

Убираем доноры под фильтром АГС

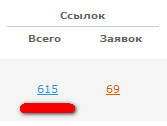

Здесь довольно все просто, алгоритм выявления таких доноров был придуман быстро и проверен на практике. К тому же критерии выборки подтверждены официально Яндексом. С этим нам поможет волшебная кнопка G10. Ее мы настраивали так:

Ярким признаком фильтра АГС на сайте является наличие в индексе десяти и менее страниц. То есть мы будем отмечать сайты с индексом менее 11 страниц. Ну и если сайт выпал из Гугла и не имеет страниц в индексе, тоже выбрасываем.

Идем в просмотр полного списка купленных ссылок в проекте и, когда страница полностью загрузится, жмем G10. Немного ждем и видим всплывающую подсказку внизу экрана о том, что было отмечено n ссылок, ну или ничего не отмечено (если площадок под АГС нет). Потом, само собой, выбираем «Отменить размещение и отправить в ГБЛ», то есть отправляем эти сайты ГБЛ, чтобы они нам больше не мешали, никогда.

Убираем ссылки со страниц доноров выпавших из индекса

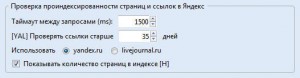

Можно не перезагружать страницу списка купленных ссылок. Просто нажимаем на YP и следим за ходом проверки, занимаясь своими делами. Когда проверка закончится, отменяем эти ссылки (заносить в ГБЛ и БЛ такие сайты не следует, страницы выпадают у любого сайта). Эту проверку стоит проводить после каждого апдейта. Существует мнение, что не стоит проводить эту проверку в день апа, потому что, якобы, еще не все устаканилось. Но апдейты в Яндексе случаются всегда ночью, и потому к обеду уже все спокойно, так что проверку можно смело запускать. Так что тут как вам больше нравится, можете проверять в день апа, а можете на следующий день, ничего криминального не случится.

Убираем ссылки с доноров, ссылка на которых не индексируется

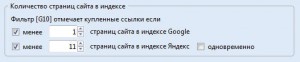

Вот это наиболее интересный пункт. Многие оптимизаторы о нем забывают (или забивают), но если вы хотите чтобы все ваши купленные ссылки работали, и деньги, пусть и не большие, не улетали в трубу, проверять категорически рекомендую. Настройки для этой проверки мы так же выбрали в прошлой статье цикла, но продублирую, чтобы вам не искать:

Мы выбрали проверку ссылок, которые куплены и стоят уже больше 35 дней. Почему именно 35 я рассказывал уже. Так же открываем полный список ссылок в проекте, но жмем на кнопочку YL, начнется проверка. После того как она завершится, тоже покажется извещение внизу экрана, о том, что отмечено n ссылок. Теперь спешить не стоит, эта проверка требует больше чем нажатие на отмену размещения или отправки сайта в ГБЛ. Я предпочитаю просмотреть все отмеченные ссылки сам. Иногда бывает, что на хорошем сайте ссылка почему-то не индексируется, притом, что на этом же сайте в другом проекте она давно в индеске. Такие ссылки стоит просто отменить, глядишь, в следующий раз ссылка купится на более «удачливой» странице сайта. После просмотра и отмены ссылок не в индексе на хороших сайтах, мы можем смело отправлять в ГБЛ сайты, которые не представляют особой ценности и есть шанс, что там или вебмастер что-то «замутил» для неиндекса, или просто площадка плоха настолько, что ее робот посещает очень редко.

Вот мы и избавились от неработающих доноров. В наших проектах теперь все будет чисто и зелено ;)

Изменились цены на ссылки. Что делать?

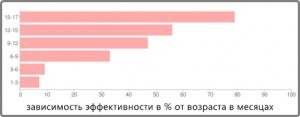

Остался последний вопрос, который необходимо разобрать. А именно — Изменились цены на ссылки. Что делать? Давайте в первую очередь посмотрим на картинку:

Интересная картина, не правда ли?! Чем старее ссылка, тем лучше она работает, тем естественнее она выглядит в глазах ПС, тем больше веса она передает. Поэтому я рекомендую утверждать большинство изменившихся цен. Ну конечно это не значит, что если вебмастер поставил новую цену 100р на ссылку, которая в среднем стоит 10р, ее стоит утверждать. Таких «умельцев» я отправляю прямиком в… ГБЛ, ну и туда, куда вы подумали тоже ;) Цены, которые отличаются от средних в 2 раза вполне приемлемы, потому, что большинство более или менее нормальных площадок, не сателлитов, ставят цены выше средних в 1.5-2 раза. Ну и, конечно, следует проверить все площадки изменившие цены вручную. А вообще я вам скажу – вебмастера меняющие цены – нехорошие люди, они потеряют больше, чем получат от новых цен. Лично знаю много людей, которые даже не смотрят на пункт «Изменились цены», в итоге ссылка отпадает.

На этом, пожалуй, я завершу рассказ, так же на этом завершается и цикл статей о покупке ссылок в Sape. В будущем я напишу статьи про альтернативные, более качественные (и как следствие платные) способы работы со ссылками в биржах.

А пока я жду ваших комментариев, поверьте, они для меня очень важны. На все я отвечу, если будут вопросы — я помогу. Поддержите меня.

Крайне полезные публикации о Sape:

14 января 2010. Покупка ссылок в Sape. Или как это делаю я

25 января 2010. Как отбирать только качественные площадки в Sape

30 января 2010. Что делать с уже купленными ссылками в Sape. Окончательная проверка на прочность

10 февраля 2010. Sape – акцент на новые возможности автофильтров

5 марта 2010. Sape – о регионах в цифрах

13 мая 2010. Палю свой black list для Sape

19 мая 2010. Как надо продавать ссылки в Sape. Взгляд оптимизатора

22 сентября 2010. Антикапча – sape-оптимизаторам на заметку

10 ноября 2010. Продвинутый отбор доноров в Sape. Плагин Вебмастер Sape и LF фильтр

На этот раз ничего полезного не узнал для себя, поскольку кнопки YP и YL жму яростно с момента появления плагина :)

Но за первые две части — большой респект! Особенно полезной оказалась вторая — благодаря ей, надеюсь, сэкономлю немалую часть бюджета.

Спасибо большое за отзыв, вы мой постоянный комментатор. Есть повод порадоваться, что вы знаете эти моменты, которые я описал в этот раз. Я стараюсь максимально полно и доступно описывать даже самые простые и очевидные вещи, всегда найдется человек, которой этого не знал и ему это будет полезно.

Еще одно спасибо за отзыв о первых частях, рад что пригодилось.

Ну и раз вы отписались тут, скажите о чем бы хотели увидеть следующие публикации? Не обязательно связанные с Сапой, можно задавать любые темы. Буду рад написать о своем опыте.

Привет, Алаичъ :)

Еще раз спасибо за этот блог и статьи, в нем размещенные, и раз уж пошло такое общение :), хотелось бы задать вопрос по поводу этого самого плагина под FF, которым ссылки в сапе проверяются.

Я тут скриншот маленький сделал.

В общем захожу по кейворду в сапе и нажимаю «ВС», чтобы перепроверить ссылки и, вот немного не понятно, что значит картина подобная той, что на данном скриншоте?

Почему плагин отметил 1-ую и 2-ую ссылки, ведь на первой ссылок ввобще 0, а на второй всего лишь 3, в данном примере с третьей-то только и понятно, бо только она под фильтр подходит по количеству ВС.

И еще один вопрос в догонку, уже по поводу тех ссылок, которые были добавлены и висят несколько дней, заходим жмем «ВС», ну те где стало «no», т.е. ссылка удалена сразу в blacklist идут, а вот что делать с теми сайтами где ВС стало 6-7? Вроде как фильтр превышен, но не сильно и вроде как висят уже несколько дней и жалко? Что обычно делаете вы с такими ссылками? Килять их или уже пусть живут и ждут индексации, и есть ли смысл или это просто выброс бюджета?

Ничего необычного, стандартная практика, вы просто не учли одну вещь — фильтр площадок по количеству контента, взгляните левее, увидите что-то в духе «618 / 47656 (1%)» под ссылкой на донора. Если фильтр настраивали как я описывал, то 618 < 1800 (объем текста в настройках плагина "Параметры страниц"), вот и все.

По поводу уже купленных ссылок. Я их не проверяю больше фильтром ВС. Только YP, т.е. проверка на индексацию. Практика показала, что этого достаточно.

Большое спасибо за ответ! :) Теперь все понятно! :)

Хотел еще уточнить для себя из вопроса и ответа JaTony 02.02.2010 в 12:17.

Только у меня свой скриншот :)

Не пойму почему в этом случае плагин поставил отметки. У меня в настройках мин количество текста 2000 символов указано.

Но на скрине в 4 из 5 — больше текста. Параметры ВС — 4 ссылки. Везде пусто на скрине — ни одной. Почему же отметил плагин?

И еще как можно использовать показатели 151/109, 149/108... Зачем они? Заранее благодарен.

А как на счет ограничения внутренних ссылок в 150? Вот как раз 151/109, 149/108 и т.д. это и есть внутренние ссылки, где первое число показывает их общее количество, а второе количество этих ссылок без noindex и nofollow.

Я думаю, сейчас все сразу должно проясниться. Да ведь?

Да. Спасибо. Теперь понял. Только у меня 100 ссылок стоит. Или этого маловато? :)

И еще такой вопрос, не по теме немного, но все же спрошу... Когда снимаются средства в САПЕ при покупки ссылок. Когда я нажимаю подтвердить размещение? И если я например через 2 дня отменю ссылку, то средства мне уже не вернуться на счет? Или какая система?

100 не маловато, но я для себя оптимально нашел 150. При таком раскладе получится купить чуть больше ссылок, так как в основном крупные сайты имеют большие сайдбары и навигацию.

Деньги с баланса списываются ежедневно в определенное время, деньги не возвращаются, так что сколько дней ссылки простояли (цена/30*количество дней) столько и спишется в итоге.

А почему не стоит использовать отсеивание ВС? Ведь если их много, например больше 4, то ссылочный вес такие доноры не передают или передают, но маленький. Зачем их оставлять? Это же пустая трата денег.

Ведь то, что страница в индексе, ещё не гарантирует эффективности размещения на доноре, где ВС больше указанного. А если их 15, то тоже не трогать?

Отсеивание ВС я делаю на стадии покупки, как и описано в предыдущих постах на эту тему. А потом не вижу смысла удалять такие ссылки, потому что даже если ее удалить, а купить другую с прочими равными, но меньшим количеством исходящих, то работать она будет хуже из-за того что еще "молодая". А первая ссылка успеет "постареть" к тому времени когда, возможно, на ней количество ссылок превысит лимит, ведь ссылки растут не мгновенно, а индексируются и того медленнее.

Если уж совсем вебмастер обнаглеет, размещая кучу внешних ссылок, то или страница вылетит из индекса как спамная или, что очень хорошо, сайт попадет в бан ;)

Доброго дня, АлаичЪ. Совсем недавно открыл для себя Ваш блог, очень был приятно удивлен. Много информации, которую раньше найти не мог, даже на платной основе. Я начинающий СЕОшник-самоучка, есть небольшие но приятные результаты. С САПой работал очень неуверенно, теперь попробую (благодаря Вам) более посмелее и с большим бюджетом. Хотелось бы побольше материалов с настройкой и работой в САПе. Ну и вопрос — покупаете ссылки только через САПу или и через Сеопульт и другие. С радостью буду посетителем Вашего блога и в дальнейшем

А как часто надо делать эту проверку?

Идеальный вариант — на следующий день после апдейта. Но это слишком, по крайней мере, с моими объемами.

Так что можете делать каждый месяц. Я каждый месяц делаю.

Возникла такая мысль, можно ли проверять доноров в сапе на посещаемость через li.ru

Счетчик стоит на львиной доле сайтов в рунете, а это в основном сдл (гс не беру во внимание). Если у донора есть посещаемость, значит и ссылка с него должна работать.

Есть возможность проверять трафик Google за месяц. Но что-то я этой проверке все равно не доверяю и потому ей не пользуюсь.

Но даже не смотря на это, внедрение проверки по LI не кажется мне хорошей идеей.

Блог просто отличный в плане SEO!

Я вот насчет 35 дней... Я откидывал ссылки, которые не индексировались за 20 дней.

А у вас 35 дней. То есть это 9 (!) апдейтов? Если смотреть на октябрь месяц.

И ссылки с сайтов 200, 1200 за 20 дней не проиндексировались. В какой раз убеждаюсь, что с большим тиц и с маленькой ценой брать не стоит...

Я сперва проверяю сайты, ссылки на которых не проиндексировались за 60 дней. Заношу в ГБЛ.

Просто на больших сайтах с огромным количеством страниц в индексе проблема с переиндексацией, это и понятно. Я думаю и вы это понимаете. Так что тут дело не в тИЦ и не в цене.

"Просто на больших сайтах с огромным количеством страниц в индексе проблема с переиндексацией"

Да, спасибо, особенно на новостных. Если, к примеру, нужно быстро вывести запрос, то я покупаю с сайтов у которых в индексе до 500 страниц, не ГС, с хорошим дизайном, ссылки быстро индексируются...

Покупаю по 5 ссылок на запрос НЧ, после проиндексирования всех ссылок смотрю позиции, если что-то поменялось еще покупаю.

Site-Auditor показывает видимость страницы, ориентируюсь по цифрам, если к примеру сайт с видимостью стр. с 500, а у меня 250, то нужно покупать траст. ссылки, а НЧ там обычно видимость 29 — 15. Конечно, нужно смотреть сами сайты)

Говорят, еще нужно поднимать траст сайта, покупая ссылки с анкором сайта, то есть не для продвижения. Как вы считаете?

Ссылки с анкорами сайта нужны для того, чтобы создать видимость "естественности" ссылочной массы, ведь когда кто-нибудь ссылается на ваш сайт независимо, то ссылка бывает вида или анкор, или "тут", "здесь" и т.д. Поисковик так же думает. Так что такие ссылки полезны, так же, размещая такие ссылки, стоит поработать с окружающим текстом.

Спасибо! Значит правильно говорят)

Спасибо за статью, как всегда понятно, доступно и полезно. Вот такой вопросик, перед проверкой на фильтр АГС пользуетесь ли Вы кнопкой "H" (Host)? Дело в том, что количество проиндексированных страниц в Гугле и Яндексе по данным Сапы и данным плагина Sape различается кардинально.

Где-то на такой вопрос я уже отвечал, но даже я не найду где именно. Так что отвечу еще раз.

Проверяю но не всегда. Ошибиться без проверки можно только в меньшую сторону, то есть сайты, которые имеют по данным Сапы мало страниц в индексе мы баним, они уже точно из под АГС не вылезут. Ошибка может быть в том, что сайт зарулил по АГС, но в Сапе этих данных нет, но со временем все равно появятся. В такой ситуации мы просто потеряем деньги за ссылки которые вовремя не удалили. Ну это и так понятно, я думаю.

Логично) Спасибо за ответ)

Все таки сапа очень сильно врет особенно по количеству проиндексированных страниц в Гугле, при проверке было отмечено очень много ссылок с количеством проиндексированных страниц в Гугле = 0. Мне показалось странным, что многие из этих сайтов были с очень хорошими показателями (ТИЦ-1000, в Яше проиндексировано 100000 страниц) и при ручной проверке оказалось, что страницы с моими ссылками проиндексированы, количество проиндексированных страниц очень большое, высокий PR.

Ага, с Гуглом бывают неразберихи. Потому я не ориентируюсь на показатели с него. Смотрю на Яндекс, и вам советую.

Кстати, а какой смысл проверять проиндексирована ли страница (YP), если все равно при проверке проиндексированности ссылки (YL) все непроиндексированные странницы так же будут отмечены? Ведь, если страница не проиндексирована, то и ссылка не может быть проиндексирована. Или смысл в том, чтобы не тратить деньги на ссылки на непроиндексированных страницах, которым меньше 35 дней?

Так YP и YL отвечают за разные вещи. Я сайты, на которых ссылка долго не индексируется в ГБЛ заношу. Перед занесением в ГБЛ надо сперва откинуть сайты ссылка на которых не проиндексирована из-за выпадения страницы, потому что страницы выпадать могут, но сайт при этом не стоит заносить в ГБЛ, а вот если и страница в индексе, но ссылка нет, то тут уже что-то неладно.

Схематично: YAP -> отменяем -> YAL (60 дней) -> отправляем в ГБЛ.

И еще один вопросик, при проверке размещенных ссылок нашел много проиндексированных ссылок на главных страницах сайтов находящихся под АГС, стоит ли удалять такие ссылки?

Конечно стоит. Если сайт под фильтром, то он труп. Полный вылет из индекса лишь вопрос времени. Да и ссылочное с этого сайта сомнительное, в самом лучшем случае ссылка никак не повлияет, а ведь может и навредить!

Огромное спасибо за ответы! Как всегда всё доступно, ясно и понятно.

В новых версиях программы в настройках есть фунция "отмечать ссылку, если она расположена в подвале", пользуетесь ли Вы этой функцией? И как вообще Вы относитесь к ссылкам находящихся в подвале?

Уже не раз отвечал на вопрос про ссылки в подвале. Функция поиска "подвальных" ссылок появилась давно, а может быть вообще всегда существовала, просто вы не обращали внимания на нее.

Ссылки в подвале целенаправленно я не убираю. Они убираются только если надо серьезно сократить бюджет кампании, и сокращается он действительно серьезно если брать данный критерий в рассмотрение. Так же учитывайте, что проверить месторасположение ссылки можно только после ее покупки.

Здравствуйте!

Я руководитель фирмы и меня очень порадовало, когда я прочитал Ваше детальное руководство. Решив действовать, следовал всем Вашим советам "закрытыми глазами" ибо я ученик в этой сфере, а на оптимизаторов уже не хватает — нервов :) Прошел уже как месяц, но что то страницы мои не двигаются с места (за редким исключением). Перечитав несколько раз Ваш блог нашел и ошибки у себя. Но думаю, что-то главное я упускаю, но не могу понять что. Могу я попросить Вас, по разумной ставке, сделать аудит моим знаниям и моему проекту? При необходимости первоначальные данные могу выслать.

PS В любом случае — спасибо за поучительный блог!

Конечно, я отвечу на ваше письмо.

Добрый день! Давно читаю Ваш блог, большое за него спасибо. Много почерпнул полезного, и все проверил на практике методом проб и ошибок. У меня осталось не решенным два вопроса:

1) Как Вы относитесь к покупке ссылок на страницах с датой создания 2009, 2008 и т.д. года.

2) Учитываете ли Вы при отборе донора количество текста на его странице?

Заранее спасибо за ответ!

Приятно слышать, Сергей. На ваши вопросы, по крайней мере, на второй, вы точно найдете ответ здесь — https://alaev.info/blog/post/191

На счет первого вопроса, я так понял, вопрос стоит в том, покупать ли ссылки на страницах с большим возрастом или нет. Я считаю, что да, очень даже да. Это некоторая гарантия того, что страница не вылетит из индекса, если она там просидела 2-3 года.

Спасибо за ответ. Просто я много слышал о том, что как бы для Яндекса будет выглядеть нелогично (не естестыенно) появление ссылки "сегодня" на странице, которая в яндексе давным давно.

Ну да, верно. Но в таком случае выход только один — покупать вечные ссылки в свежих публикациях в GGL и Rotapost или осваивать PR.SAPE.RU :) Но там речь идет совершенно о других деньгах...

Ну вот, как-то так.

Здравствуйте, Александр. На днях проверяла ссылки с помощью плагина Винка, купленные в Сапе, на проиндексированность в ПС, а также страницы на наличие их в индексе, на которых ссылки размещены менее 35 дней. Решила заморочиться. У меня есть еще один плагин RDS бар, его я использую для проверки площадок в Ротапост. Там тоже есть примочка, которая определяет надичие страницы в индексе ПС. Так вот четыре страницы по Винку выпали, а по РДС выпали только две. Я продолжу наблюдения. Хотелось бы узнать Ваше мнение. Спасибо.

Привет, Инна. Да, есть такие наблюдения и у меня. Так же пользуюсь плагином RDS и точно в такую же ситуацию попал, плагин Винка показывает одно, RDS другое, приходится проверять потом и ручками через Яндекс. Если же страница действительно присутствует в Яндексе, то я не убираю ссылку с нее.

Но вот только это отнимает очень много времени, и я еще не придумал как с этим бороться. Если у вас какие-нибудь мысли по этому поводу появятся, вы отпишитесь обязательно, ну и я буду начеку.

Добрый день. Не буду оригинален — спасибо вам за ваш блог. Вот только у меня такой вопрос: на некоторых сайтах индексация в гугле и яндексе имет разницу в 7 раз, а то и больше, причем, иногда Яндекс сканирует больше страниц, иногда Гугл. Как считаете, стоит ли обращать на это внимание или нет?

Раньше, в одной из статей, кажется даже у вас, видел замечание про это, но сегодня его не смог найти. Потому задаю вопрос.

Это все из-за того, что количество страниц у гугла считается включая дополнительные результаты (suplemental, так называемые "сопли"). Так что обычно разница идет в сторону Гугла.

Сильно страшного в этом ничего нет, но лучше когда количество страниц отличается не более чем в 2 раза, что говорит о хорошей структуре сайта и отсутствии лишних дублирующих страниц и прочего мусора.

Хотел уточнить вот по какому вопросу. Накупил я ссылок, прошло уже 1,5 месяца. Хотел плагинов Винка проверить купленные ссылки на проиндексированность в гугле и Яндексе. То есть проиндексировали ли их поисковики или не. Нажимаю на YL и GL и безрезультатно — ничего не происходит. Появляется табличка "Начинаем проверку GL " и сразу же появляется "Првоерка GL завершается. Отмечено ссылок: 0". Почему плагин не проверяет? Может я делаю что-то не так?

Только что проверил у себя. Все отлично работает и проверяется. Версия Firefox 8.0, версия плагина 2.18.

Вы уверены, что в списке у вас все ссылки не отмечены галочками и заданы правильные параметры в пункте "Проверять ссылки старше" настроек плагина?

У меня была версия 2.16.2, давно не обновлял. Обновил версию и теперь работает. Спасибо.

Кстати, подскажите, как часто по Вашему мнению стоит проверять ссылки на проиндексированность? И какое значение стоит ставить в поле "Проверять ссылки старше"? У меня сейчас 40 стоит.

Стоит ли активизировать параметр "Отмечать только если ссылки или страницы нет в индексе более"? Сейчас у меня указано 10 дней. Спасибо.

И еще забыл спросить у Вас, если ссылка уже месяц проиндексирована только одно поисковой системой, то стоит ждать или ее нужно сразу же удалить?

Я последнее время мало работаю с Сапой, и ссылки проверяю вообще раз в месяц. Могу точно сказать, что параметр "Проверять ссылки старше" у меня стоит на 50 дней. Это для фильтра YL. Даже так я не вижу большого смысла проверять ссылки на индексацию чаще 1-2 раз в месяц.

Проверять же страницы на индексацию можно каждый апдейт, а можно через апдейт, второй вариант будет надежнее.

Настройкой "Отмечать только если ссылки или страницы нет в индексе более" я ни разу не пользовался :( Но настройка в 10 дней мне кажется вполне логичной.

Ссылки на индексацию я проверяю только по Яндексу, Гугл более лоялен к таким вещам, да и ориентируемся мы в основном на продвижение в Яндексе. Если же продвигаем под Гугл, то надо тогда проверять на индексацию именно там.

Сколько по Вашему опыту нужно ссылок чтобы вывести в топ средне частотный запрос (1000—2000 запросов мес.) с средней конкуренцией? Хотя бы ориентир в цифрах какой-то. Спасибо

Если хотите примерно и в цифрах, то предположим такой диапазон от 100 до 10000р.

Почему такой разлет? Потому что не частотностью определяется запрос, а конкуренцией в ТОПе за него.

Но, думаю, если быть более точным, то 1000—2000 хватит ;)

Да меня не сумма, а количество ссылок интересует :)

Так сколько же все таки ссылок в среднем? :)

Штук 100-150 должно хватить за глаза ;)

Привет, было интересно почитать по правильной закупке постовых в ротапост. Сможешь написать об этом?

Да, а мне было бы интересно об этом написать, я уже не один раз обещал это сделать, притом уже очень давно, но, как видите, так руки и не дошли :( Когда-нибудь это случится наконец!

Добрый день, Александр!

Вопрос по окончательной проверке на прочность купленных ссылок.

Я смотрю список уже купленных ссылок и оказывается, что Сапа показывает страшные вещи для некоторых, например, вот так:

Я: [0] G: [34900]

Я так понимаю, по мнению Сапе, Яндекс не должен знать про этот сайт вообще. Но проверку YAL и YAP эта ссылка проходит! Как же так!? Отказываться от таких или держать? Сейчас у меня каждую неделю по пять подобных ссылок в проекте.

Заранее спасибо за ответ.

Ну для таких ситуаций можно сперва все прогонять фильтром H. Он как раз обновляет индекс страниц для площадок. Вот если после этого фильтра будут где-то нули, то таким площадкам прямая дорога в ГБЛ.

Опечатка в предложении «То есть мы будем отвечать сайты». Вместо «отВечать» надо «отМечать».

Спасибо большое, исправил.